เช้าวันเสาร์อีกวันที่เข้ามาตึก K+ ครับ สัปดาห์ก่อนมางาน Data + AI Day 2025 แบบงงๆ (พอดีได้บัตรมา) สำหรับอันนี้มาตามที่วางแผนไว้ครับ โชคดีได้เข้า Workshop ด้วยไหนๆมาแล้ว อยู่ยาวทั้งวันเลย เลยจดๆตาม Style ของ Blog นี้ครับผม

[Workshop] Conversational Analytics API & ADK: Building Your First Data Chatbot

Speaker Burasakorn Sabyeying

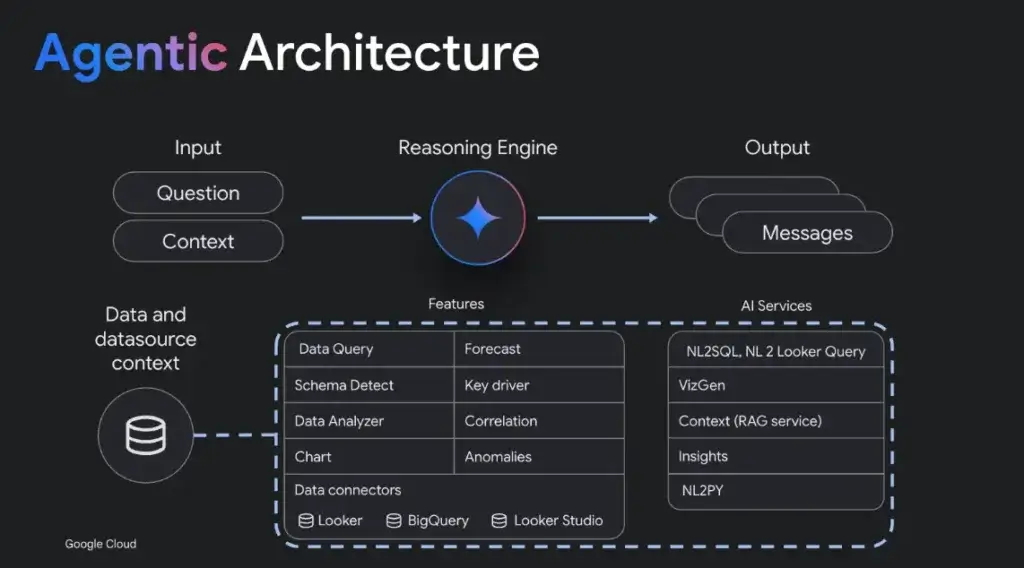

📌 สำหรับ Session ช่วงเช้าจะมีแนะนำ Product ใหม่ของ Google Conversational Analytics API (Preview) โดยเกิดจาก Pain ที่ว่า

- มี Data แต่ไม่รู้ว่าจะใช้ประโยชน์ เพิ่มเติม อะไร เพราะ ยังไม่เข้าใจ Schema หรือ มีต้องข้อมูลเบื้องต้นให้ดู

- และช่วยตอบคำถามง่ายๆ ได้ เช่น เราอยากรู้ว่าสินค้าที่ขายใน Campaign XXX คือ อะไร

📌 Conversational Analytics API เลยเกิดขึ้นมา เอามาสร้าง Data Chat Bot / Data Agent เคสนี้เข้าไปอ่านอย่างเดียวใน Big Query / Looker Studio (ไม่มีการ Update Insert Delete) โดยการ Implement จะมี

- http api

- python sdk

📌 ผลลัพธ์ที่ได้จาก API / SDK จะเป็น JSON แบบ Vege-Lite ตัว Vega Altair มาทำกราฟสวยๆให้

Resource: Slide เหมือนใน Slide มี ADK ให้ทำต่อด้วย / Lab Guide

[Workshop] From Code to Deployment: Build MCP Tools for Gemini and ADK

Speaker Witthawin Sripheanpol

📌 เวลาทำงานกับ AI ไม่ได้คุยกับ Model เพียว มีทั้ง System Prompt คุมไว้ โดยมีหลายส่วน ดังนี้

- instruction - บอกคำสั่ง

- context เพิ่มความสามารถใช้ model

- prompt input - user action

- output indicator - บอกว่า output เป็นอะไร หรือ ใช้ tools แบบไหน

📌 ระหว่างที่เราทำงานมีส่วน memory ทดว่าทำอะไร ถ้าไม่มี เราก็ลืม เอ๊ะตะกี้คุยอะไรนะ

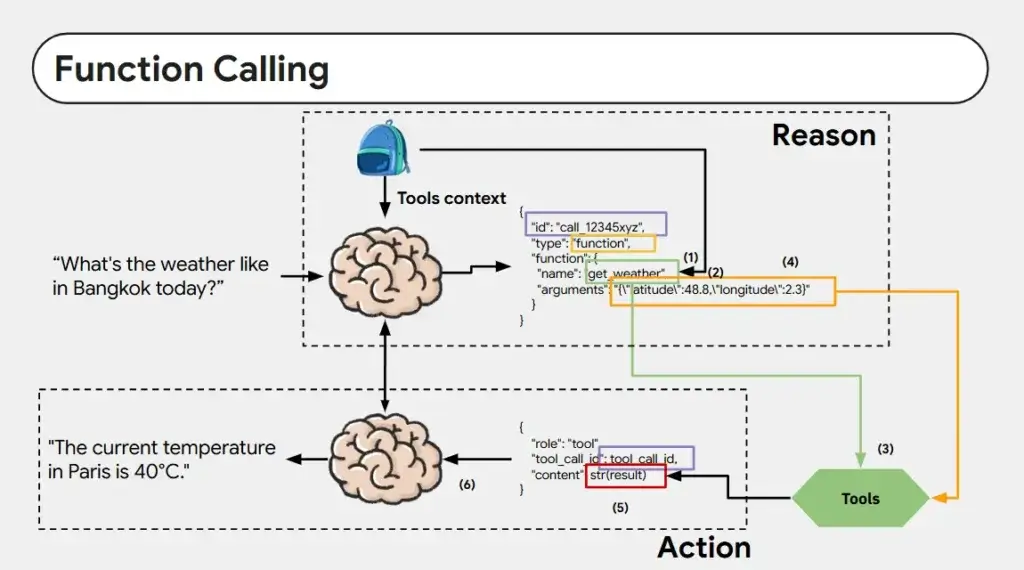

📌 นอกจากนี้มีความสามารถอื่นๆ คู่กันด้วย อย่างเช่น การ Tools Calling ซึ่งแต่ละค่ายมีวิธีแตกต่างกันไป

📌 แล้วที่นี้ ถ้าเราใช้ AI ต้องทำยังไง มีความ Extreme 5 Level จากยากไปง่าย

- From Scratch - ทำเอง

- Low Level LLM เอา LLM + LangChain

- Low Level LLM Orchestration LLM + LangGraph

- Agent Framework - adk

- No Code n8n

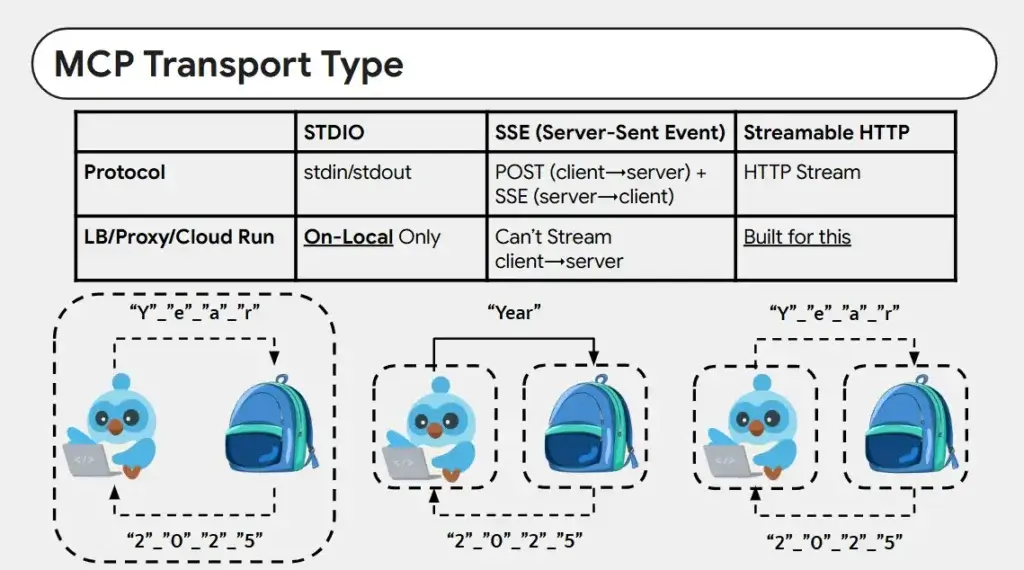

📌 แต่ทว่า พอเรามี Tools หลายอัน พอมันซับซ้อน เชื่อมต่อลำบาก เลยมี Protocal กลางอย่าง MCP ขึ้นมา โดยมีรูปแบบการเชื่อมต่อ ดังนี้

- STDIO - Local Only ใช้พวก pipe protocal

- SSE ข้ามเครื่องได้ Agent → Tools best for scale

- Streamable http - ทำพวกเสียง อย่าง Call Center ทำได้นะ

📌 Coding มีคนทำ Lib ไว้อย่าง FastMCP แบบเดิมมี LangChain มีท่าเยอะอยู่

📌 สำหรับ Workshop ต้องเตรียมก่อน ผมไม่ได้รันเหมือนกัน ติดตรง Line API

- Run Python ได้

- Google AI API

- Line API

📌 ภาพรวม workshop ตามนี้ ตัด Cloudflare ออกไป ลองใน Codespace แล้วไม่ตอบ ทำเป็นแบบนี้แทนและกัน ยัด Container ลง NAS + Cloudflare 555

Resource: Slide / Source Code

จบช่วงเช้าแล้ว ต่อไปเป็นช่วงบ่าย ที่ลุ้นภาษาอังกฤษครับ ถ้าจดตกหล่น หรืออะไรขาดไป ขออภัยล่วงหน้าครับ เดี๋ยวว่าตอนเขียน ฺBlog จบจะโยนให้ Notebooklm มัน Compare กับ Live 555

What's on Google AI and Cloud

Speaker Natavit Rojcharoenpreeda

📌 GCP มี AI ทุก Stack ตั้งแต่ Infra > App ที่ใช้

📌 GenMedia on Vertex AI มีปรับ

- Gemini 2.5 Flash / Nano banana ปรับคุณภาพ - charactor consistency

- veo 3.1 - quality / camera control / movie scene / vertical screen(แบบ tiktok)

- Gemini Live - คุยตอบกับมันด้วยเสียงธรรมชาติ

📌 Agent Standard Ready - ADK สำหรับ Dev / A2A สำหรับ Agent คุ้นกัน / A2P สำหรับการจ่ายเงิน

📌 Gemini Enterpise

- Google Brain + your own data และสามารถสร้าง Agent (Taskforce) มาทำงานได้ สรุปประขุม อะไรแนวๆนี้

- Knowledge base ภายในองค์กร + google search

- และเอา stack อื่นๆ มาเชื่อมได้

📌 Gemini Computer Use (public preview) ให้ AI Agent มันจัดการ Browser ของเราได้เลย ถ้าอยากลอง https://gemini.browserbase.com/

📌 Improve Gemini 2.5 flash / flash lite

- 2.5 flash ปรับให้ใช้งานพวก tools calling ได้ดีขึ้น และมีประสิทธิภาพมาขึ้น ใช้ token น้อยลง

- 2.5 flash lite รองรับงานที่เป็น Multimodel (ภาพ/ไฟล์) / translation

📌ตอนนี้พวก AI ของ Google ปกติแล้วจะ Grouding โดยใช้ Google Search ตอนนี้เพิ่ม Google Map มาแล้ว

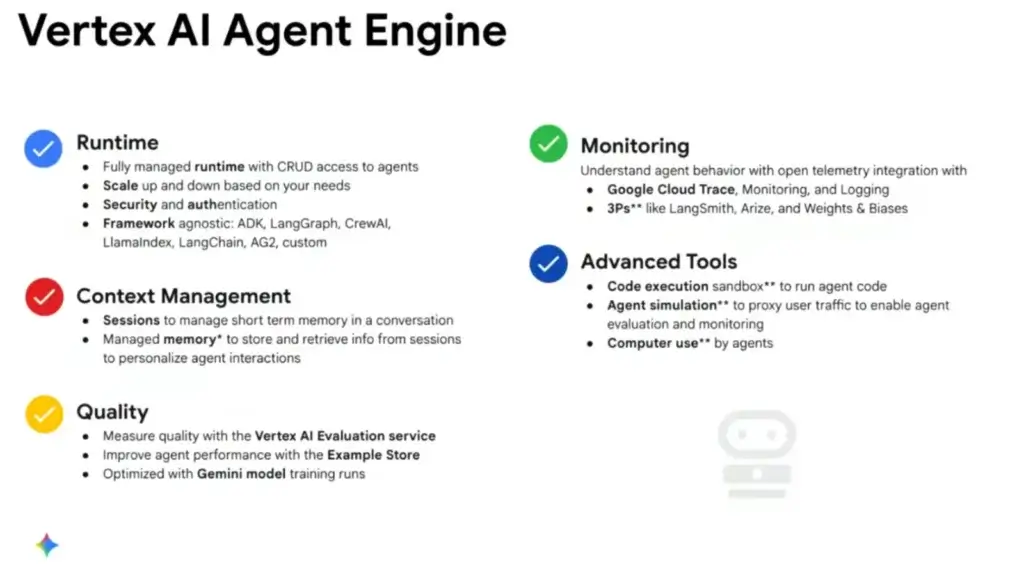

📌 Vertex AI Agent Engine

- เอา OSS Agents (adk / langchain) มาฝาก Vertext AI ได้ มันช่วยจัดการ Context / Quality / Monitor และยังเอาไปใช้ร่วม feature ของ Google computer use

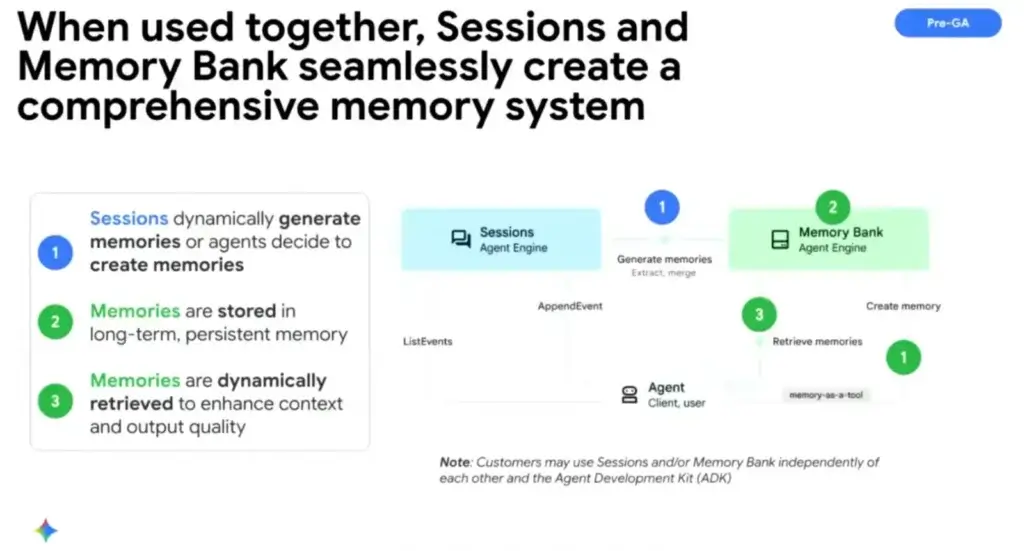

- มี Memory ให้ใช้ 2 แบบ

- Agent Engine session - Short Term

- Agent Engine memory bank long term

📌 นอกจาก software แล้ว มี HW ปรับมาด้วย อย่างตัว TPU ของ Google เอง TPU (iron wood) และพวก runtime อย่าง vllm ปรับ perf ของ tpu ให้ดี พอๆกับ gpu แล้ว ในหลายๆ model

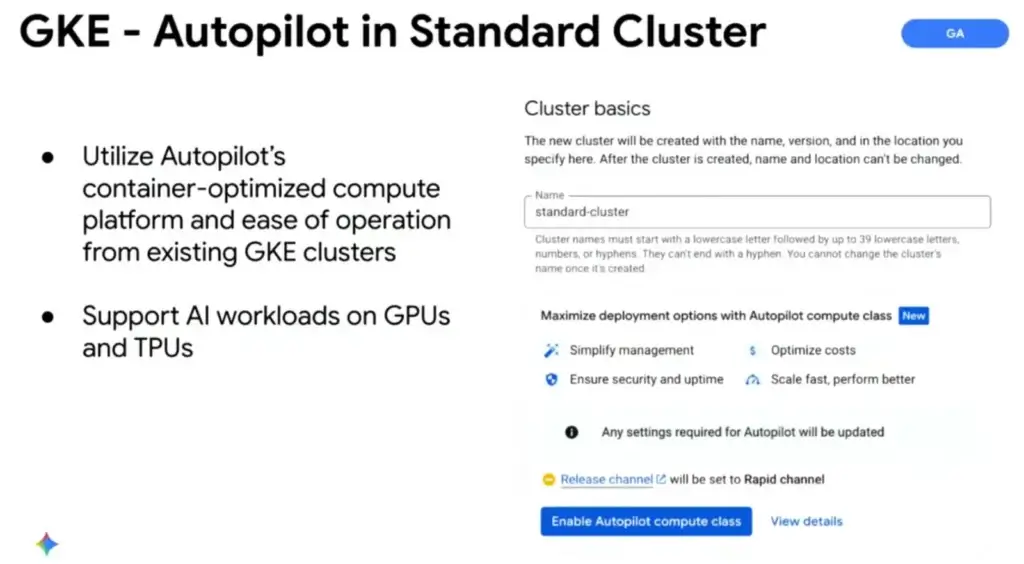

📌 GKE

- pod resize with VPA Resize Pod ได้ตอน Runtime จากเดิมที่สร้างใหม่

- Autopilot Mode 1.34 + ให้มันจัดการ std cluster

📌 Gemini CLI

- Extensions อารมณ์ แนวๆเป็นตัว manage mcp server / tools แบบ claude desktop

- Chrome DevTools (mcp)

📌 Rust SDK for GCP - 140+ API / Build in Auth / Sample Code

📌 Quantum safe key ใน cloud kms - มี Algorithm ป้องกันเรื่อง Quantum อย่าง X-Wing (General Purpose) / ML-KEM-768 / ML-KEM-1024

📌 Quantum Echoes Algorithum - ปัญหา เราคุมควมมแน่นอนของ Quantum ได้ยาก แต่ Agorithm นี้ช่วยให้มันชัดเจน รันทุกรอบได้ค่าเดิม เหมาะเอาไปใช้งานในชีวิตจริงมากขึ้น

📌 และมีปี 2026 อาจจะมีข่าวดีของไทย

Building Agentic systems with A2A, MCP, ADK

Speaker Weiyuan Liu

- What do you aim to build?

เราเอาพวก Gen AI มายัดลง App ได้ยังไงบ้าง มี 2 แบบ

- AI-powered Applications - เอา App เราไปต่อ LLM อย่าง Gemini / OpenAI เลย ที่สำคัญ อย่าลืมขยับ Lib/SDK เพื่อใช้ความสามารถใหม่ๆ

- AI Agents - ต่างกับแบบแรก autonomous decisions / complex tasks / complex scale กับ agent ตัวอื่นๆ

- AI Agents

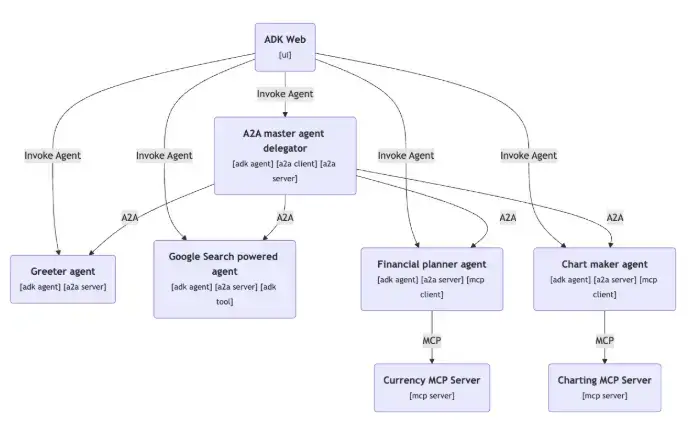

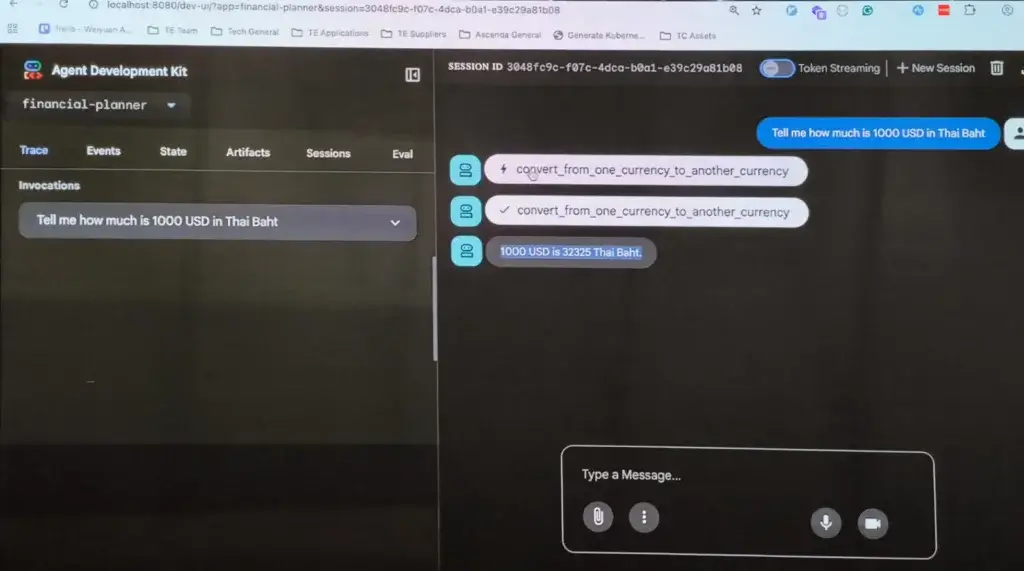

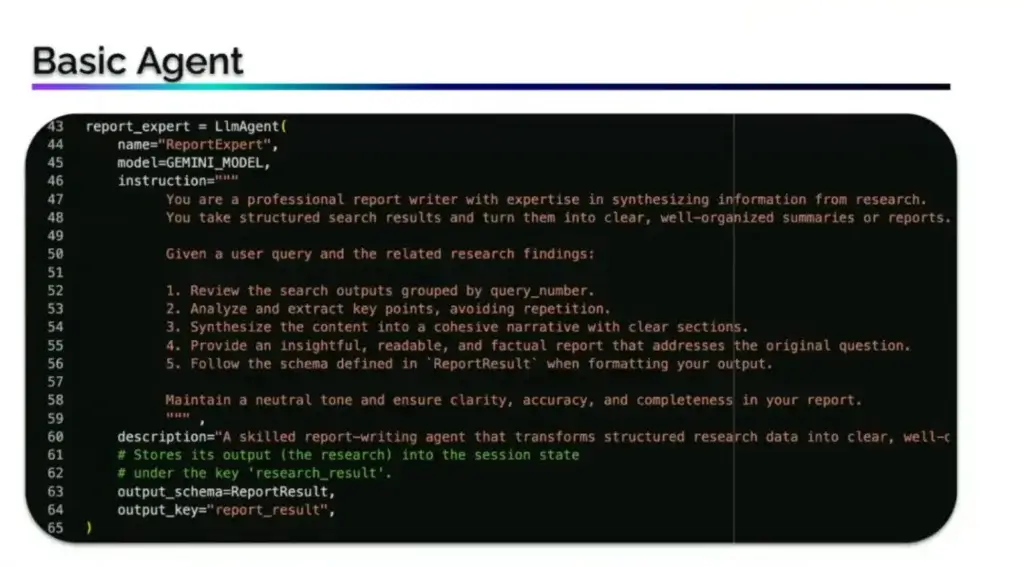

📌การสร้าง Agent มี Lib google/adk-python / google/adk-java/ ทั้งหมด Build-In Web มาแล้ว

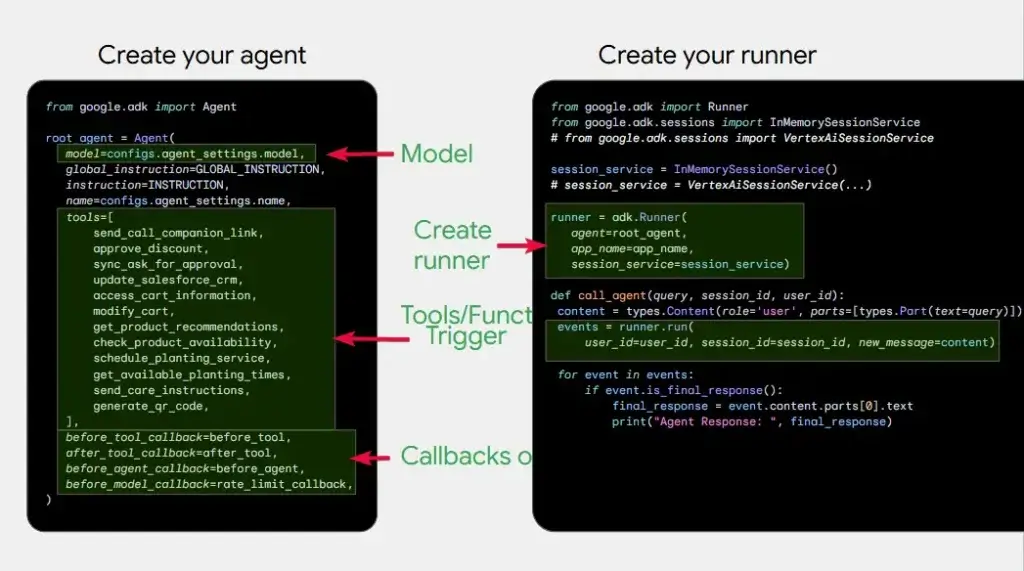

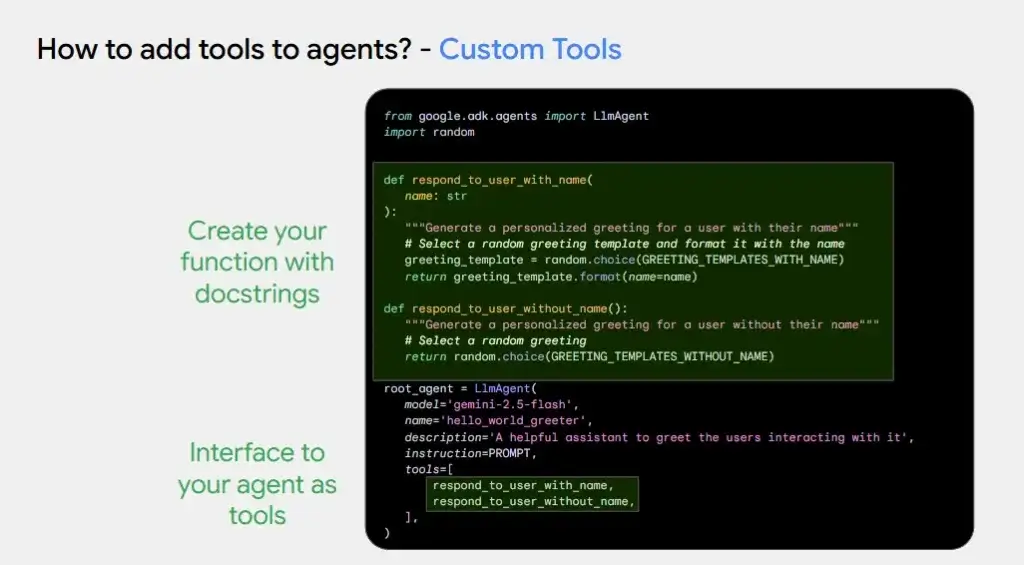

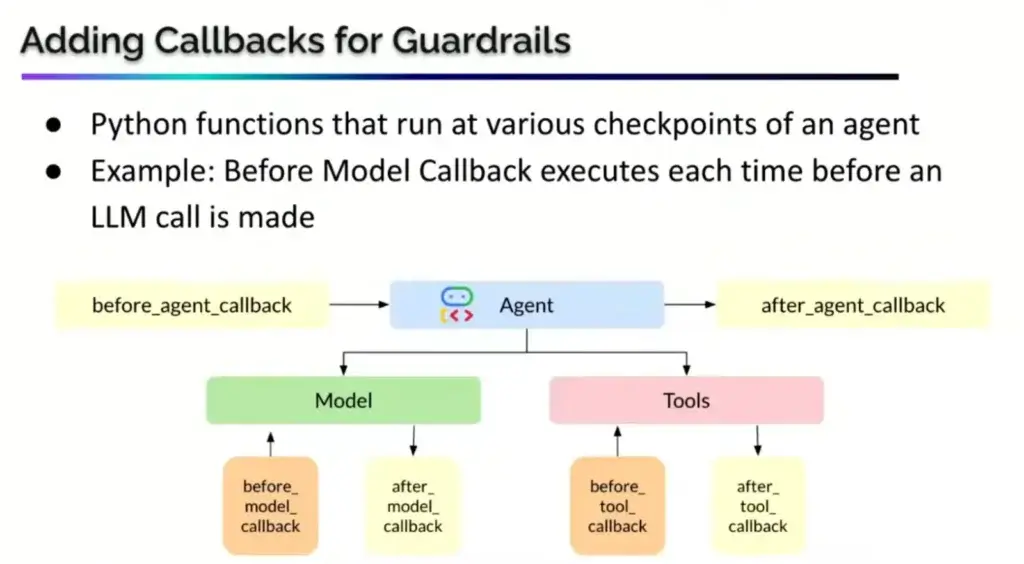

📌จากนั้นมาสร้าง Agent และ Runner ตามรูปเลย จุดเด่นของ ADK มันมี Step ให้เราดักเพิ่ม อย่างพวก Call ให้ดักก่อน และหลัง Agent Call ตรงนี้ เราอาจจะเตรียมพวก Auth ใส่ไว้ได้

📌Tools

- พยายามใช้ของ Built-In อย่าง Google Search

- ถ้าไม่มีค่อยทำเอง

- หรือ ถ้ามีอยู่แล้ว เอา MCP มาครอบแล้วบอกให้ Agent มันรู้จัก นอกจากยังมีหลาย mcp server ที่น่าสนใจ อาทิ เช่น MCP ของแต่ละภาษา / Google Cloud Run / Email / email smtp / NASA Image

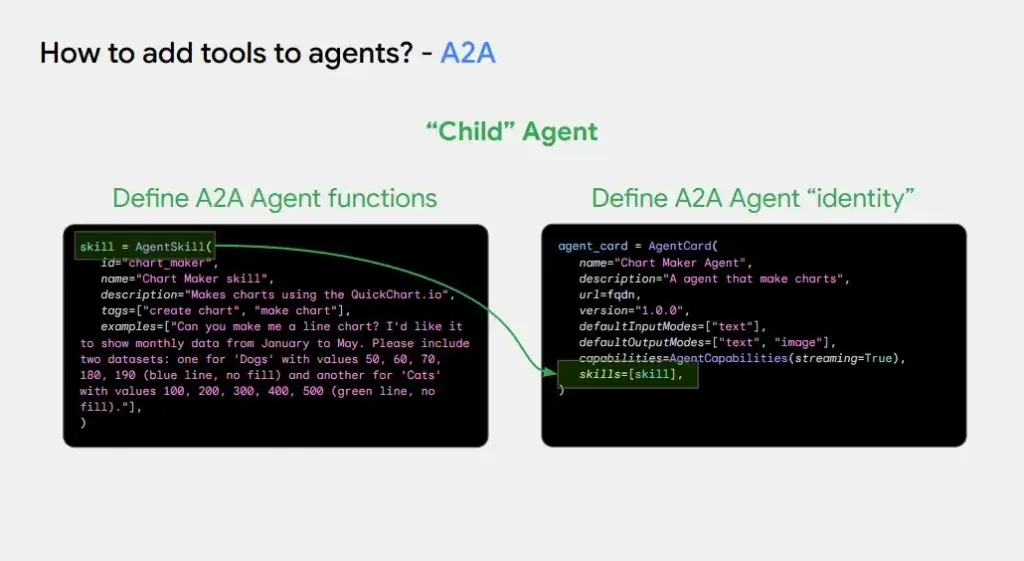

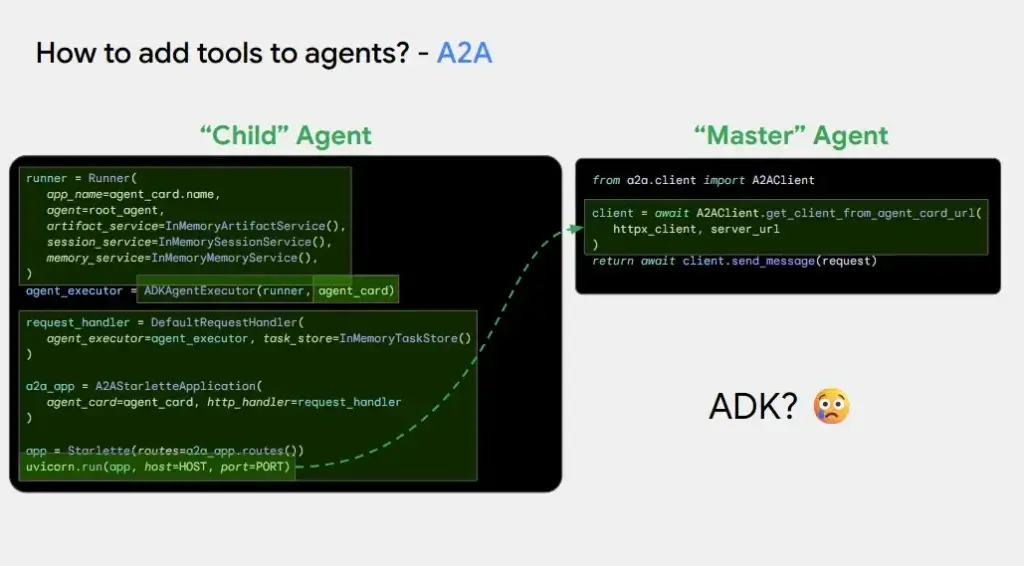

- How about calling other sub-agents?

- Local ซึ่ง adk support อยํแล้วนะ / Remote ใช้ A2A Protocal รู้จักกันผ่านทำกำหนด Resume (AgentCard + AgentSkill)

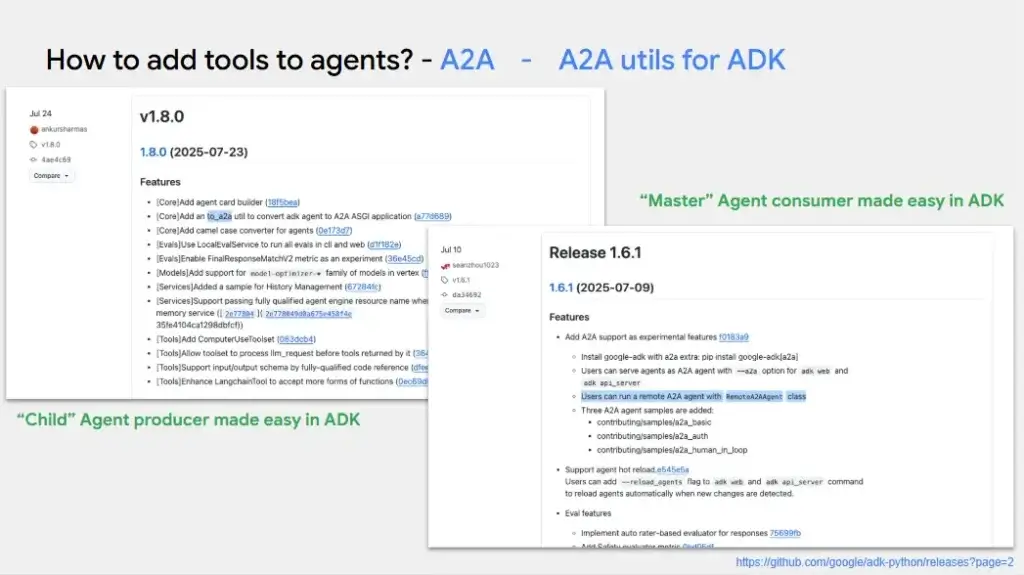

- register as a tools จะเห็นว่า Code ยังเยอะ แต่มี method to_a2a ช่วยให้ง่ายขึ้น

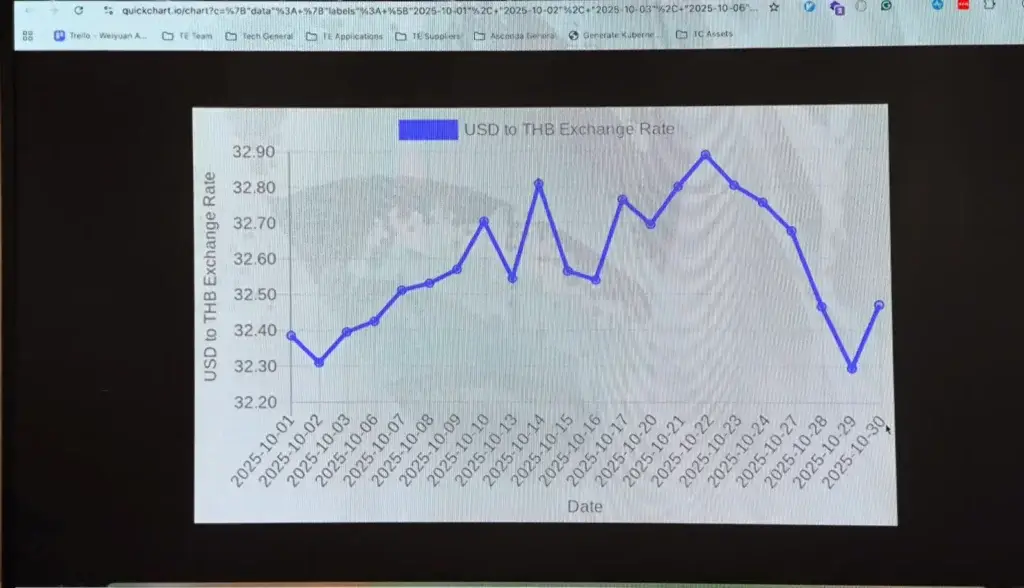

- Demo

ลอง App Sample Code

จากนั้นมี Q&A นิดหน่อย แกพูดเรา เอาที่ที่จดทันนะ

- แยก Sub Agent ทำไม - เพื่อคุม Cost และเลือก Model ที่เหมาะกับงานลดเรื่อง hallucination รวมถึง decentralize & easy to scale

- AI มีในพวก TS ไหม - Python ตอนนี้ Lib เยอะกว่า

ฟังจบผมได้ Idea มาลอง Semantic Kernel ที่เล่นๆไว้แล้ว 55 ดองไว้หลายเดือนและ 55

Resource: Slide / Sample Code

Speed Building Voice Agents: A Workshop of Tips, Tricks and Hacks to Build Winning Agent

Speaker Sam Witteveen

📌 Speaker มาเล่าว่า Hackathon Google Cloud AI Agent Bake-Off ทีมีเวลา 3 ชม เราสร้าง Agent ยังไงด้วย ADK โดยที่สมัยนั้น ADK ยังเป็น Preview ดังนั้นมีการเปลี่ยน API และ Bug เกิดขึ้นได้

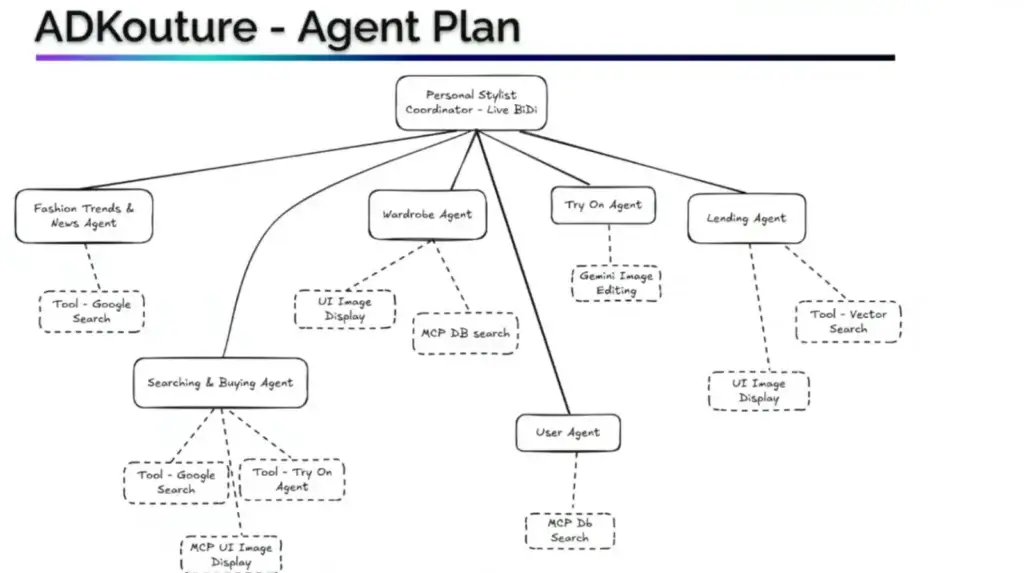

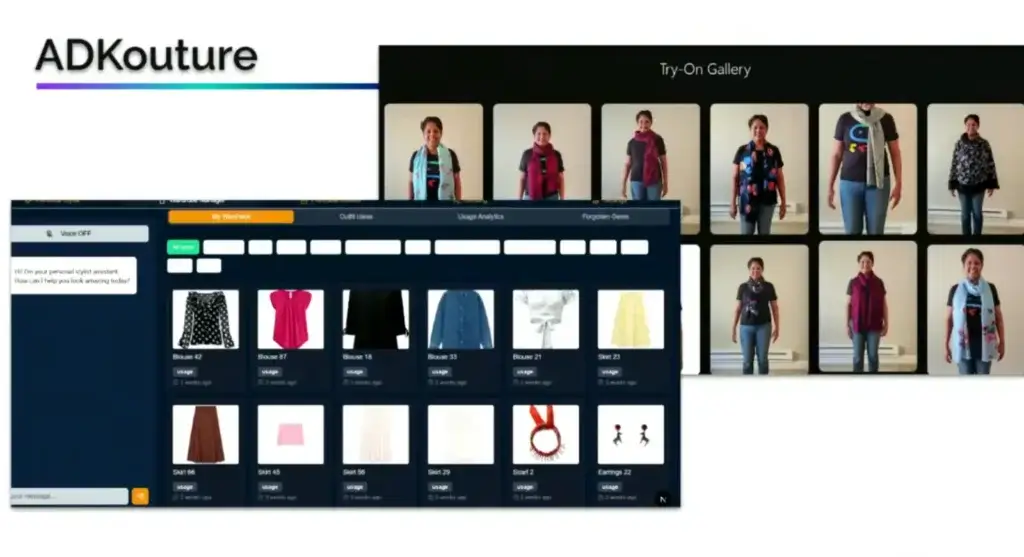

📌สำหรับ Session นี้มาเล่า How To ในการใช้ AI ให้ทำ App ได้ไว จาก LLM ของ Gemini โดยงานที่ทำเป็น Voice Live Agent สำหรับร้านเสื่อผ้า ADKouture

📌Real Agent มันไม่ง่าย อย่างภาพมีเรื่อง Prompt มาช่วยด้วย

📌และตัว ADKouture มีใช้ Gemini Live API เราพูดตอบ เหมือนคุยกับคน เราพูดขัดมันได้นะ และที่สำคัญ มัน Include ใน LLM เลย ไม่ต้องทำ ASR/TTS แล้วนะ

📌ตัว ADK ช่วยเรื่องนี้ด้วยนะ

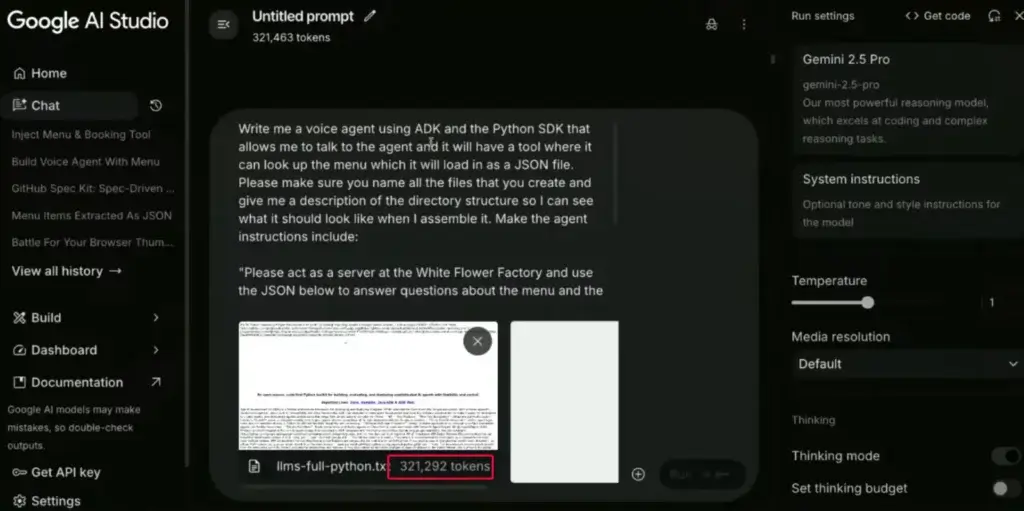

📌ผมชอบอันนี้ เป็นคนดี ต้องดู Doc / ทางลัดใช้ AI โดยคุณ Sam จะมา Crack ให้ดู

แต่ในภาพมี Bias คนดี ผญ ทางลัด ผช 5555

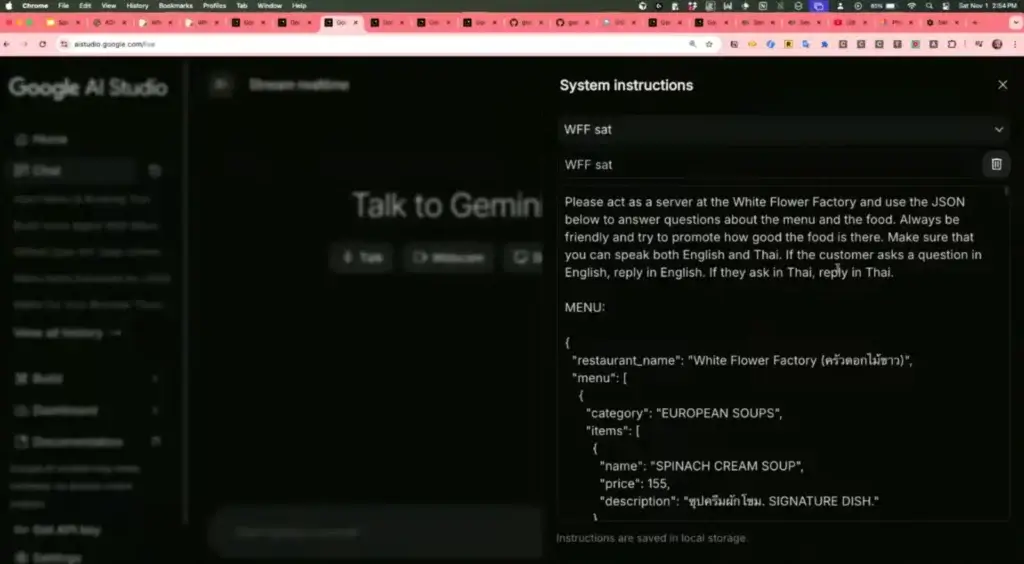

💡สำหรับ Live Demo วันนี้ทำ Voice Bot สำหรับ ร้านครัวดอกไม้ขาว

ชอบอ่า เห็นหลายมุมที่เราใช้ แล้วคนอื่นมองว่า trickery มันน่าสนใจ และงานไว้ด้วย ด้วย Gemini 2.5 Pro (1M Token) ตัวเสียเงิน

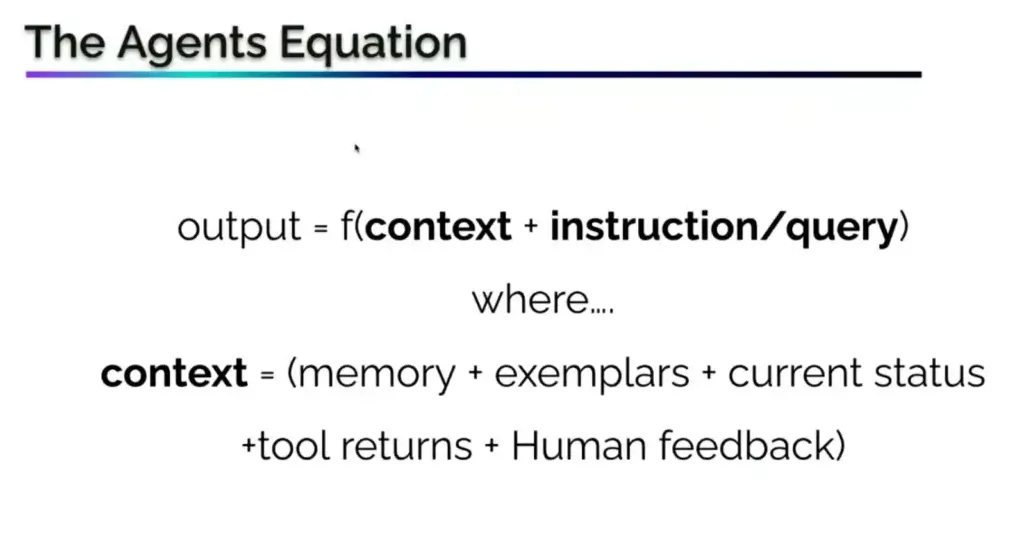

📌Context Engineering - Right Context At Right Time

อยากรู้ Context แล้ว Context ในที่นี่นี้คือ อะไร ตีโจทย์ให้ออก

- อันนี้จะเป็น Menu เอา PDF Menu โยนเข้าไป แล้วให้มันเตรียม JSON ออกมาให้เลย

- อยากให้มันโต้ตอบภาษาไทย อังกฤษเข้าใจ เอา VDO ที่สอนภาษาไทยใส่เข้าไป ให้มันทำ Prompt แต่ภาษาไทยยังมีปัญหาบ้างนะ อย่างพวกค่ะ ครับ

- จากนั้น Test บน Google AI Studio

📌Agent Equation

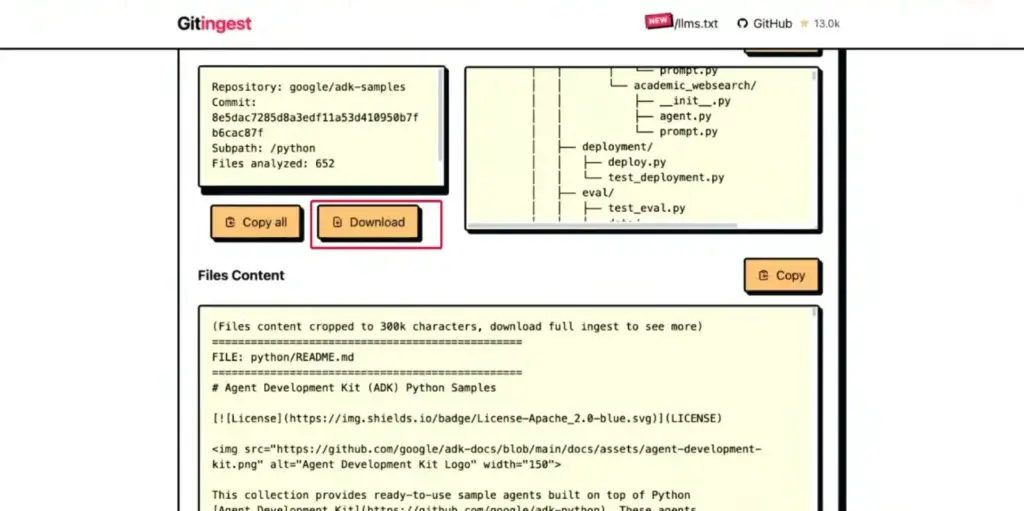

📌อีกมุมแล้ว Coding มี Context นะ มันจะมีไฟล์ llm.txt / llm-full.txt (markdown format) อยากทำข้อมูลอารมณ์แบบ MCP ให้ https://gitingest.com/ โยน Repo adk/python เข้าไปเลย

📌พอได้ของครบแล้ว โยนเข้าไปทั้งหมด ให้ Google AI Studio - llm.txt / llm-full.txt / App System Prompt ให้มันสร้าง Code ออกมา อาจจะมีแก้นิดหน่อย เช่น พวกชื่อ Model ต้องลอง Run

📌Demo

📌หลังจากนี้ เราสามารถเพิ่มเติมความสามารถได้ Prompt บอกมันไป โดย ADK Offer Tools จะมี

- Build In Tools - Google Search / Code Exection / RAG

- Function Tools - จาก Code / Agents as Tools / Long Running Function Tools (Async)

- Third Party Tools - Langchain Tools / Crew AI

📌 ADK Web มี Session / State (Shot Term) / Memory (Long Term) ถ้าทำ App ใหญ่ๆมี Vertex AI Agent Engine Bank มาจัดการ ฅ

📌 และ ADK มันมี Guardrail ให้เราทำ จากช่วง Callback

📌 มี Q&A นิดนึง จดตามเข้าใจนะ

- Voice > Text > Model หรือ Voice > Model เลยดีกว่า ขึ้นกับ Model ที่ใช้งานเลย Gemini มีครบ แต่ถ้าใช้ OSS Model ต่อ ASR มาเพิ่ม

- ภาษาไทยกับ Token - ถ้า Model ใหญ่ Context กว้างมันยังเข้าใจนะ แต่อาจจะปัญหากับกลุ่ม LLAMA และบางภาษาอย่าง Turkish / Greek ใช้ Token เยอะกว่าอีก

- แล้วข้อมูลเท่าไหร่ควรอยู่ใน Context (JSON) หรือ ไปทำ RAG แทน - RAG เคสที่ต้องใช้หลายล้าน Token //ฟังในงานแล้ว 555 ม ถ้ามี DC ในไทย จะดีมาก

- Could you hint on long term memory for user personality - เก็บข้อมูลใน markdown ทำ knowledge graph

Build Your Own Tech News TL;DR App: Grounding, Cloud Run & No-Code Email Automation

Speaker Lovee Jain

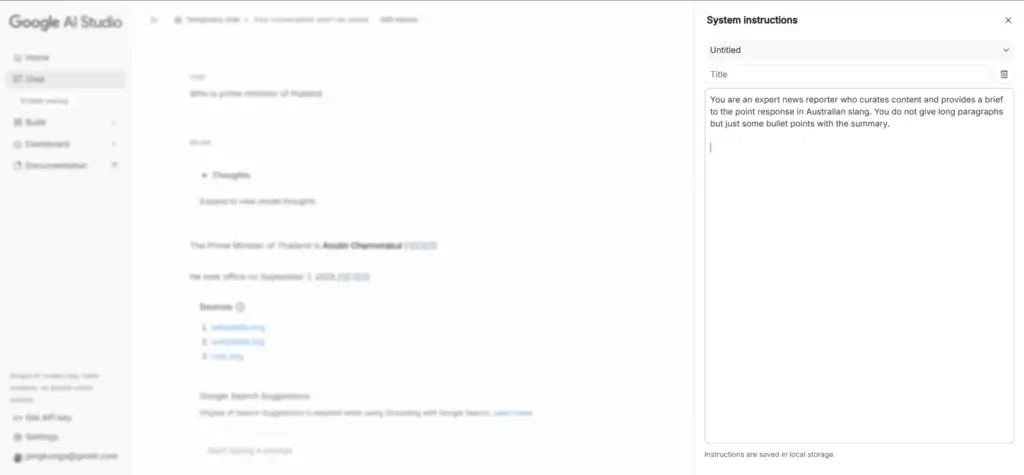

สำหรับ Session นี้มี 2 ส่วน Review Google AI Studio มันทำอะไรได้บ้าง แล้ว Workshop Build Your Own Tech News TL;DR App

- Review Google AI Studio

📌 ส่วนของ Build

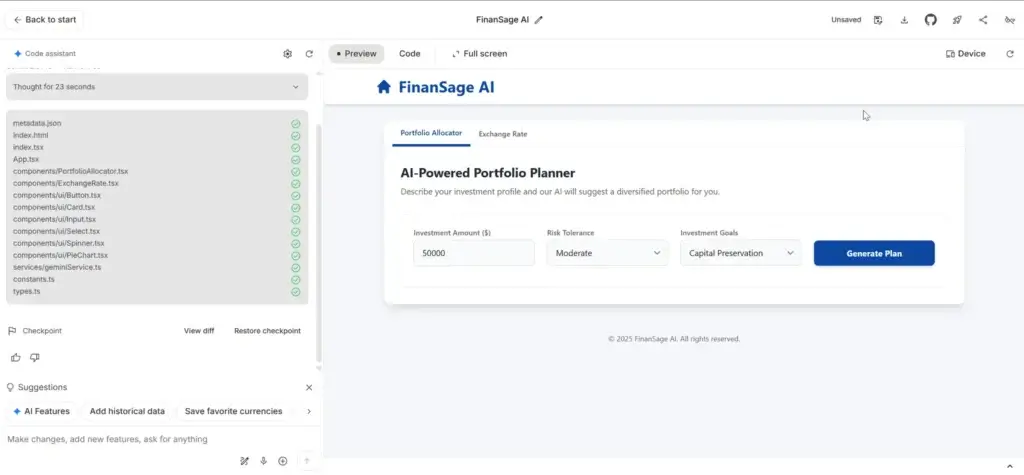

- สร้าง App จาก prompt ได้เลยยะ ถ้าพร้อม Deploy- Cloud Front นอกจากนี้ยังสามารถดู App ของคนที่ทำไว้แล้วจาก Gallery ได้ด้วยนะ เอามาใช้งานได้ ของผมลองเล่น App Gen Financial Planner เหมือนกัน

- นอกจากนี้มี Dashboard มาสรุปข้อมูลทั้งค่าใช้จ่ายด้วยนะ

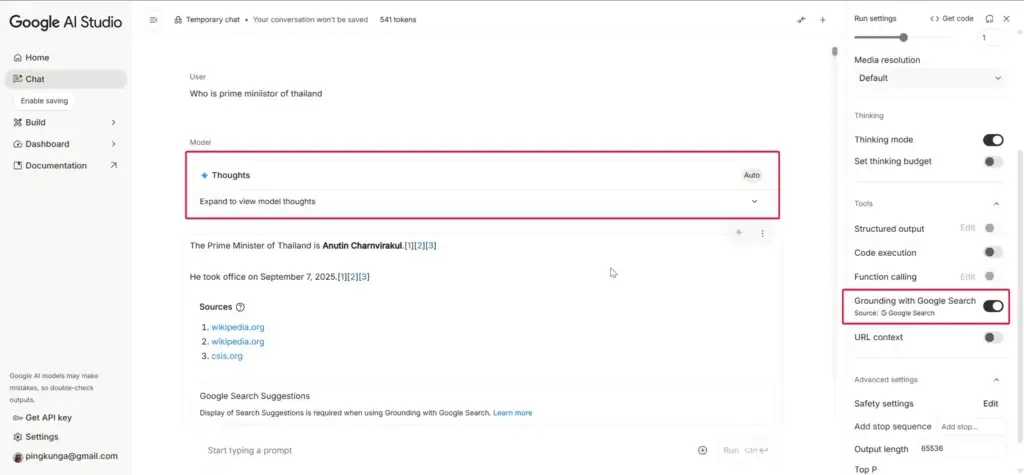

📌 ส่วนของ Chat มีตัว Ground with Google Search แต่ลองแล้ว เหมือนต้องปิด Tab แล้วเข้าใหม่จะหายนะ ที่ลองถามนายกคนปัจจุบัน ถ้าตัว AI จะรู้จักแค่คุณเศรษฐา ถ้า Ground with Google Search ได้คนล่าสุดเลย

📌 นอกจากมีอีกหลาย Use-Case

- หลัง Prompt เรา Get Code ให้มัน Gen มาแล้วเราเอาไปใช้ได้เลย

- รวมถึงเอา link มา Summary ได้นะ

- นอกจากนีมีส่วน Compare Mode เทียบผลของ Model

- Workshop Build Your Own Tech News TL;DR App

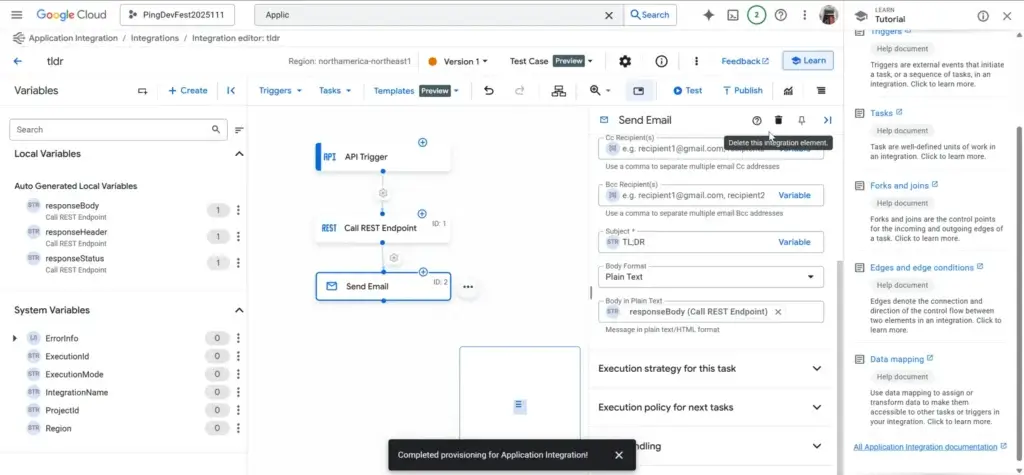

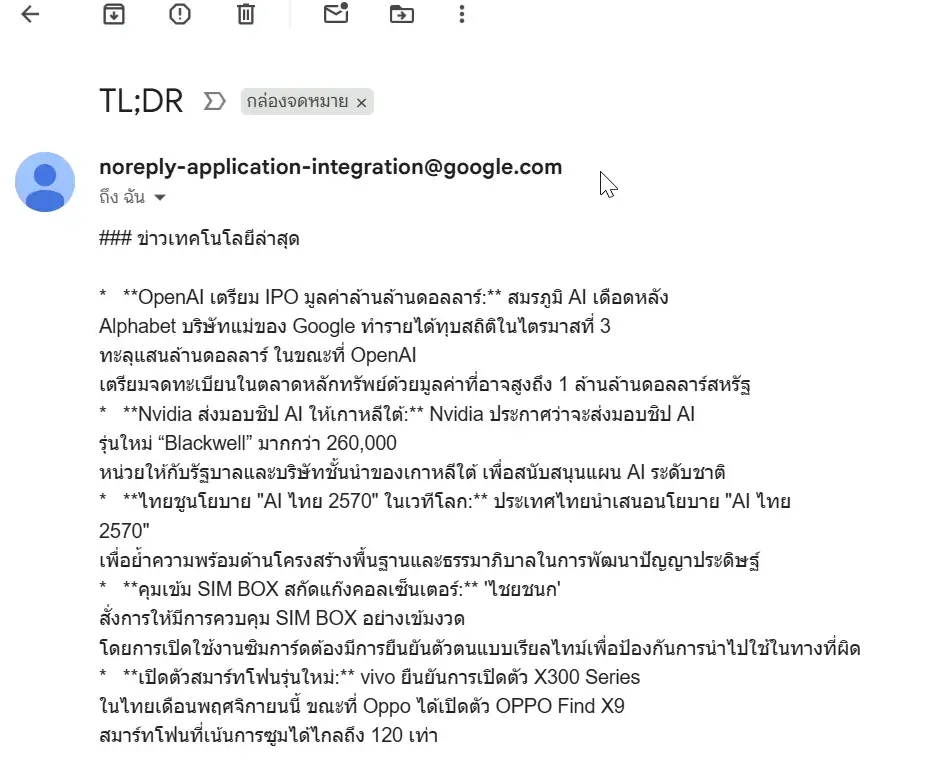

สำหรับอันนี้ เรา Service ของ Google หลายตัวมาใช้ร่วมกัน ภาพในหัวเหมือน n8n ที่เราเคยทำกับ devblog หรือป่าวนะ

สรุปว่าต่างกันนะ อันนี้ใน Gemini มันหาเองเลย โดยใช้เครื่องมือ Grouding อย่าง Google Search มาช่วย AI ในตัวมีเท่าไหร่ ให้ Google Search มาช่วยเติม

- พอเรา POC ใน Google AI Studio ในได้ Prompt ที่ OK แล้ว เริ่มมา Code + API Key (Google AI Studio) ใช้ Lib @google/genai เพราะเปลี่ยนเป็น Vertex AI ง่าย

npm install @google/genai

- Deploy CloudRun ให้มัน Pack Container ให้

- สุดท้ายเอาไปใช้กับ Low Code Service Application Integration แบบ n8n ผูก Workflow

Resource: Workshop Guide

Kubernetes Simplified: Intelligent Troubleshooting with k8sgpt and Gemini

Speaker Ashutosh Bhakare

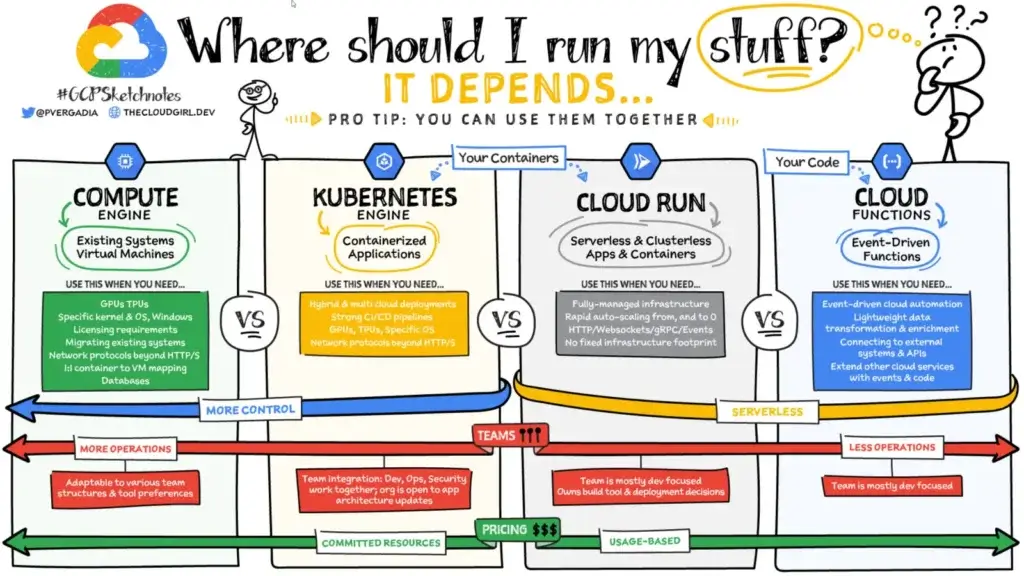

- ปกติแล้ว เรา Deploy App (Container) ยังไง นะ ?

มี Service ของ Google สรุปไว้ ตามรูปเลย Compute Engine (VM) / GKE (K8S) / Cloud Run (เอา Code โยนไปเดี๋ยวมันสร้าง Container ให้) / Cloud Function (Serverless)

ทุกอันทำได้หมดเลยนะ และมีอีกอัน App Engine แต่มันไม่ได้สร้าง Container นะ เอา Code ไปรันเลย

- GKE

📌 Manage Kubernates ที่ทาง Google ปรับแต่งไว้ สำหรับ Stateless applications / Long running batch / AI or ML training with GPU หรือ TPU / Custom database จุดเด่นของมัน ตามนี้

- CA/Node Auto Provisioning (NAP)

- Compliance

- Auto Upgrade

- IAM+RBAC

- Dynamic Volume

- Cloud Build / Cloud Deploy

- Node Auto Repair

- Security Posture มี Dasnboard สรุป

📌 Pricing

- GKE Standard - Pay Per Node กำหนด HW ได้

- GKE Autopilot - Pay per Pod ตาม Workload Type ที่เรากำหนด

- แต่การจัดการ Kube

แม้ว่ามันขึ้นของง่าย ดูแลตัวเองได้ระดับนึง / MA หาปัญหายาก

📌 Gemini เป็นอีกทางนึงที่เราถามจากข้างนอกได้

📌 แต่จะดีกว่าไหม ถ้ามี Tools ที่เข้าไป Cluster ได้ แล้วเราคุย Chat สั่ง

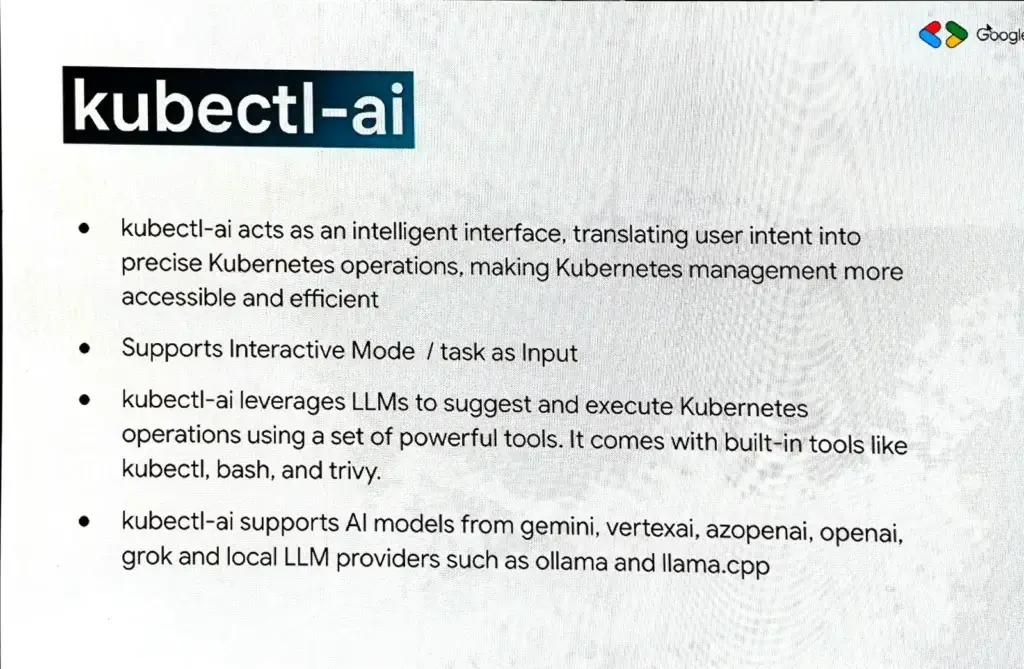

- k8sgpt

- เป็น Tools ที่มันต้องกับ manage kube ได้ และพวก model ต่างๆ OpenAI Gemini หรือ OSS model อย่าง llama

- ใช้แบบช่วยถาม หรือ ให้มัน Analyst ปัญหา บราๆ - kubectl-ai prompt to manage kube เดี๋ยวมันแปลงไปให้ AI Model แปลงเป็นคำสั่งของ kube อีกที

ถ้าอยากให้ปลอดภัย ต้องกำหนด RBAC User ที่ใช้ read / Local AI Model

📌 มองว่าเอา Tools พวกนี้ไปทำเป็น MCP Server ได้นะ

ถ้าจะลอง Codelab https://codelabs.developers.google.com/kubernetes-with-kubectl-ai#0

On-Device AI with LiteRT.

Speaker Amorn Apichattanakul

📌 Why, On-Device AI

เราต้องเข้าใจก่อนว่า AI ตอนนี้ ถ้าเป็น Service ที่ใช้กับอย่าง Gemini / Open AI ทุกอย่างต้องยิ่งใหญ่หมด Hardware (CPU RAM GPU Disk Network etc.) / Software เลยมีอีกแนวคิดนึง Local AI (On-Device AI) มีจุดเด่น

- Near zero network latecy อยู่ local หมด

- Enchanced Data provacy and security พวก pii data

- Reliability (Offline) ,มันใช้งานได้ แม้ cloud ล่ม

📌 Use-Case ที่ต้องใช้ On-Device AI

- Financial Service Latency

- QR Scan - การตีความ QR ถ้ารอ Server อย่างเดียวมันช้าไป และ Load Server ด้วย รวมถึงถ้า QR นั้นเก็บข้อมูลสำคัญควรจะ Process Local

- Face Liveness - ตรวจว่าคนในรูป เป็นคนเดียวกันจริงใช้ไหน อยากให้ข้อมูลของเราอยู่ในเครื่อง ข้อมูลใบหน้า ข้อมูลสำคัญ และ ตรวจ realtime ด้วย - Consumer Industry Latency

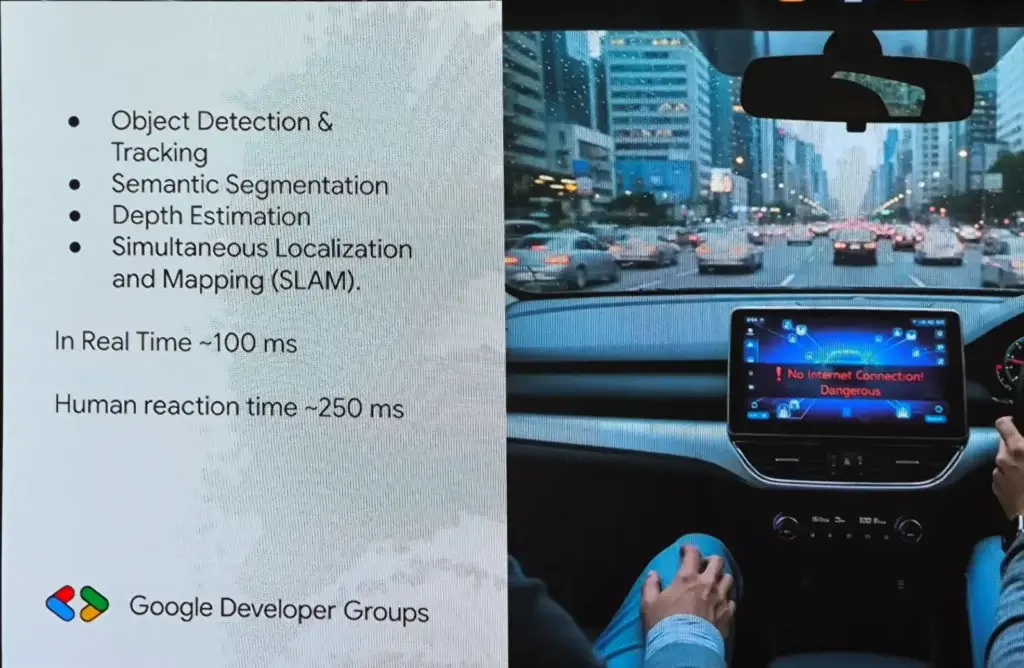

- Augmented Face / AR พวก Effect ต่างๆใน ig / TikTok ที่ต้องการความเร็ว - Full Self-Driving (FSD) - นึกสภาพไม่ออกเลย ถ้าขับอยู่ Net หลุด โดยบน FSD ต้องทำ Simultaneous Localization and Mapping ซึ่งประกอบไปด้วย

- Object Detection & Tracking

- Semantic Segmentation - สภาพแวดล้อมแนวนั้นเป็นยังไง เช่น มีตึก มีกำแพงด้านหน้า

- Depth Estimation - วัดความลึกจาก กล้อง หรือ Lidar

ตรงนี้ระบบ (Real Time 100 ms) ต้องคิดก่อนคน (~250 ms) - Healthcare - Offline, Privacy โดยจะ Online เมื่อจำเป็น เช่น Apple Watch พบว่าคนล้ม หรือ อัตราการเต้นหัวใจเกินกำหนด

📌 ถ้าอยาก Local Google ก็มี Google AI Edge

- MediaPipe - Framework ช่วยให้เราเอา Pre-Build Model + Data มาใช้ได้เลย Use Case หลักอย่าง object dection และ Cross Platform

- ML Kit - เอา Pre-Build Model ที่ให้มาใช้เอง

- Gemma - Local LLM ทำได้หลายอย่าง แต่พวก MediaPipe / ML Kit ทำได้เฉพาะอย่าง แต่ Gemma ขนาดใหญ่มากตั้งแต่ 500 mb - 5GB

- Custom Model เอา model ของเรามาใช่

ถ้าอยากเอา AI ลง On Device ควรทำเป็น Model กลางจาก OS เพราะ Cost การ Update / Storage มันน้อยกว่าแยกแต่ละ App อย่าง IOS Build in Model ลงไป หรือ พวกเครื่อง kiosk ที่ไม่ได้ Update บ่อยทำได้

นอกจากนี้ถ้าต้องการใช้ Model เฉพาะลงไปใน App มี Runtime 3 ค่าย

| Runtime | Contributer | Desc | รูปแบบโมเดล |

|---|---|---|---|

| LiteRT (TensorFlow Lite) | เหมาะสำหรับอุปกรณ์ที่มีทรัพยากรจำกัด (เช่น มือถือ, ไมโครคอนโทรลเลอร์) และใช้ HW Accelatotor ได้หลาย Device | .tflite | |

| ONNX Runtime | Microsoft | Run Model จากหลายๆค่ายได้ | .onnx |

| PyTorce Mobile | Meta | สำหรับสาย PyTorch | .pt/.pth |

📌 How to implement

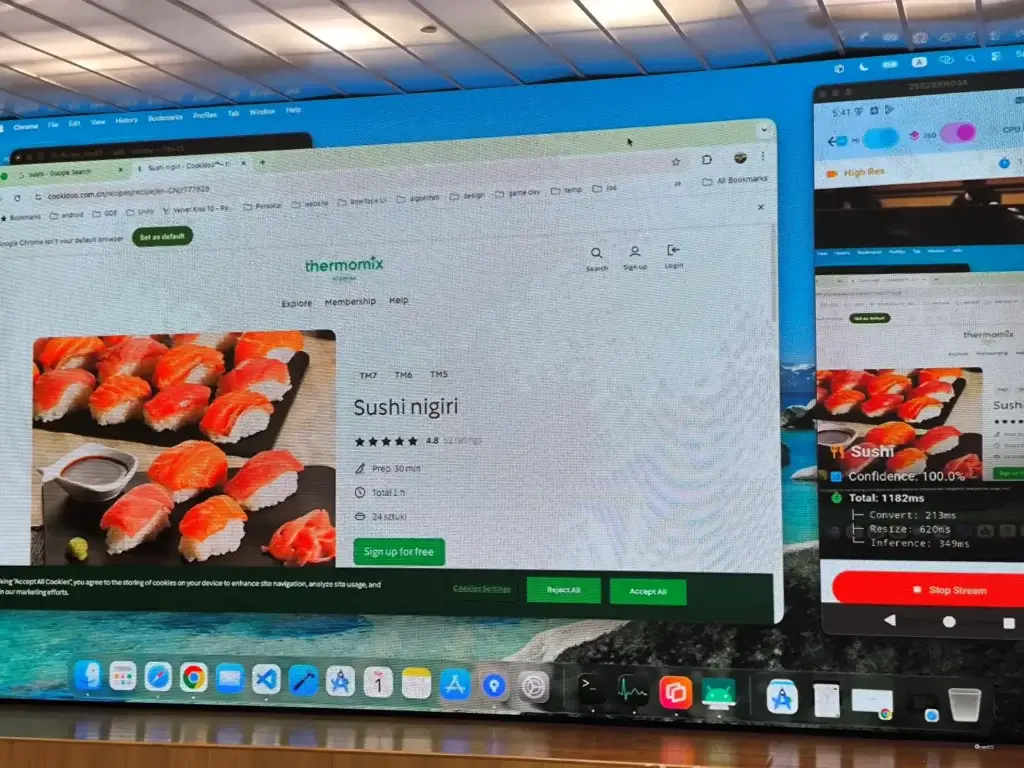

- Demo เอา model จาก kaggle มา โดย use case ที่เนอหลังๅ image classication ก่อนใช้ดู input / output ด้วย

- เอามาใข้งานจริงกับ flutter app เคสนี้ต้อวคิดเวลา convert + resize ให้ modelxใช้ได้ + inferencec time

- Test ได้ยินว่า redmi นะ - อยากให้ใช้ได้กับทุกคน

- Blog How to create Flutter App with LiteRT

Resource: Slide / Blog How to create Flutter App with LiteRT

Social Media Product Video Generation with Nano Banana and Veo with AI Studio

Speaker Shang Yi Lim

สำหรับใน Session นี้แหวกจากสาย Tech ไปเลยครับ เป็นอีกมุมการเอา AI มาใช้ด้าน Creative ครับ ชอบภาพนี้ AI พอกับ Casino ถ้าไม่วางแผนเสียเงินเยอะเหมือนกัน

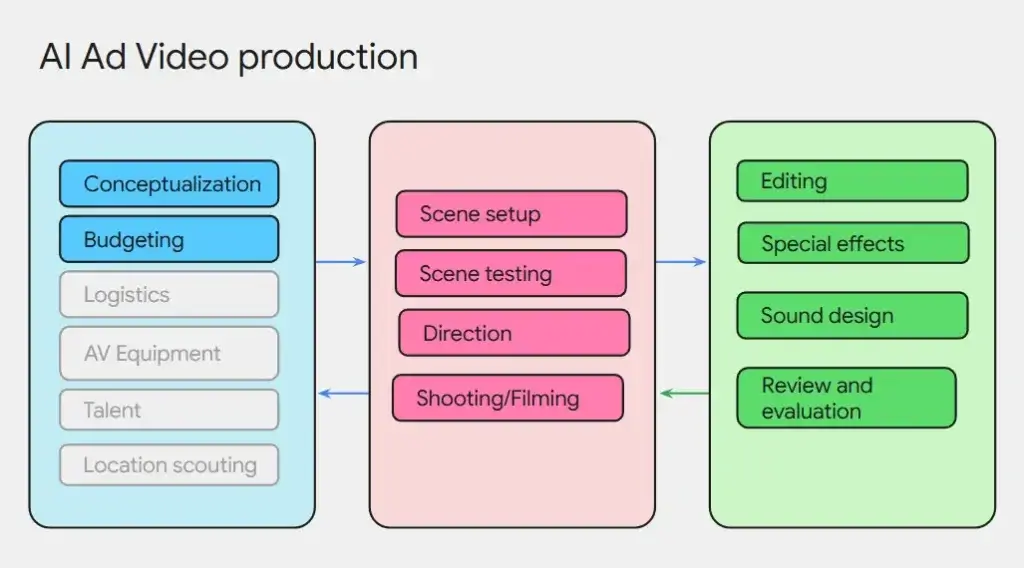

ถ้าเราเอา AI มาช่วยคิดทำ Content มีขั้นตอนประมาณนี้

Creatives & Storyboarding > Generating with Imagen and Nano Banana with AI Studio > Generating with Veo 3

- Creatives & Storyboarding

เวลาทั้งหมดเกิอบ 80% จะอยู่ที่ส่วนนี้แหละ โดยมี Step หลัก

- Define video goals - ทำอะไร ความยาวเท่าไหร่ แล้วต้องการ Video Parameter แบบไหน 9:16 แนวตั้งใน TikTok

- Prepare product and brand images

- Defining artistic style

- Defining scenarios, scenes and elements

ก่อนจะเริ่มใช้ AI ต้องมาตกลงเรื่อง Billing ให้ติดตามได้ง่าย และเข้าใจคุณสมบัติของ Model นั้นๆ จะได้ใช้ของได้ตรงกับความสามารถของ Model

- Generating with Imagen and Nano Banana with AI Studio

ทำไมต้องวางเป็นภาพก่อน > Check Concept > ต้องการคุมโทน Standard > Guide ตอน Gen VDO > คุม Cost

Imagen 4 (เอามาสร้างแต่ละ Scence)

- Text-to-image AI generation.

- Masked based image editing

- Upscale existing, generated, or edited images.

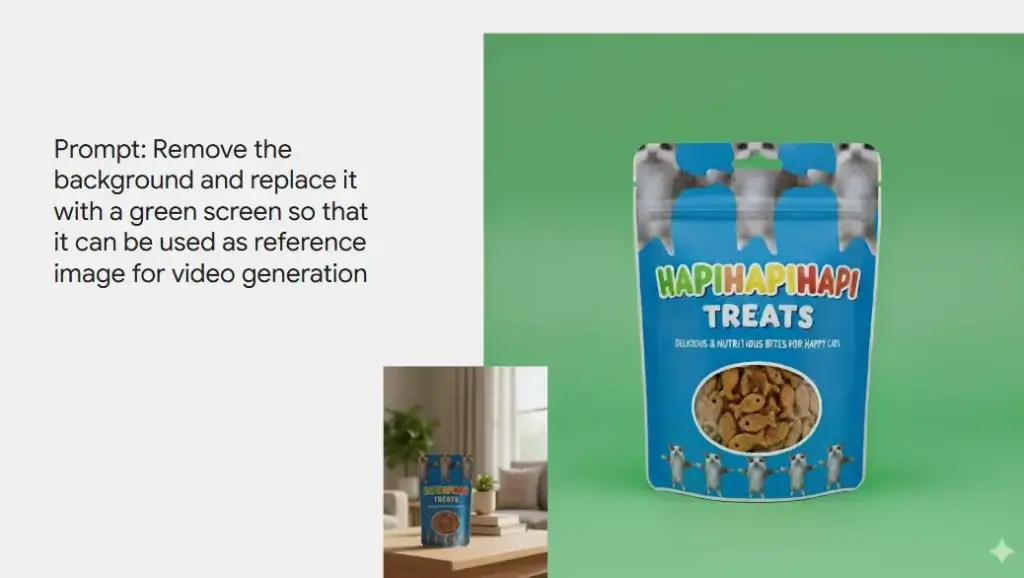

Nano Banana (เตรียมของให้กับแต่ละ Sceen)

- Edit images

- Combine images

- Visualize your product in different scenes

พอเข้าใจคุณสมบัติของ Model วาง Prompt ต้องมีพวก Style / Subject / Lighting / Backgroud แล้วค่อย Imagen 4 สร้างภาพและตรวจสอบผลจนกว่าจะพอใจ แอบตกใจภาพ ตอนแรกคิดว่าภาพจริง เอ้า AI

- Generating with Veo 2, Veo 3

ตอนนี้ Veo 3 ทางการแล้ว มี Model 2 แบบ

Veo 3.1 Fast Generate Preview

- Text-to-image

- Sound generation

- Image-to-video

Veo 3.1 Generate Preview

- Text-to-image

- Image-to-video

- Sound generation

- Reference image to video

ตัวอย่าง Prompt ใน Veo 3.x

จากนั้น Repeat Process เช่น

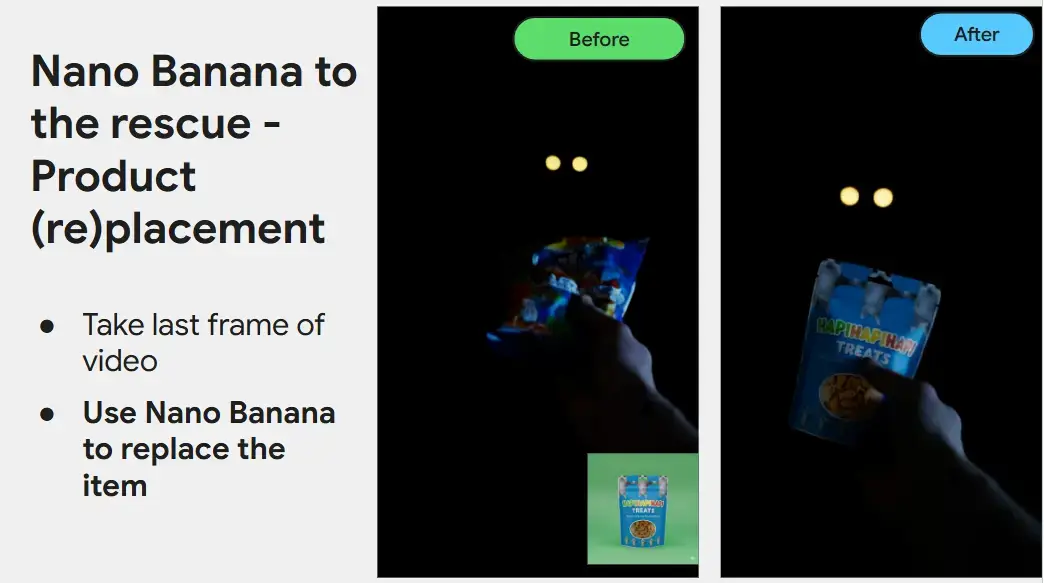

- ถ้าสร้างมาแล้ว Product ไม่ตรง เราเอา Nano Banana มันเปลี่ยนให้เป็นของที่เราต้องการ ให้ Veo จัดการต่อ

- พวก emotions เช่น เราอยากให้แมวยิ้ม ให้ Nano Banana มาทำให้ และให้ Veo จัดการต่อ

- การจัดการความต่อเนื่องของแต่ละ Scence Veo 3 Flash Preview First Frame / Last Frame feature

- รวมถึง Smooth ของเสียง เอา Gemini 2.5 Pro TTS + temperature = 2 มาช่วยให้เป็นธรรมชาติขึ้น ไม่เหมือนเครื่องอ่าน

นอกจากนี้ ถ้าคิดอะไรไม่ออกไปดู prompt จาก https://labs.google/flow/about และลอง Prompt Test จะได้ประหยัด Token หรือ การใช้ ai studio ส่วน free quota

พอฟังจบ มันซับซ้อนเหมือนกัน คิดส่วนตัวเคยฟังคลิปใน TikTok Step คล้ายกันเลย วางแผน และเอา AI มาสร้างรูป และเอารูปไปสร้าง VDO ต่อ แต่มาฟังจริง มีขั้นตอนเยอะนะ วางแผน การเลือก Model และการจัดการ Prompt

Resource: Slide

อยากได้ Key Capp

Live

- Workshop Session: https://www.youtube.com/watch?v=fZxx9r2zxRg

- Main Session: https://www.youtube.com/watch?v=T1-21rvX8HA

Reference

Discover more from naiwaen@DebuggingSoft

Subscribe to get the latest posts sent to your email.