วันนี้กลับมางานในฝั่ง Google ครับ ผมน่าจะไปครั้งสุดท้ายตอนปี 2016 เห็นมันจัดใกล้แถว BTS วงเวียนใหญ่ พอดีเข้ามาทำงานช่วงเช้า บ่ายๆ ก็เลยลองมาฟังครับ หัวข้อที่จดๆในงาน มีตามนี้ครับ

Table of Contents

Spark the Next Big Thing: AI at Google Cloud Next '2025

Speaker Virot Chiraphadhanakul

ใน Session นี้ Speaker มา Recap จากงาน Google Cloud Next'25 (Las Vegas) โดยงานนี้สองมุม

📌 มุมของผู้บริหาร ไปเพื่อที่จะได้เห็นภาพว่าของที่กำลังจะลงทุน มันเอามาใช้งาน เพิ่มโอกาสทางธุรกิจยังไง มีเล่า Use Case โดยมี Blog สรุปว่าแต่ละองค์กรเค้าเอา AI ไป Adapt ยังไง

📌 และส่วนของ Tech ครับ

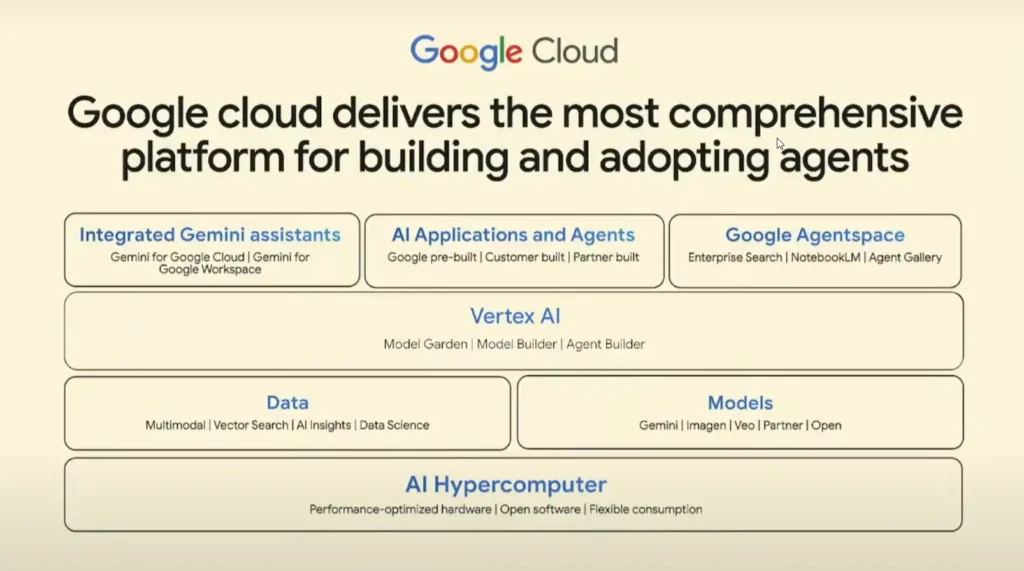

ปีนี้เน้นส่วน Agents เลย โดย Cloud ของ Google มีความพร้อม 4 ด้าน

📌 AI Hypercomputer - ส่วน Infra ที่มี Data Center + ออกแบบชิป TPU เอง

📌 Research & Models - อย่าง LLM มาจาก Research ของ Google - Attention is All You Need (ลองหาตามมีด้วย)

📌 Vertex AI เป็น Machine Learning Platform + AI Backend + Model อย่าง Gemini ด้วย

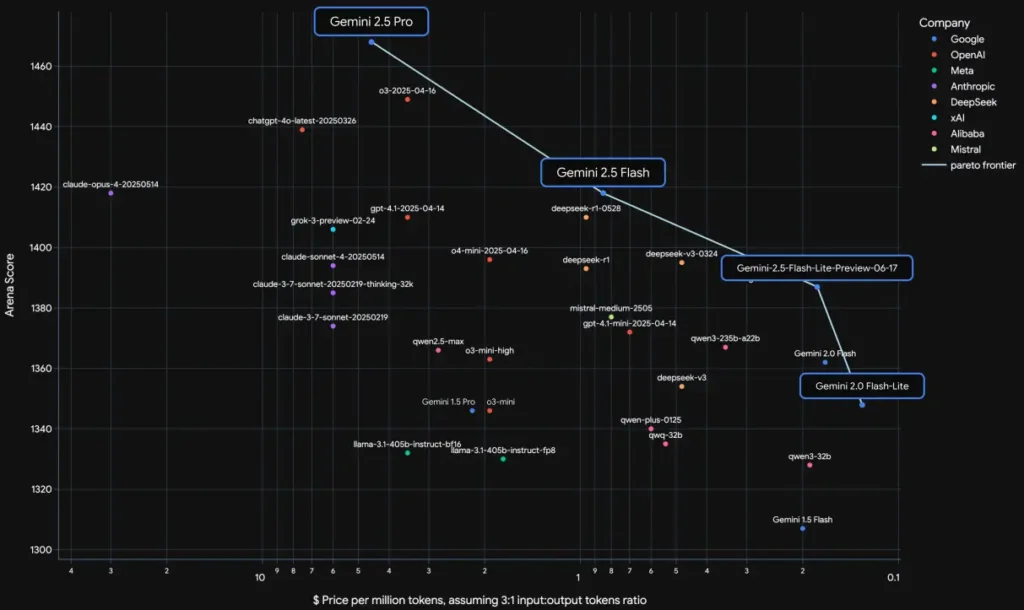

- ตอนนี้ Gemini 2.5 จะได้คะแนนดีที่สุดใน Benchmark ในส่วนของ chatbot arena / Humanity’s Last Exam และของ LLM Performance on Thai O-NET Tests (ของคุณไท)

- Gemini 2.5 มีหลายรุ่นนะ

- Pro ตัวใหญ่ Quality + Thinking Model + Reasoning

- Flash ตัวเล็ก มี Thinking + Reasoning มาให้ด้วย และมี Cost ที่คุ้มกว่าเจ้าอื่นๆ (อิงจาก LLM Performance on Thai O-NET Tests + ภาพด้านล่าง

การเลือกใช้ Model ต้อง Balance Cost / Quality / Speed กันนะ (สามเหลี่ยม PM) โดยเจ้า Gemini 2.5

- เรากำหนดได้นะ Mode

- Thinking Budget เท่าไหร่ ?

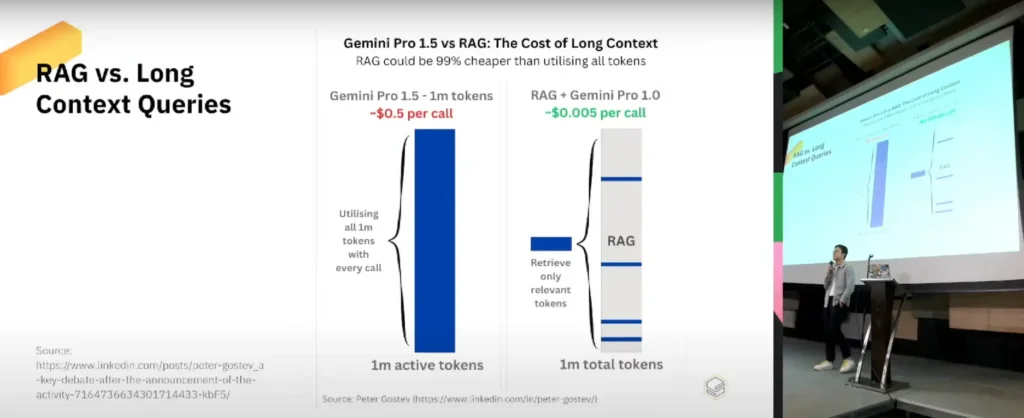

- นอกจากนี้แล้ว แม้ว่า AI มี Context Windows เยอะมาก อย่าง Gemini ได้ 1 ล้าน Token ทำได้

- มันเก่งขึ้นจริง แต่ Cost จะเพิ่มขึ้นด้วย

- แต่มีหลายเทคนิคมาช่วย เช่น การทำ RAG มาช่วย เอาที่เกี่ยวมาให้ AI คิด จะลด Cost ได้ชัดเจนเลย

Basic: การทำ Word Embedding เป็นพื้นฐานของ RAG ดูจากได้ https://medium.com/@hari4om/word-embedding-d816f643140

- LIVE API - โต้ตอบ

- Use Case เช่น งานSupport มีเล่า Demo Shoptify พอ Model มันเป็น Multi-Model มันจะเห็นภาพScreen / เสียง ทำให้เข้าใจ Context มากขึ้น และพูดคุย เอาข้อมูลทั้งหมดมาแนะนำเราได้

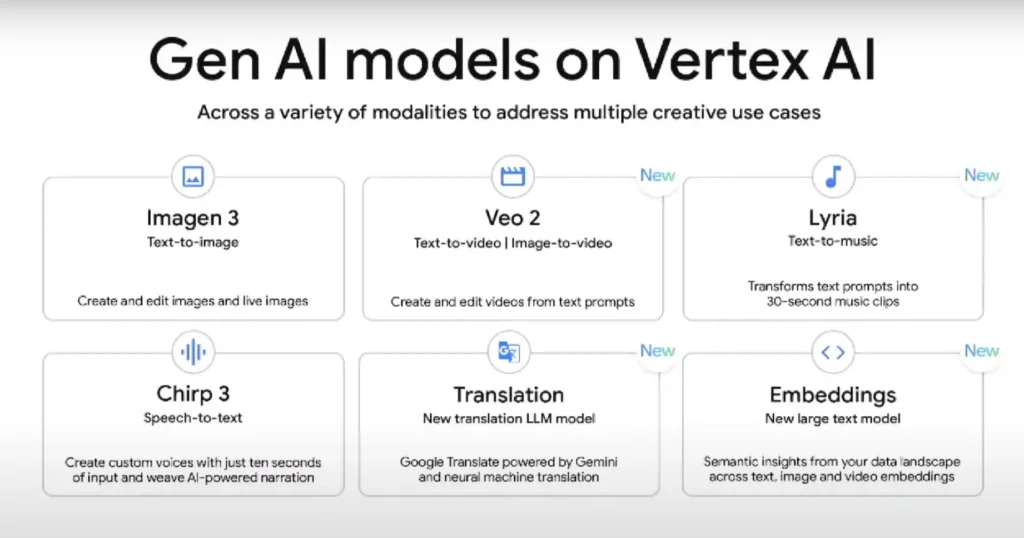

- ส่วนงาน Dev โดยจากเดิมการยิง API จะเป็นใช้ Web Socket นะ - นอกจากมีเปิดตัว Model ต่างครบทุกด้านทั้ง Text / ภาพ / เสียง / VDO

- Translation ปรับปรุงการแปล.

- Lyira - Text to Music

- Veo3 - Generate Video+เสียง //ตอนนี้เห็นเต็ม TikTok

- ตัว Embedding ที่ช่วยให้เข้าใจมากขึ้น มี Sematic Insight จะตีความคำว่าแมว / ภาพแมว / เสียงแมว / clipแมว มันทำ Vector มาอยู่ในระนาบเดียวกัน มองว่ามันเป็น แมว ได้แล้วนั่นเอง หรือ รููปแมว กับสุนัข และบ้าน จะแยกกลุ่มได้ชัดเจน อย่างสัดว์เลี้ยง กับ สิ่งก่อสร้าง

- Use Case ของ Etsy เอา AI Model ด้าน Media มาช่วยแนะนำสินค้าเป็นอย่างไร

- อีก Use Case เคสเอา Gemini ทำ Story Board และเอา VEO3 มาสร้าง Vdo เสียงพากย์ หรือจะสั่งจากเสียงใช้ Chirp 3 ลองทำได้จาก Google AI Studio (แต่ใช้เงินเยอะ แต่ถูกกว่ายกกองไปถ่ายจริงๆ)

ยังมีส่วนของ Platform

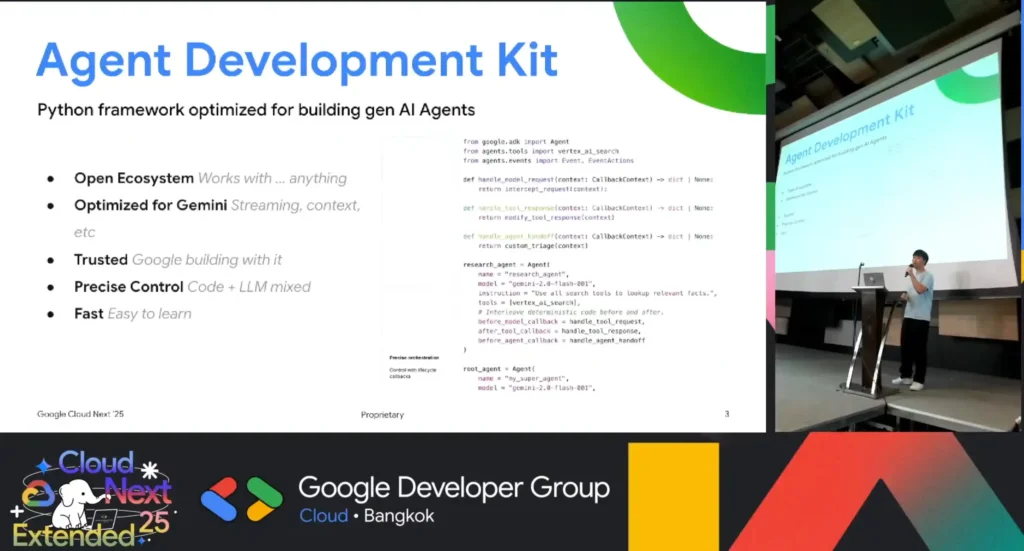

- Vertex AI มีตัว Agent Development Kit มาช่วยเริ่มต้น Dev + Deploy

- Model Garden เป็น Host Model Google / Open Source (Gemma / LLAMA / Deepseek) หรือ ใช้ Model ของค่ายอืน (เช่น Claude) แต่ Infra GCP อารมณ์แบบ Foundry ของอีกค่าย

- Model Builder เราสร้าง Model ใช้เอง

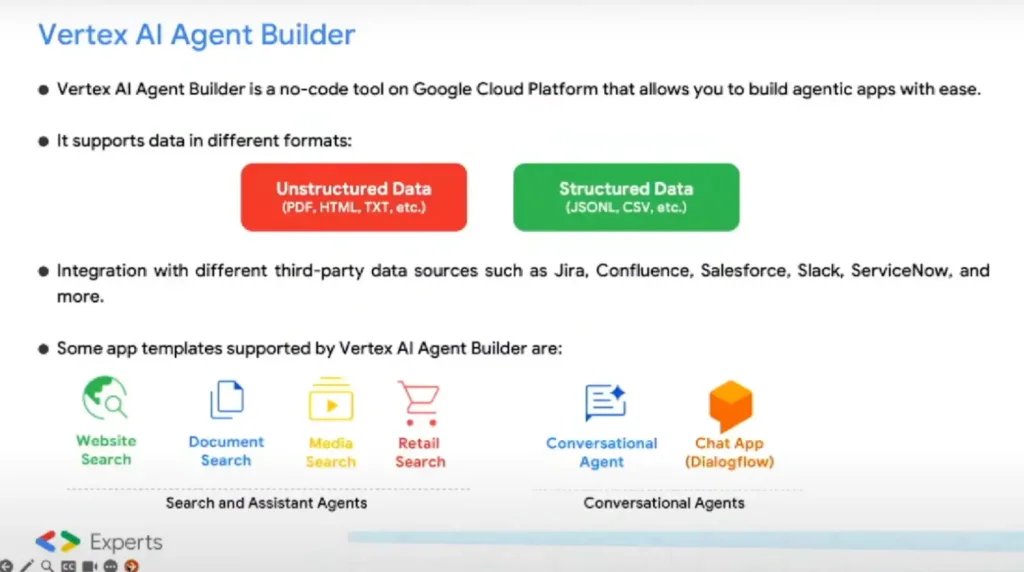

- Agent Builder ส่วนที่ช่วยให้ Dev สร้าง Agent ได้ง่าย

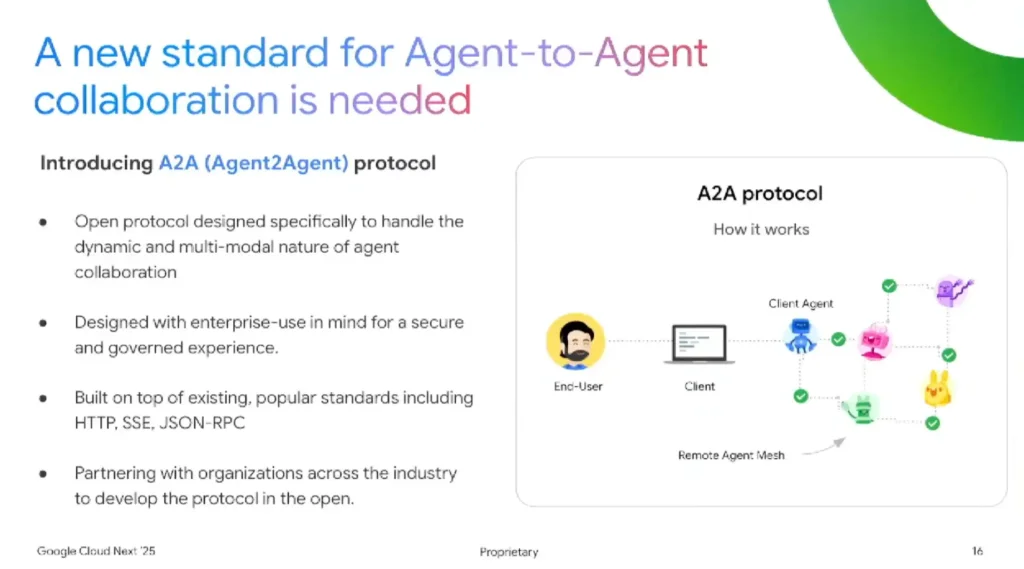

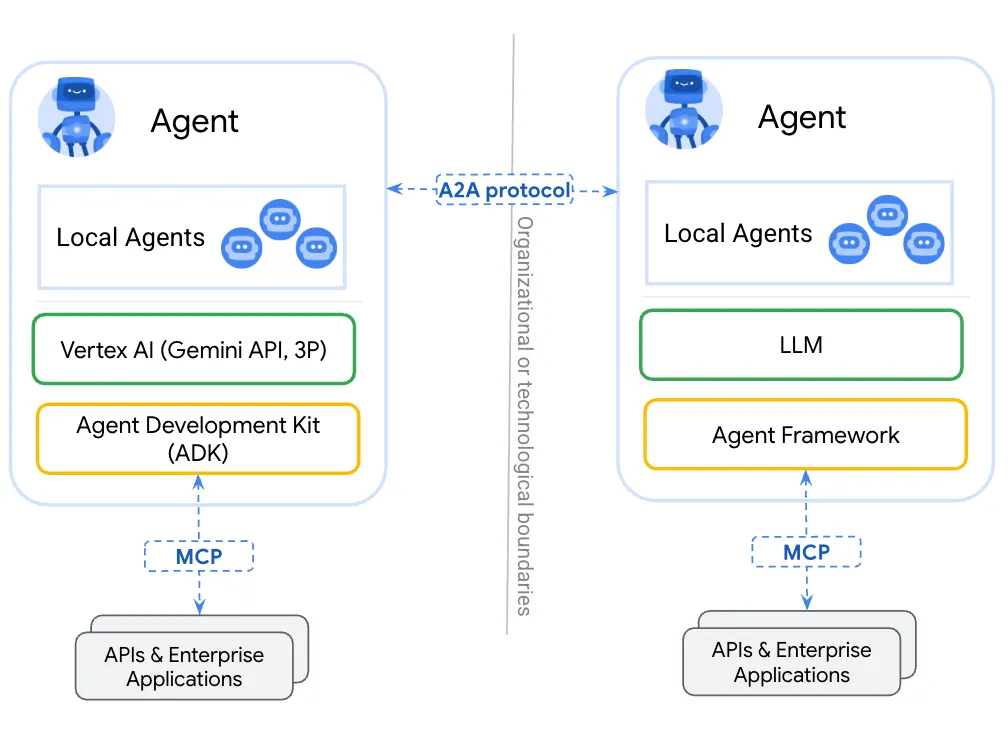

💡 ทำ Agent to Agent ได้ง่ายผ่านตัว ADK มี Protocal กลาง

💡 พวก MCP มันช่วยต่อ Tools API เสริมตัว ADK

📌 ส่วนของ Agent เป็นส่วนที่มาใหม่ในปีนี้เลย เน้นไปในส่วน End Users ใช้งานอย่างตัว

- Google Agentspace - ให้ End User เอา Agent ไปใช้งาน โดยมี

- Built-In Connector เชื่อมกับระบบต่างๆ

- Google Expert Agent มาใช้ โดยเด่นๆ Deep Research Agent / Idea Generation Agent (สุมหัว weight idea + เอาแนวคิดทีผสมกันแล้วว่าดีมาให้)

- Customer Built Agents ทำเองตาม Business Flow รวมถึงอนาคตจะมีตัว Market Place - AgentSpace Agent Designer เอาพนักงานทำ Agent ใช้เอง สร้างตาม Workflow ที่ต้องการได้ อีกชนกะ Copilot Studio ของอีกค่าย

นอกจากนี้ มีประเด็นให้เราทิ้งท้ายว่า เราเอา Agent มาทำอะไร หรือ ทำตาม Step ที่เราตั้งไว้ (Workflow) และต้องมี Human In the Loops ไหม

Ref: https://blog.langchain.com/how-to-think-about-agent-frameworks

AI Agents

Speaker Aye Hninn Khine

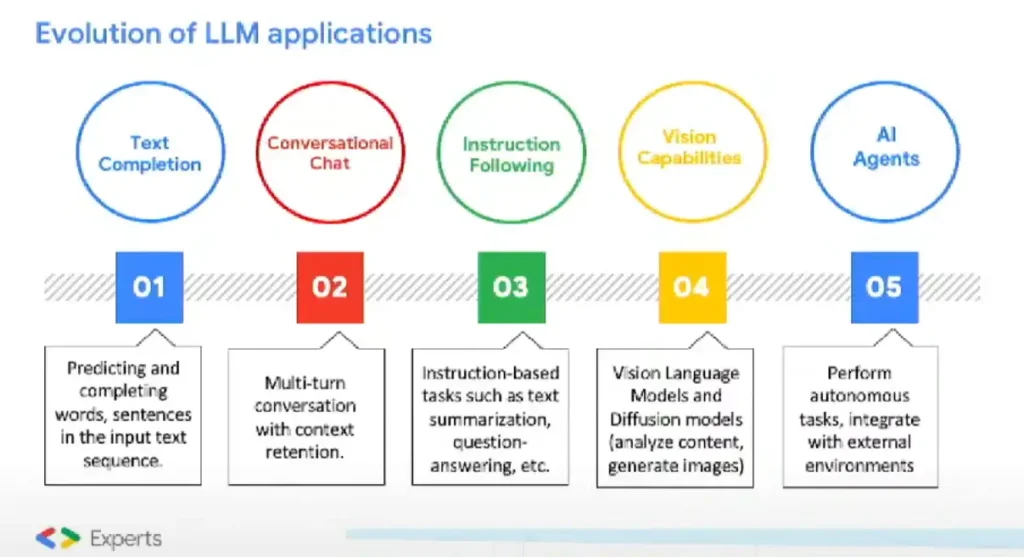

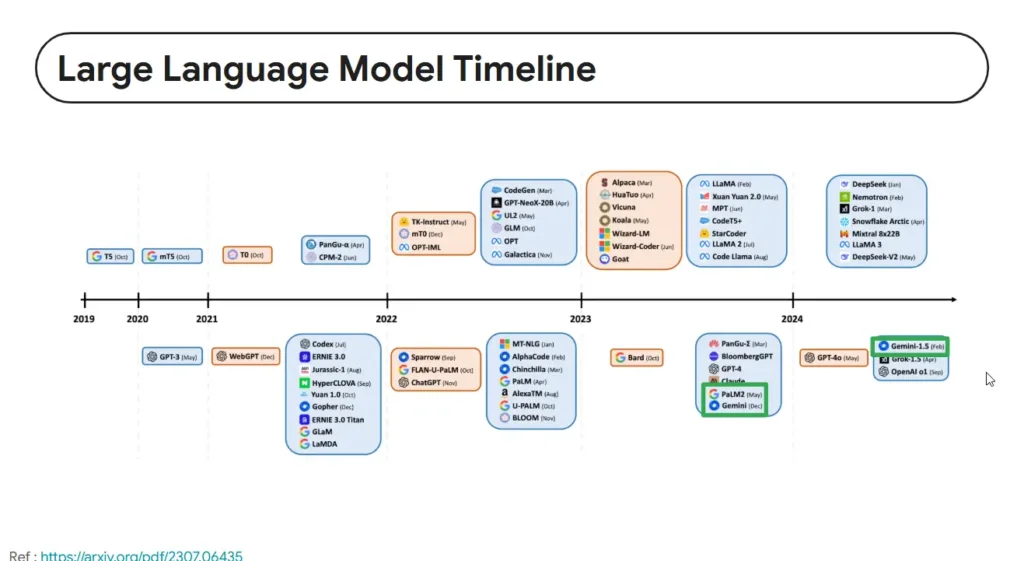

- LLM มีวิวัฒนาการอย่างไร

- แล้ว AI Agent คือ อะไร

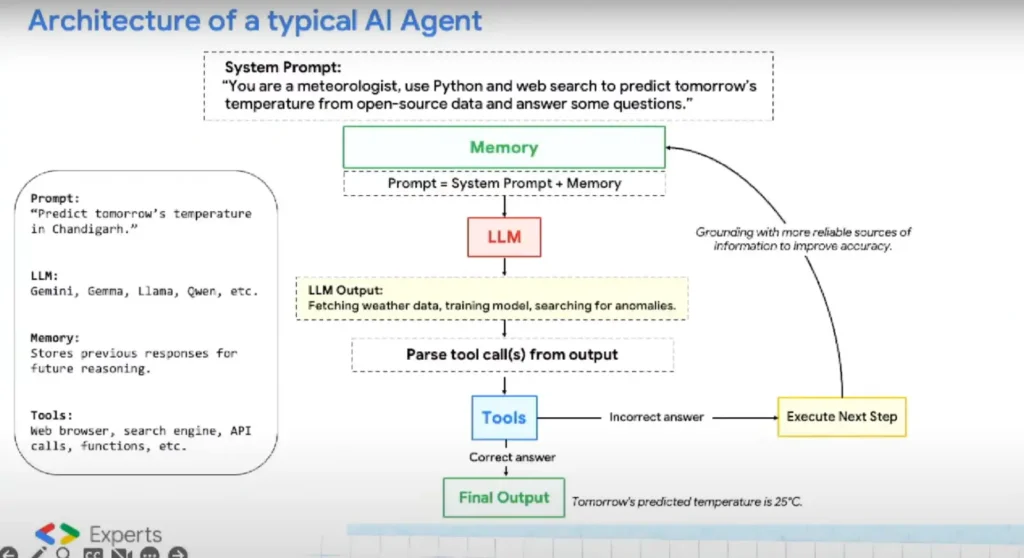

📌 Model ที่สิทธิเข้าไปจัดการของรอบข้าง (Environment) ได้รับรู้สภาพในตอนนั้น แล้วตัดสินใจ เช่น เราสั่ง pizza มองว่าได้ตัวร้าน pizza เป็น agent ทำของให้เรา ส่วนเป็นวิธีการไหน แล้วแต่ agent นะ เราอาจจะมี promptไปคุมอีกที

📌 ตัวที่ช่วยให้ Model จัดการของรอบข้าง (Environment) จะเรียกว่า Tools

📌 RAG ยังไม่เป็น Agent มันเอาข้อมูลใน KM มาตอบให้ชัดเจนขึ้น ลด Hallucination

📌 AI Agent มี Flow ตามนี้

INPUT --> LLM --> OUTPUT --> CALL TOOLS TAKE ACTION

ถ้าเราให้ AI ทำการบ้าน + ส่งการบ้าน อันนี้เป็น Agent มีทั้งส่วน LLM ทำการบ้าน และ มี Tools เอาผลที่ได้จาก LLM ส่งการบ้าน

📌 AI Agent Archtitiecture

- Orchestration ตัวจัด memory / state ว่าจะทำอะไร แล้วต่อยังไง

- Model - Foundation LLM Model ซึ่ง Run ที่ไหนก็ได้ อาจจะเป็น Cloud / Ollama เป็นต้น

- Tools ระบบรอบข้างที่เกี่ยวข้องมองเป็นเครื่องมือให้ AI ใช้ เลือกให้เหมาะกับ Requirement ที่ได้ เช่น ราคาตลาด / ข้อมูลสภาพอากาศ เป็นต้น

- Runtime - สั่งทำงาน

สำหรับการทำงานเพิ่มเติม Speaker แนะนำ Blog https://huyenchip.com/2025/01/07/agents.html สั้นๆ

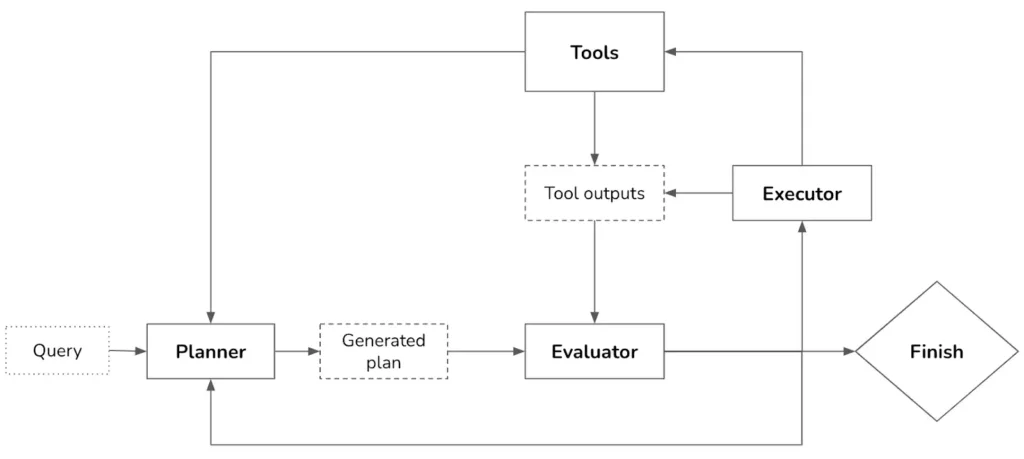

- Plannner - ตัว LLM Model คิดแผนมาว่าจะทำอะไร ้เช่น แตก Task ย่อย 1 2 3 4 .. / Function calling เป็นต้น

- Evaluator - เอา plan บางอันไปลองก่อนเอา Feedback มาเก็บไว้ใช้ต่อ จะได้ไม่รอกัน

- Executor สั่ง Tools ทำงาน

- Type of AI Agent

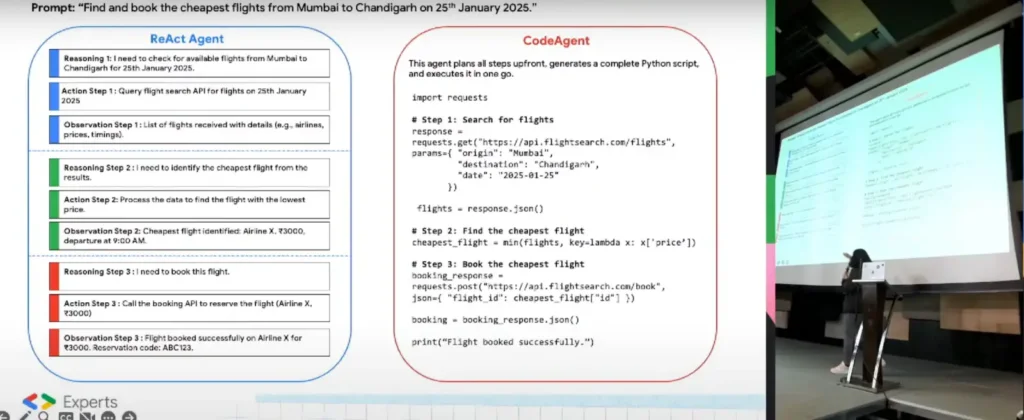

📌 ReAct Plan (Reasoning + Acting) วางแผล และเอา Output ที่ได้มาปรับ คิด เอา feedback มาปรับปรุง

📌 CodeAgent มาที่วางแผนมาเขียนเป็น Code ให้เลย

📌 SingleAgent - Agent ทำหน้าที่ 1 อย่าง

📌 Multi-Agent - Agent ทำงานเป็นทีม

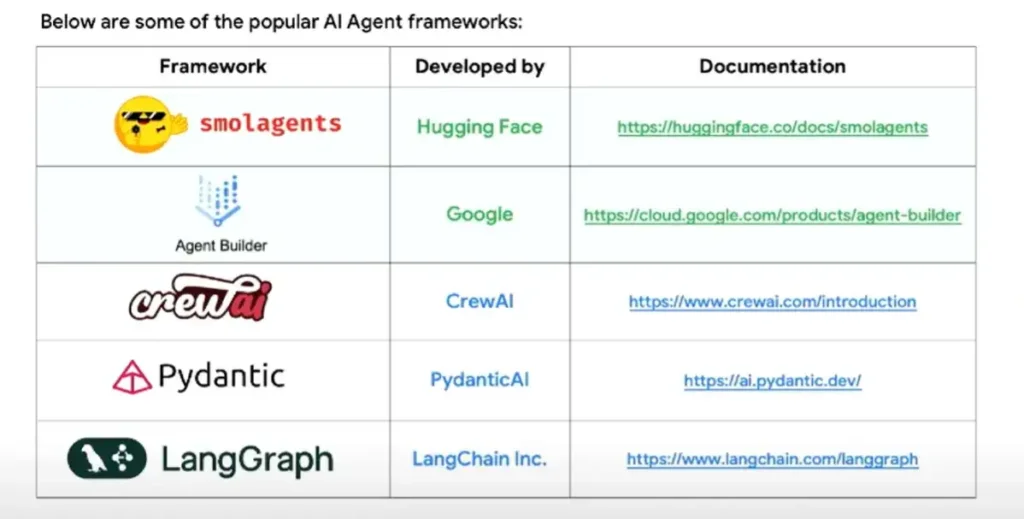

- ตอนนี้มี AI Agent Framework อันไหนที่ใช้งานบ้าง

- Workshop / DEMO

📌 มี Demo ของ SmolAgents ให้เล่นกัน https://colab.research.google.com/drive/1LSy4AA8QrpAIv6cbMHEpb6mGEF6guWtL?usp=sharing

📌 แต่ต้องมี Hugging face Token (Read/ Write) / Google Studio API ใช้ Gemini พวก App Password สำหรับส่งเมล์

📌 ของให้เล่น ดังนี้

- เอา Agent เพียวมาถาม กับอีกตัวเอาของเดิมมาแหละ แต่เอาข้อมูลจาก DuckDuckGo (Search Engine) มาทำเป็น Grouding ช่วยตรวจความถูกต้องจองข้อมูล

- Agent that analyzes images with a proprietory model using LiteLLM

- Agent that solves your assignment, and submits it to your professor via an email อันนี้ดูใกล้กับงานที่ทำงาน มีขั้นตอนแบบ Agent มันเปลี่ยนบริบทแล้วใช้ได้ สรุป Requirement ลูกค้าแล้วเมล์มาหน่อย / หาวิธีแก้ Production Issue แล้วสรุปแนวทางแก้ไขมาใน mail

- Data Analyst that analyzes cricket matches (IPL)

นอกจากนี้แล้วเราได้ยังสร้าง Agent ได้จาก Vertex AI

- Google AI Studio ส่งสำหรับ Dev PoC

- Vertex AI ทำ Backend สำหรับ Prod และตอนนี้มี Version แบบ Low Code ด้วย

From Zero to Interactive with Google ADK

Speaker Natavit Rojcharoenpreeda

📌 Google ADK เป็น Agent Development Kit Framework ของ Google ออกแบบมา Open Eco System optimize มาให้กับ Model ของ Google แต่ก็ใช้กับค่ายอื่นๆก็ได้นะ

- ADK Concept

📌 Agents

- Base Agent ส่วนเตรียมไว้ให้ Extend ต่อ

- LLM Based - Model เพียสๆ

- Workflow Based - Business Logic + Model

- Sequential Agent - ทำเป็นลำดับ

- Parallel Agent - ทำพร้อมกัน

- Loop Agent - ทำวนไป จนกว่าจะเข้า Condition หรือ max retry - Custom Logic - กำหนดวิธีคิดเอง

นอกจากนี้แล้ว เวลาเรา Agents มันทำงานร่วมกัน (Multi Agents) จะ Agent อีกตัวมองเป็นผู้จัดการมาค่อยจ่ายงาน (Root / Steering Agent) ก่อนส่งต่อให้ Agent ที่เหมาะสมตามที่ได้บอกใน AgentSkill / AgentCard (อารมณ์แบบ Resume/CV)

📌 Tools เป็นส่วนที่ให้ Agents จัดการ Enviromemnt ภายนอกได้ โดยมี

- Built-In ของ Google เช่น Search / Mail

- Third-Party Tools อย่าง Serper/ LangChain / CrewAI.

- Function Tools ให้มันยิงมาหา Code หรือ API เรา

- MCP Tools

- OpenAPI Tools ถ้ามี Spec อย่างพวก Swagger / OpenAPI โยนไฟล์ yaml ให่มันไปบอกว่า เรามี Endpoint อะไรให้ใช้งาน

ส่วนของ Tools ต้องบอกความสามารถว่าทำอะไรได้ โดยการ Comment

import requests

# define a function to get exchange rate

def get_fx_rate(base: str, target: str):

"""

Fetches the current exchange rate between two currencies.

Args:

base: The base currency (e.g., "SGD").

target: The target currency (e.g., "JPY").

Returns:

The exchange rate information as a json response,

or None if the rate could not be fetched.

"""

base_url = "https://hexarate.paikama.co/api/rates/latest"

api_url = f"{base_url}/{base}?target={target}"

response = requests.get(api_url)

if response.status_code == 200:

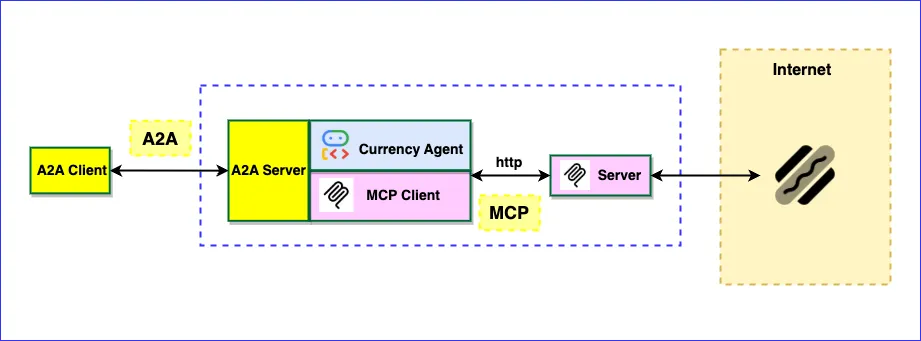

return response.json()📌 Agent 2 Agent เป็นให้ตัว Agent มาทำงานร่วมกันได้ โดยมองภาพใหญ่ ส่วนตัว MCP ส่วนเสริมให้ Agent เข้าถึง Enviroment ได้มากขึ้น

- Workshop

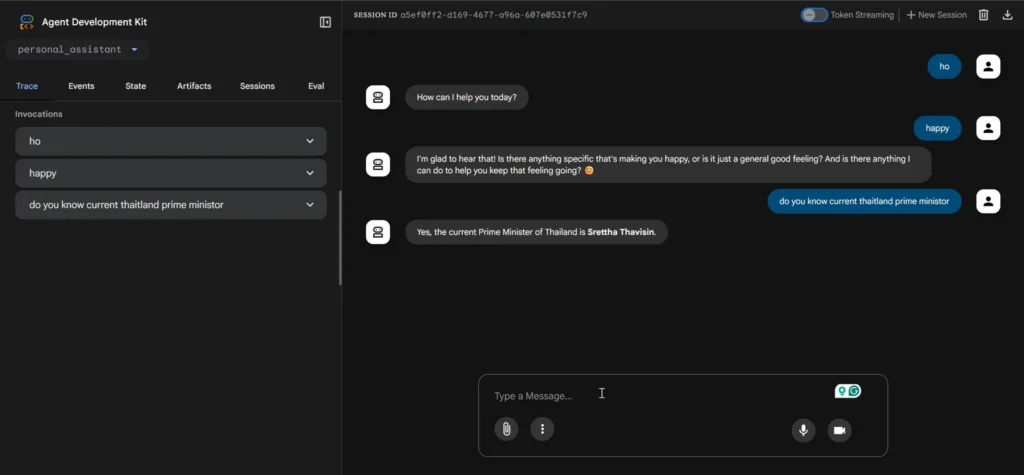

📌 goo.gle/adk-foundation - ลองสร้าง Agent ขึ้นมา มันตอบได้ตาม Model เราถามคำถาม Classic ไป ฝั่งซ้ายมี Tools ช่วย Debug / Trace ว่าเราทำอะไร

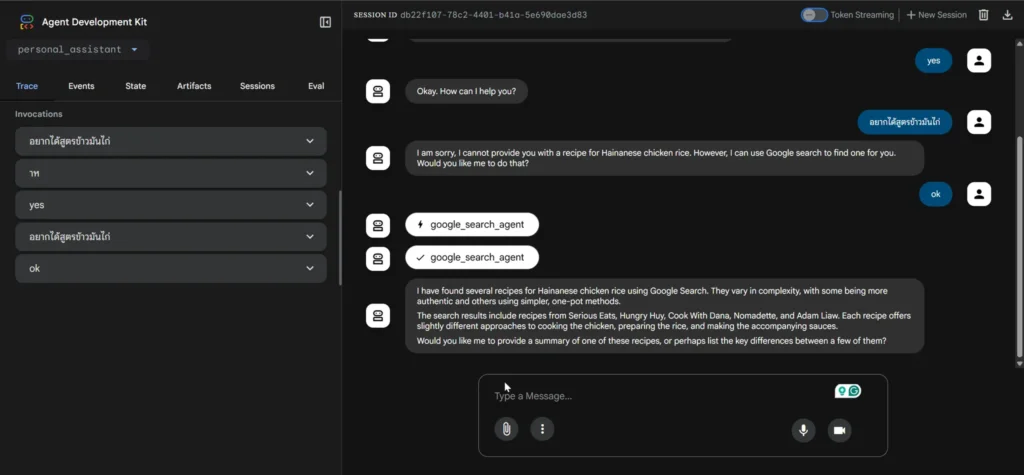

📌goo.gle/adk-using-tools จากอันแรก ถ้าเพิ่มความฉลาดต้องใส่ Tools เข้าไป

- Tools Funtion Calling

- Tools Google Search > Agents Google Search

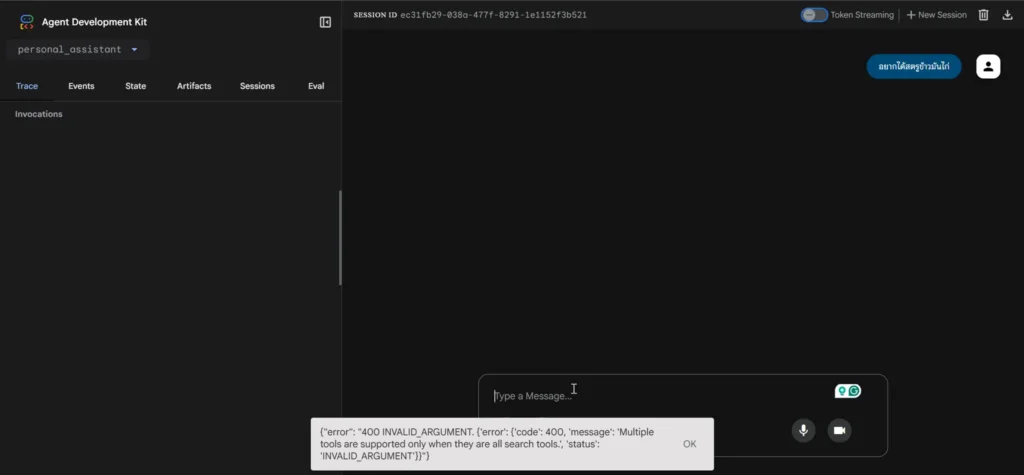

- ตอน Run จะ Error

- ต้องปรับเป็น Agent อันนี้ Google กลัวว่าตัว Tools Search มันจะกลายเป็นตัวแบกของ Agent เลยให้แยก

- Tools Third Party -

langchain

📌goo.gle/adk-mcp-a2a - ลองเอา Agent มาทำร่วม MCP

- fastmcp เป็น lib สร้าง mcp server

- A2A จะมี metadata มองว่าเป็น resume ก็ได้ว่า Agent มีความสามารถอะไร เวลาคุยกันเราก็อ่าน Spec ตรงนี้นอกจาก ใน Framework นี้จะเป็นตัว Class AgentSkill / Class AgentCard //ลองมาถึงตรงนี้คล้าย Sematic Kernel

Google's ADK and the A2A Protocol: Introduction

Speaker Natdhanai Praneenatthavee

- เราทำ Agent ไปเพื่ออะไร ?

📌จากงาน Nvidia CES Speech + Ad Toy Data Rookie มีบอก Trend ว่า Agent ช่วยให้เราทำงานต่างๆได้ง่าย ช่วย Automate ได้ง่าย รวมถึงทำ One Person Business ได้ง่ายขึ้นด้วย จากเดิมจ้างคน เราใช้ Agent หรือ เอามาเสริมในจุดอื่นได้

📌แต่มีอีกมุมตัวการ Layoff คนบางส่วน ถ้า AI แทนได้ ดังนั้นเราต้องพัฒนา Skill ให้ได้

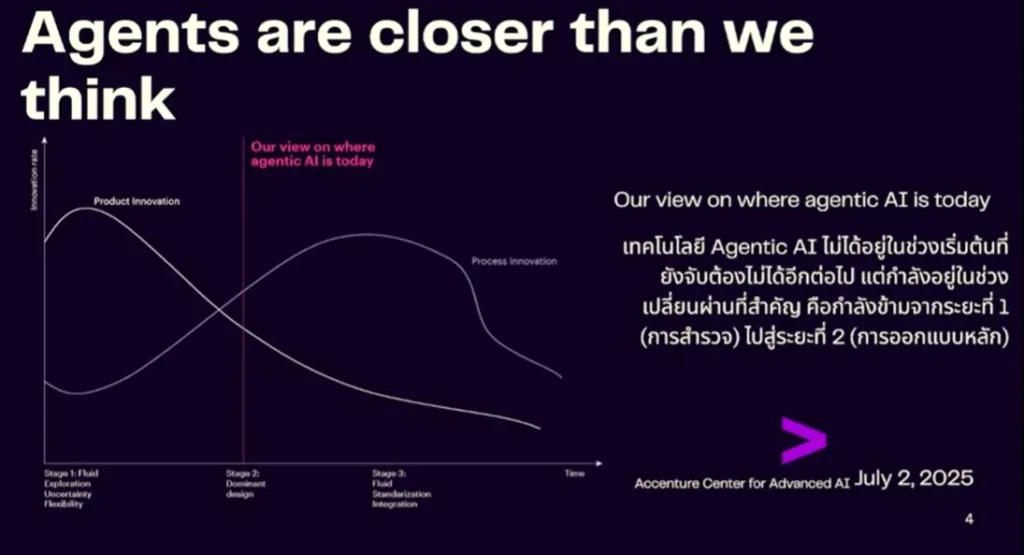

📌ตอนนี้จาก Research ของ Accenture พบว่า Agent มีบทบาทมากขึ้นในอนาคต

สำหรับที่ Speaker มองว่าเด่นๆ

- Gemini cli

- Jules - Coding Agent แบบ Copilot

- Google Agent Development Kit

- Agent 2 Agent

สำหรับ A2A บางส่วนคล้ายกับ Session ก่อนหน้า เลยจะขอละไว้

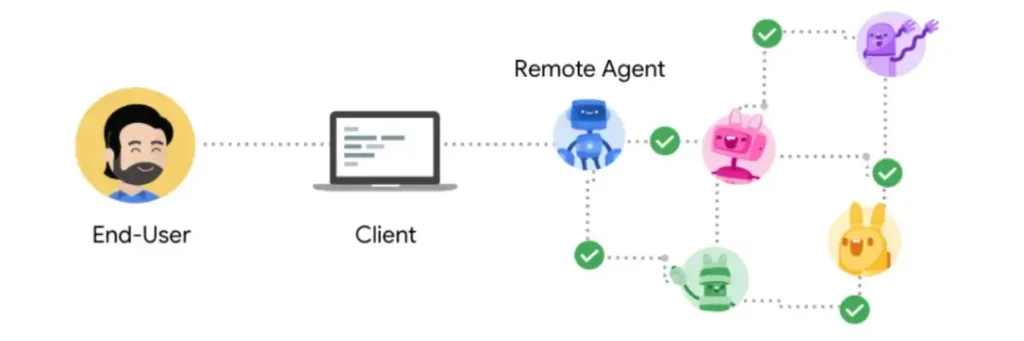

📌A2A How It Work

- Framework + CLI ทำ Agent มีมาตรฐานกลาง A2A Protocal ในการเชื่อมกับ Agent อื่นๆ และรองรับ MCP ด้วย

- การทำงานแยกเป็น Client / Server (Remote) ทำกัน 4 มุม Capability Discovery / Task Management / Collaboration / Negolation

- End User ส่วงคำขอ

- Client รับคำขอจาก User และเป็นตัวแทนในการสื่อสาร

- Server รับ Request จาก Client มาจัดการต่อ และส่งต่อให้ Agent ย่อยๆที่เกี่ยวข้อง

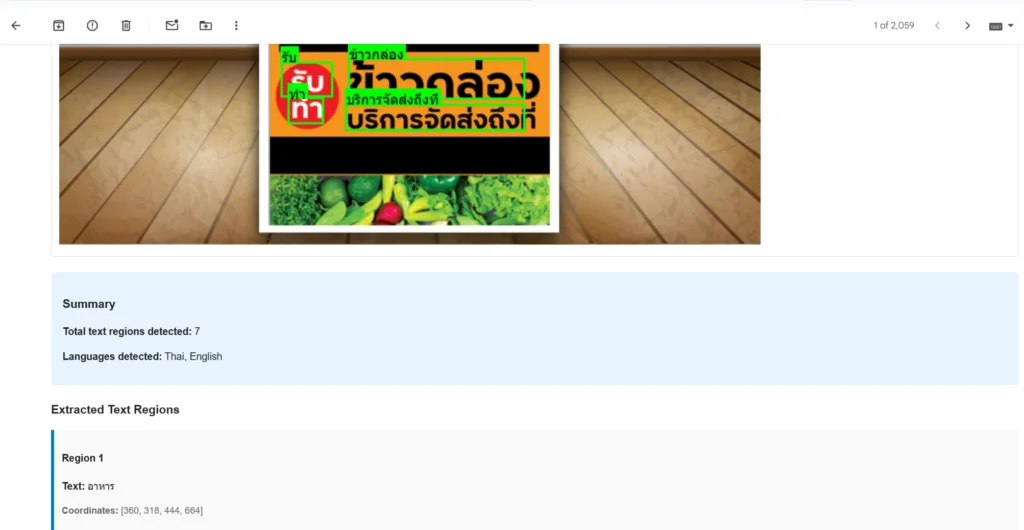

📌Computer Vision เป็นศาสตร์การเข้าใจภาพ มัน คือ อะไร เป็นของอะไร ซึ่งตัวนี้ เอามาเสริมเป็นความสามารถนึงของ Agent ได้ โดยกว่าจะได้เป็น Computer Vision ตอนนี้

- Classic OpenCV

- Neural Network

- Deep Learning จากแนวคิด CNNs / Transformer

- AI - LLM ที่เราสามารถเอา Base Model และเสริมด้วยเทคนิค Zero Shot / Few Shot เข้าได้ paper ของ Spekaer ที่ทำงานในส่วนนี่

- Workshop

- Resource

Google-Cloud-Next-2025

Google-Cloud-Next-2025 - Required

- Google AI Key (จาก Google AI Studio / VertexAI)

- Gmail App Password - Workshop1:

- Google Colab เอาไว้ลอง

- Gemini-Flash + CV Example (Object Detection / OCR พื้นที่ที่ต้องการ + ภาษาไทย) มีตัวอย่าง Prompt พร้อม - Workshop2(Fix): เอาที่ลองจาก Workshop1 (Colab) มาแยกเป็น Agent ย่อยๆ dev code ที่เครื่องเรา

- OCR - Extract Text

- Send Mail

และมีตัว root agent ค่อยประสานการทำงาน ผมฟังนึกถึงพวก node ใน n8n ที่เคยลองเลยมีลองคล้ายกัน และอย่างนี้ดีนะ ทำให้เห็นว่าใช้ UI อื่น แทน Default Chat ด้วยนะ

Bi-directional Streaming with Gemini Live API

Speaker Kamolphan Liwprasert

- Bi-directional Streaming with Gemini Live API คือ อะไร ?

📌Recap เวลานี้ Gemini มีอะไรใช้ให้บ้าง

- Gemini 2.5 Pro

- Gemini 2.5 Flash

- Gemini 2.0 Flash-lite

ตัว Gemini 2.5 Pro / flash จะมี Native audio output (text to speech) เสียงเป็นธรรมชาติคล้ายคนมากขึ้น ลองได้จาก ai.dev (Google AI Studio) ส่วน Stream

Bi-directional Streaming with Gemini Live API ย่อ Live API

📌Live API คือ อะไร ?

- ความสามารถในการ Stream เสียงเรา ขาไป (text > speeach) และ กลับ (speeach to text)

- ตอบแบบ Realtime เป็นธรรมชาติมาก

- เราพูด Interrupt มันได้นะ มันจะพังเราและเอ๊ะๆ ตอบได้ระดับนึง

- ใช้งานกับ Use-Case MultiModel ได้

มี demo เยอะ เหมือนกัน เช่น https://github.com/GoogleCloudPlatform/generative-ai/blob/main/gemini/multimodal-live-api/intro_multimodal_live_api_genai_sdk.ipynb กดเปิดใน Google Colba ได้เลย

สำหรับในมุม Coding

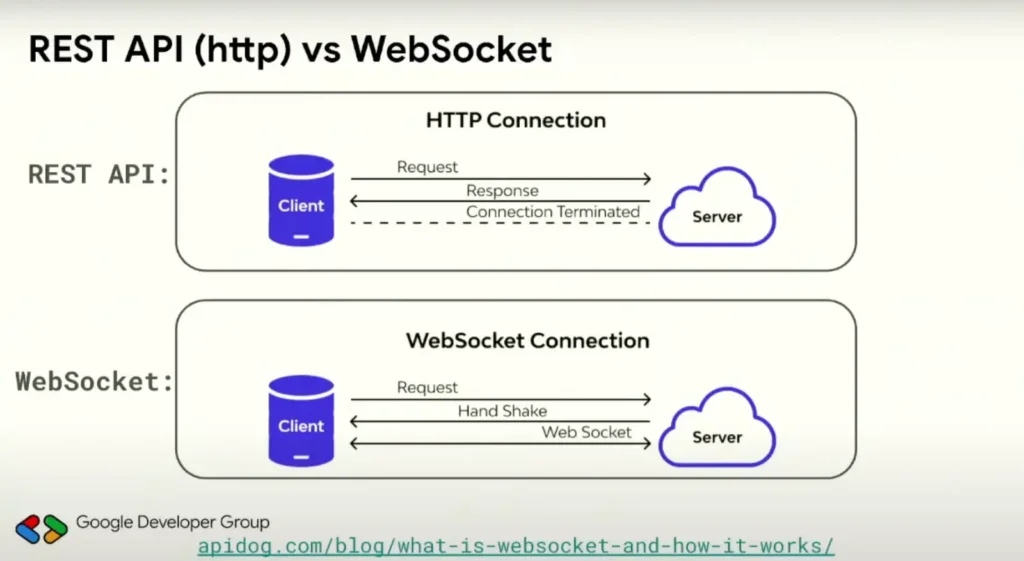

- เปลี่ยนจาก REST API (http) มาใช้ Web Socket เปิดช่องทางพิเศษให้ Server Client คุยกันบนทางพืเศษเลย

- จาก https:// > wss:// (web socker secure)

- สำหรับ ws กับ webrtc

- มี doc ลองดูตาม https://google.github.io/adk-docs/streaming/dev-guide/part1/

- Workshop / DEMO

- Repo: https://github.com/fonylew/language-buddy อาจจะต้องกำหนด Google Credential ก่อน Run

- ดูใน Live นะเข้าใจมากกว่า มันคุยโต้ตอบ

Speaker มี Course มาแนะนำด้วยครับ https://www.kaggle.com/learn-guide/5-day-genai

Evolution of Gemma 3n for Deploying Local Models on Every Device

Speaker Witthawin Sripheanpol

- What is Gemma

- gemini ทำโดย deepmind บ ที่ทำ alpha go

- gemma เป็นเวอร์ชัน open source model ของ gemini

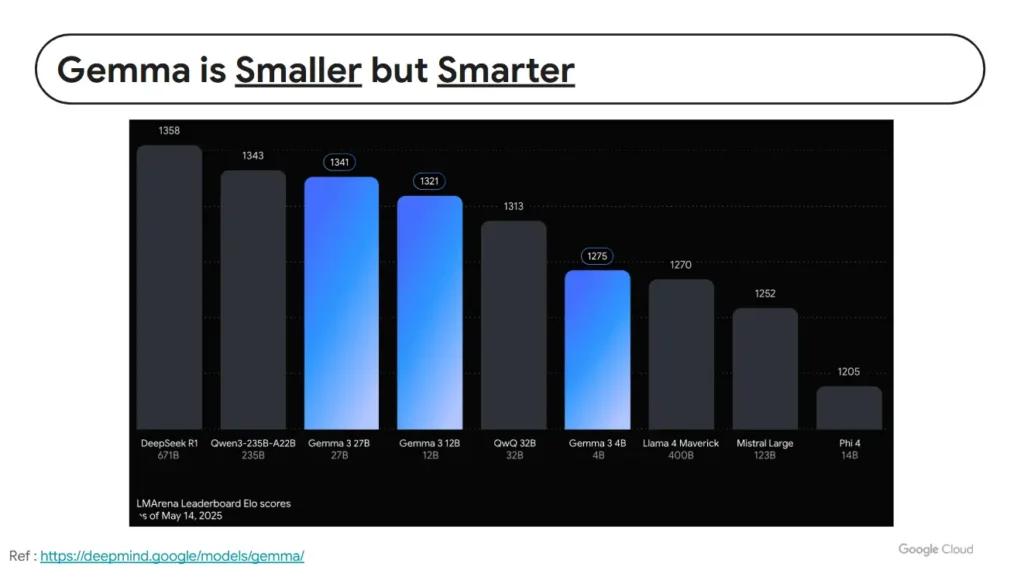

- ตัว Gemma Design for local device เน้นเล็ก แต่ฉลาดอยู่

- ตัว Gemma 3 มีปรับให้ Model ใหญ่ขึ้นมี parameter มากขึ้น

- พอเป็น opensource มีเอาไปต่อยอดหลายแบบ เช่น medgemmea / shieldgemma เอาไปเป็น GuardRail เอากันตอบอะไรแปลก / dolphingemma (how dolphins communicate) //จะมี catgemma ไหมนะ เป็นต้น

- Evolution From Gemma > Gemma3 > Gemma3n

- Gemma3 - multimodal และ ขนาดเล็ก

- Gemma3n - เน้น Env ที่เล็กลงไปอีก อย่างพวก iot / mobile device

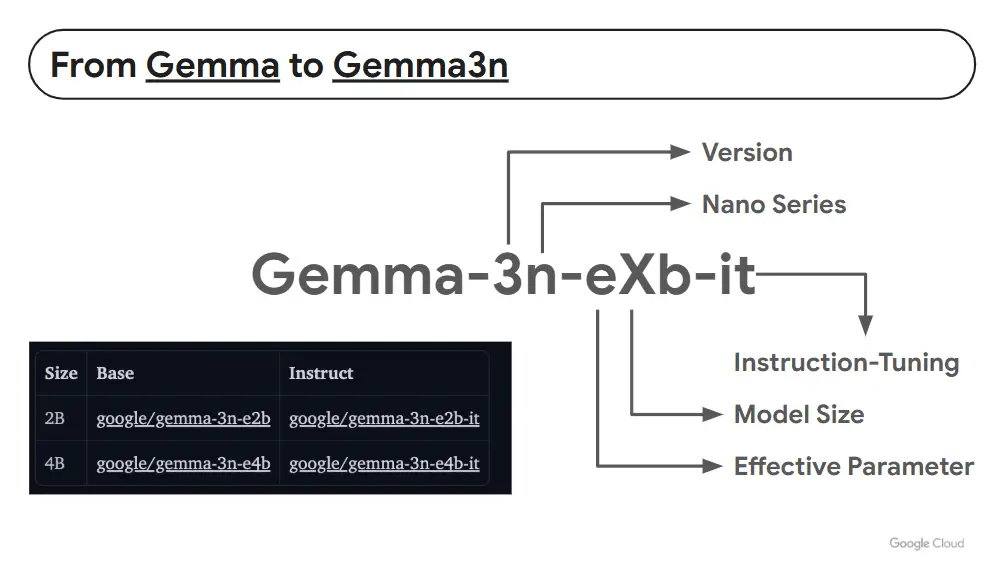

📌 Model Code อ่านยังไง ?

- 3 - Verion

- n - บอก nano สำหรับ modile

- it - instruction tuning เก่ง chat

- X - ขนาดของ Model บอกจำนวน RAM ที่ใช้

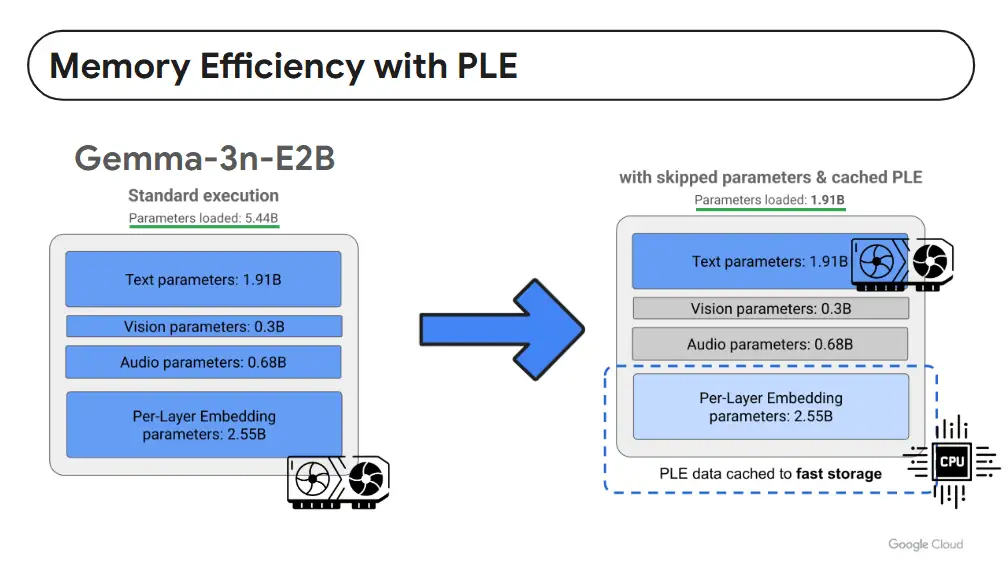

- e - effective parameter ตอนออกแบบ Model เลยแบ่งว่าส่วนในใช้ GPU / CPU เรียกว่าลด Resource ได้เยอะเลย

ทำไมถึงต้องทำแบบนี้ เพราะ Mobile มีส่วนของ vRam น้อย เลยต้องแบ่งส่วนของ Model สำหรับ Process ใน ว่าส่วนในใช้ GPU / CPU เรียกว่าลด Resource ได้เยอะเลย งานไหนใช้เท่าไร่ดึง Resource เท่านั้น

📌 ความสามารถของ Gemma3n (Model 2B)

- Supports 140 languages for text

- Supports 35 languages for multimodal interactions.

- Support Long-term conversation

- เบื่องหลังความเก่งมีหลายอัลกอริทึมยัดเข้าไปใน Model

- MobileNet เป็นอัลกอรึทึมเบื้องหลังที่ช่วยให้งานด้วยภาพไวขึ้น อย่าง เช่นใน Google Pixel ตอนนี้ MobileNet-V5-300

- Universal Speech Model (USM) - จัดการด้านเสียง ทำให้เข้าใจมากขึ้น

เลยเป็น multimodal

📌 Benefit Gemma3n

- Optimize for on device เหมือนงาน Video / Image

- Privacy First

- Multi Modal Understanding

- Dynamic Resource usage - มันใช้ resource น้อย ถ้า scale คุม cost ได้ แบ่งงานลง CPU ได้ Cost จะถูกลง กว่าซื้อการ์ดจอ

- How to use Gemma3n

- มีหลายที่เลยจาก Hugging Face / Kaggle / Ollama / LMStudio

- คนใช้ดูแต่ -it สำหรับ chat ส่วนงานอื่นๆ เอาตัวที่ไม่มี -it //เข้าใจและ ฮ่าๆ เดี๋ยวไปดึงใน Ollma ใหม่ ลองแล้วมันแปลกๆ

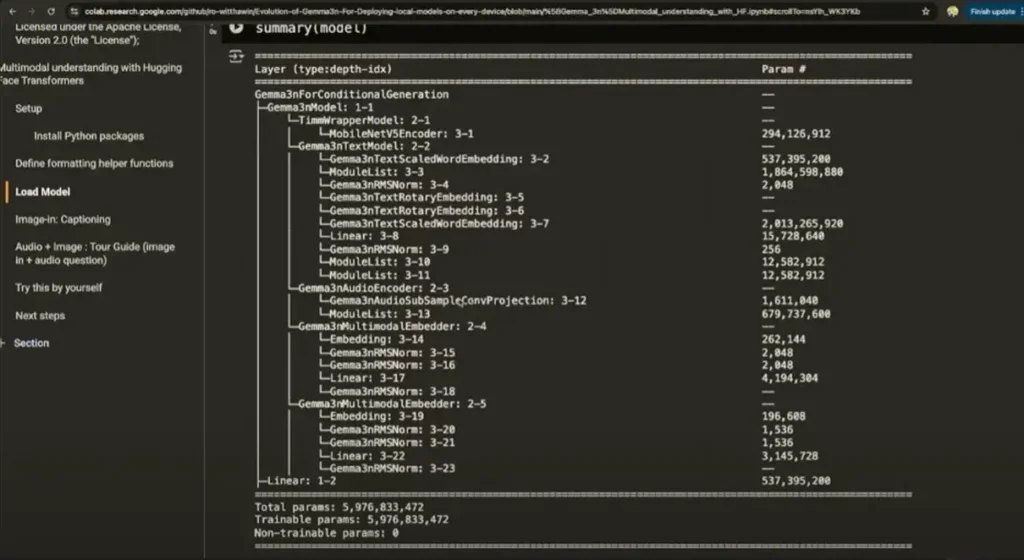

- Demo https://github.com/ro-witthawin/Evolution-of-Gemma3n-For-Deploying-local-models-on-every-device/blob/main/[Gemma_3n]Multimodal_understanding_with_HF.ipynb

- เพิ่งรู้วาเราส่องใน model ได้ด้วย อารมณ์แบบ layer ใน docker มั้ง

- Deploy Gemma3n On Local Device

- ลองใช้ผ่านตัว ONNX Framework แต่ Client จะดึงข้อมูลนานๆหน่อย Model หลาย GB

Ref: https://huggingface.co/onnx-community/gemma-3n-E2B-it-ONNX

สุดท้ายขอขอบคุณทีมงานทุกท่านที่จัดงานดีๆแบบนี้นะครับ

Reference

- https://gdg.community.dev/events/details/google-gdg-cloud-bangkok-presents-cloud-next-extended-bangkok-2025/

- Live: https://www.youtube.com/watch?v=J8vPROs0Qb4

Discover more from naiwaen@DebuggingSoft

Subscribe to get the latest posts sent to your email.