สำหรับงานวันนี้ Comminuty ของ Global AI Bangkok ที่ตึก K+ สามย่านครับ เนื่องจากหัวข้อ ผมไม่รู้ว่าจะเข้าอันไหน มันแยก Track เยอะ เลยให้ Gemini เลือกให้ ว่าตัวเราที่เป็น Role Dev ต้องมาฟังอันไหน

และอันนี้เป็นหัวข้อจริงที่จดมาครับ

Opening

Speaker Komes Chandavimol / Teerasej Jiraphatchandej / Phantip Kokilanon

เปิดงานนิดนึงครับ สาระสำคัญงานนี้ มันมีหลาย Track อย่างที่ India ถ้าได้ยินมาไม่ผิดมี 500 Section และคนเข้าร่วมเยอะมาก กว่าเข้าครบยากครับ เลยมี Guideline ตามนี้

- Put Attention to the right thing - เลิอกหัวข้อที่เหมาะสม

- สวนอันไหนที่ฟังไม่ได้เวลาชนกัน - หาเพื่อนในงาน Collaboration มาเล่าแบ่งปันครับ อย่างที่ผมทำก็จน Blog ครับ

Agents of Tomorrow: Building the Next Generation of Intelligence

Speaker Henk Boelman

AI มันเริ่มจากสื่งเล็กตั้งแต่ปี 1955 มาแล้วนะ Key Making Machine Intelligent

- 1966 - Shakey robot หุ่นยนต์ที่เราพยายามทำให้ฉลาดขึ้น

- 1965-1966 - Eliza chatbot ตัวแรก

- พอมาเป็นยุค PC Data เก็บง่ายขึ้นทำให้พวก AI โตได้ง่ายขึ้น

- 1995 Microsoft Clippy’s ที่มันมากับ Office ที่มันทำงานเล็กๆน้อยๆ จนมาถึง Neural Net และ

- ช่วงปี 2020-2022 เปิดตัว Gen AI Era พวก ChatGPT มาในยุคนี้

- ช่วงปี 2022-2024 Multimodality Model ระหว่างนี้ AI เข้าสู่ Democratization and Ecosystem Growth (ทุกคนเข้าถึงได้แล้ว)

- ช่วงปี 2024-2025 ยุค Agent

ตอนนี้เรามั่นใจ AI แล้ว หรือยัง เอาไปใช้งานยัง เพราะยังมีเคส Builder.ai (บอกว่า AI แต่ใช้คน) / Waymo ที่อยู่รถมันขับเอง แล้วรบกวนคนอื่นช่วงดึก หรือ แม้ว่าการเอา AI มาใช้ Coding หรือ คุม Computer เราเลย (Computer Use) ซึ่งเราต้องเรียนรู้กับมันไป //จริงมันทุกคนในห้องมาตอบนะ แต่ผมนับไม่ได้ 555

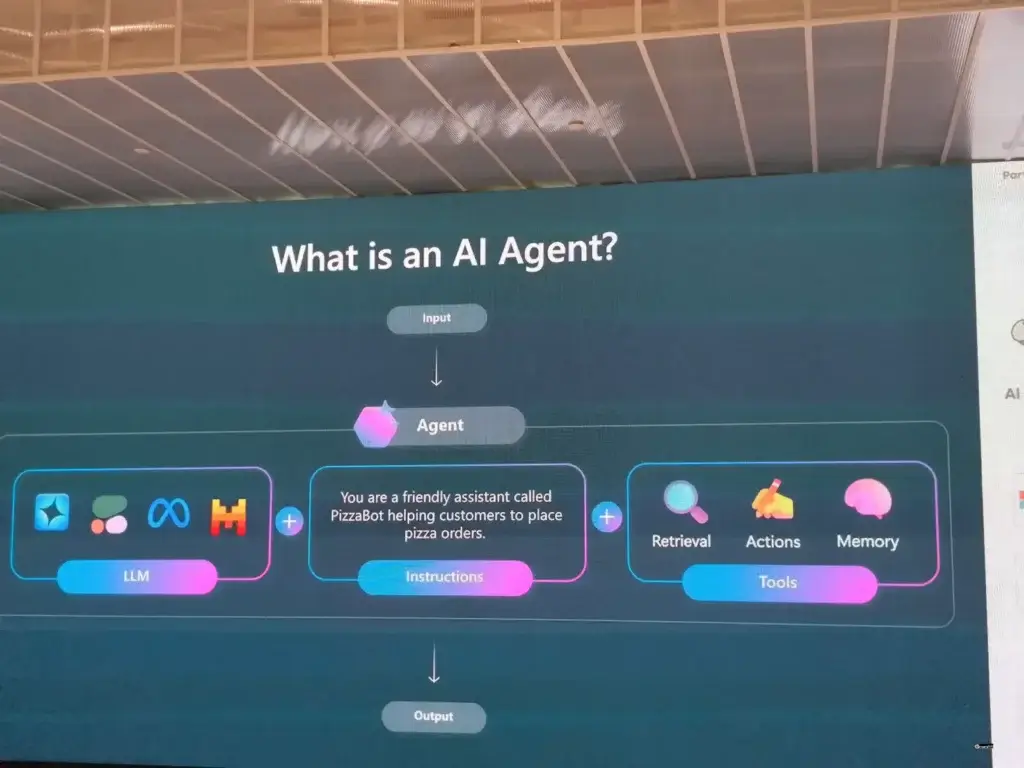

ยุคนี้ ที่เป็น AI Agent มันทำได้ส่วนการรับรู้ (Perceive), ตัดสินใจ (Decide) และลงมือทำ (Act) เพื่องานสำเร็จได้ โดย Stack ของ MS ประมาณนี้เลย

Agent - Vibing Coding > Spec-driven

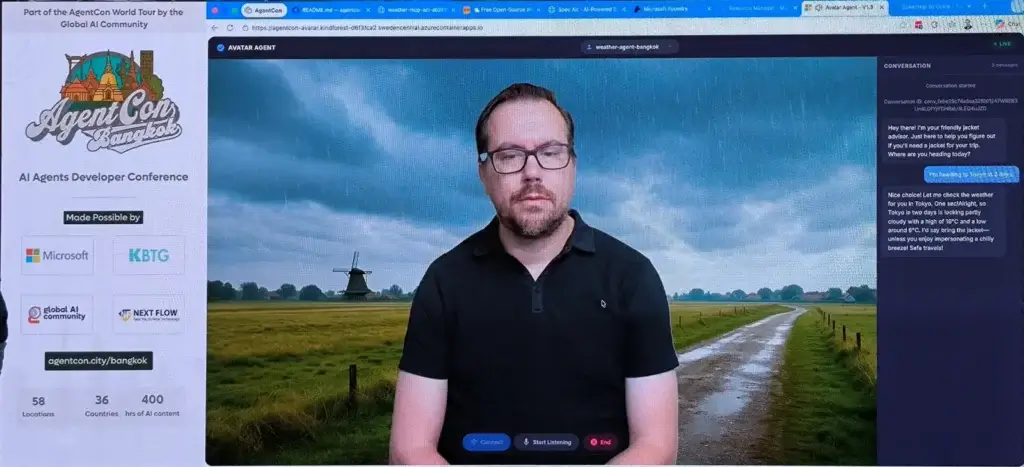

สำหรับอันนี้จะ Live Demo ทำ Jacket Advisor Agent เพื่อมาแนะนำควรจะซื้อไปด้วยไหม ตามปลายทางที่จะไป และมีเอาข้อมูลสภาพอากาศจากตัว MCP นี้แหละ

📌 ไม่ได้ Vibe แต่เริ่มจาก Spec โดยใช้ speckit.org ถ้าดูใน Repo ของคุณ Henk จะมีเตรียมไว้แล้ว ข้างในบอก

- Spec ของ MCP ที่ทำ - Constitution (ข้อตกลง) / Requirements (Feature Functional / NFT) / Data Model / Technical Stack / API / Task & Checkpoints

- ส่วนของ Deployment ว่าจะมี Pattern คล้ายๆ

📌 เริ่มต้นง่ายๆ เตรียมเงิน สมัคร Account เปิด project ไปที่ไฟล์ Spec chat "implememt this"

📌 จากนั้นไปเตรียม API Key จาก https://open-meteo.com/ บอกสภาพอากาศมาใส่

📌 พอได้ App มาก็ Test และ Deploy MCP น่าจะไป Azure Container App นะ และเพิ่ม Microsoft Foundary - Add MCP เข้ามา

📌 Setup Agent ในขา Microsoft Foundary เลือก Model และทำอะไรให้เรียบร้อย และต้องมากำหนด

- System Prompt ไปดูจากนี้ ผมให้ Gemini แปะจากรูป ไม่รับประกันความถูกต้อง 555

- Tools เพิ่ม Weather MCP

- ทดสอบ Playgroud แล้วเอาไปผูก video avatar (ไม่รุ้ว่าใช้ของ อันนี้หรือป่าว ฟังไม่ทัน)

- Demo ได้จบ

Agent ในอนาคต

อันนี้คุณ Henk บอกไว้ 3

- Human with assistance - ใช้ AI ช่วยทำงานเล็กๆ น้อยๆ หรือช่วยค้นหาข้อมูล หรือ ช่วยผู้พิการอย่างโครงการ Fluid Mind

- Human-led agents: Agents เริ่มเข้ามาเป็นส่วนหนึ่งของทีม เช่น การเข้าร่วมประชุมและสรุปงานใน Microsoft Teams

- Human-led agent operated - Agents ทำงานตาม Workflow ที่ซับซ้อนในเบื้องหลังเอง และจะติดต่อคนเมื่อจำเป็นเท่านั้น โดยที่เรากำหนดทิศทางให้ เหมือนจะผู้จัดการ ตัวอย่างเป็น Customer Support

สุดท้ายมนุษย์ต้องดูอยู่นะ ขยับออกมาใช้ Vision / Guardrail / Ethics มาตรวจสอบ ถ้าลืมอาจจะพลาดแบบนี้ได้ 555

The future won't be built by Al agents alone It will be built by humans bold

enough to imagine what's possible with them.

The Changing Role of the Developer

จากรูปเลยและกัน อันนี้ AI มาช่วย Coding Task แสดงว่าต้องขยับมามองภาพรวมที่ใช้ขึ้น ความสัมพันธ์ของ System / Business สำหรับงานด้าน AI มีหลายตัว และ Skill ที่จำเป็นตามรูปเลยครับ

ปิดท้ายสรุปตามนี้ครับ

The future we invent is a choice we make, not something that just happens

Satya Nadella

satya Nadella

How to Stay Sane in the Age of Agents

Speaker Karn Wong

ตอนนี้มีรูปแบบทำ AI App มากมาย ตั้งแต่แบบ RAG > Advance RAG (Complex แบบ GraphRAG) > Agentic RAG > Agentic App (สำหรับ End User และ แบบตัว OpenCraw

คำถามต่อมา ถ้าทำเองต้องเริ่มจากอะไร Speaker เลยสรุปมาให้

📌 Framework + ภาษาที่รองรับ อันนี้ขอเพิ่ม strands agents จาก Session สุดท้ายมาด้วย

| NAME | Python | Type Script | Java | GO | RUST | .NET | A2A Support | Observability Support |

|---|---|---|---|---|---|---|---|---|

| Agent Development Kit (ADK) | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ | ||

| CrewAI | ✅ | ✅ | ||||||

| LangGraph | ✅ | ✅ | ||||||

| MS Agent Framework | ✅ | ✅ | ✅ | ✅ | ||||

| ADK-Rust | ✅ | ✅ | ||||||

| Rig | ✅ | |||||||

| strands agents | ✅ | ✅ |

อันนี้ต้องดูความพร้อมของแต่ละทีม ถ้าเลือกต่างกันเยอะ มันจะมีความซับซ้อนตอน Dev Deploy และตอน Maintain มัน ถ้ามีหลายทีม อาจจะสร้าง Protocal กลางอย่าง Protocal มาตรฐานอย่าง A2A และ Observability

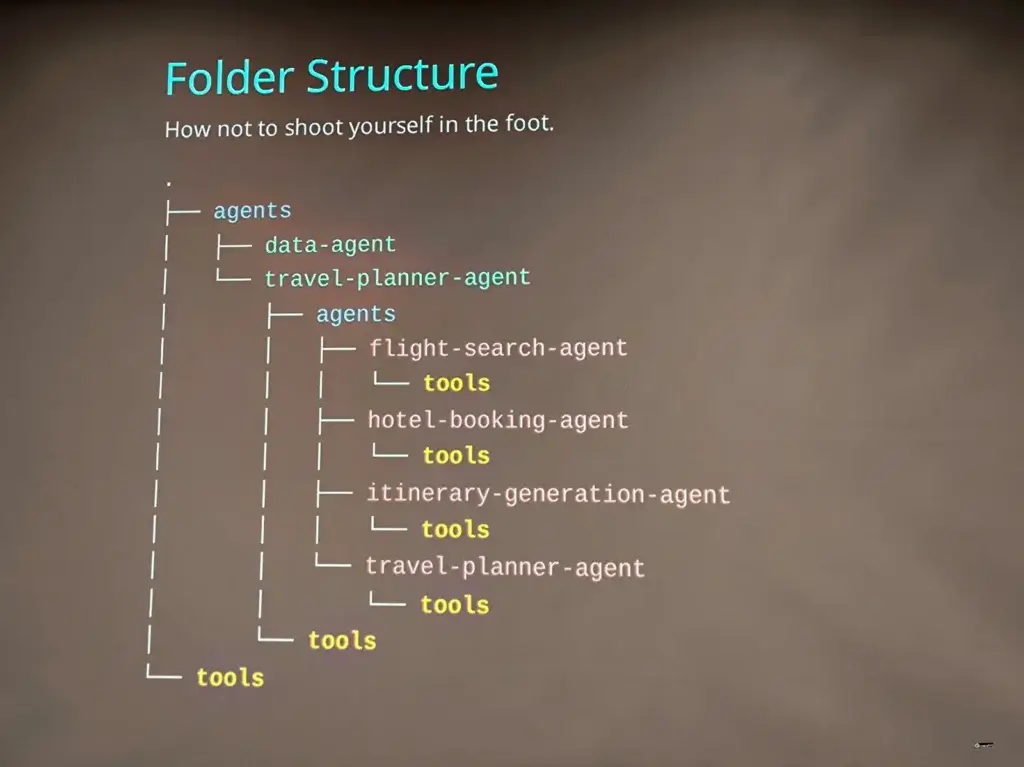

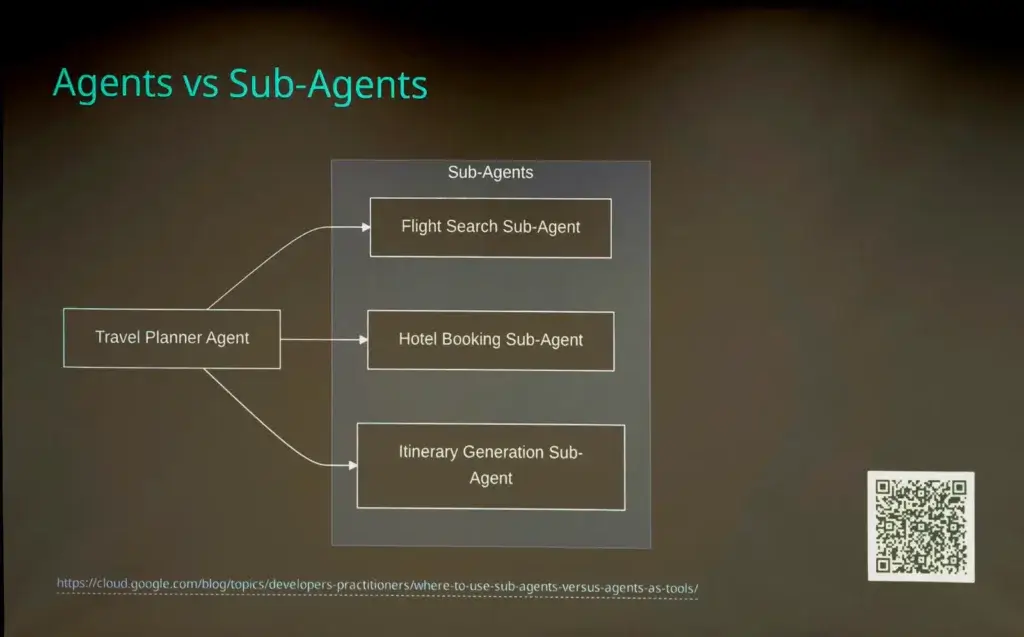

📌 Code Structure จัดแบบไหน อันนี้รวมเรื่อง Agent - Sub Agent ด้วย (แยกงานเฉพาะ เอาคนเก่งมาทำเฉพาะด้าน ลด Hallucination ตามรูปด้านล่างเลย ส่วน mcp แยก repo ก็ได้

📌 การจัดภายใน App ของเราจะมี Orchestration Pattern อย่างไร ต้องไปดู Doc ของแต่ละตัว แต่มีท่ามาตรฐานตามนี้

- รูปแบบการทำงาน Sequentail / Loop / Parallal เป็นต้น

- ตัว Agent ทำงานแบบ Pipeline ได้ไหม - แบบ data / devops ตอน build

- รวมถึงการ Support Case ที่คาดไม่ถึง (Durable Execution) อย่าง Error Handing แล้วต้องทำอย่างไร หยุดเลย หรือ retry ต่อ

📌 การ Authentication รองรับแบบไหนบ้าง แล้วท่ามาตรฐานที่ใช้กันอย่าง A2A + Framework ทำได้ไหม หรือ ต้องเขียนเพิ่ม อย่างแบบ API Key / Http Auth / OAuth2.0 / OpenID หรือ Manual TLS

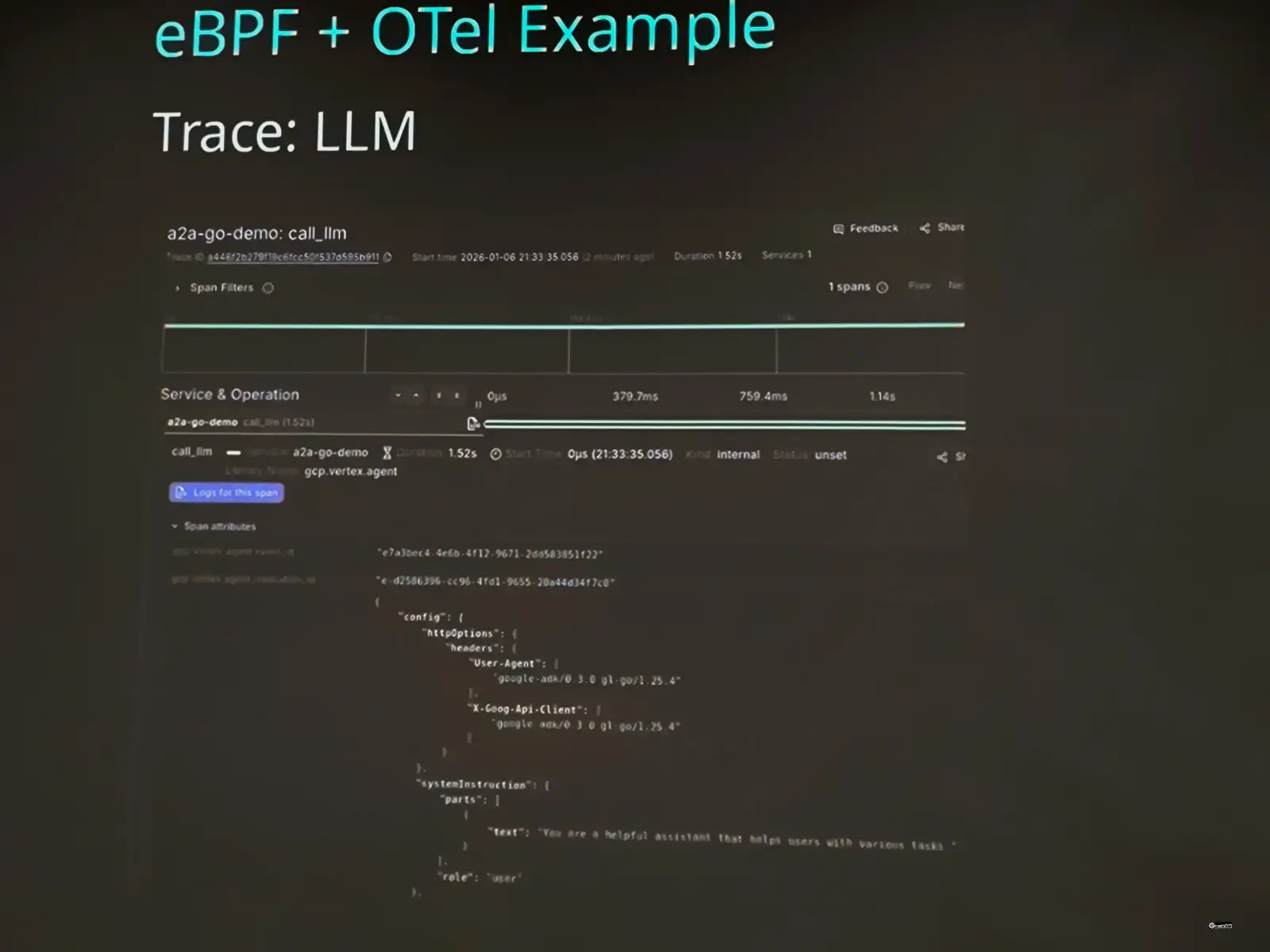

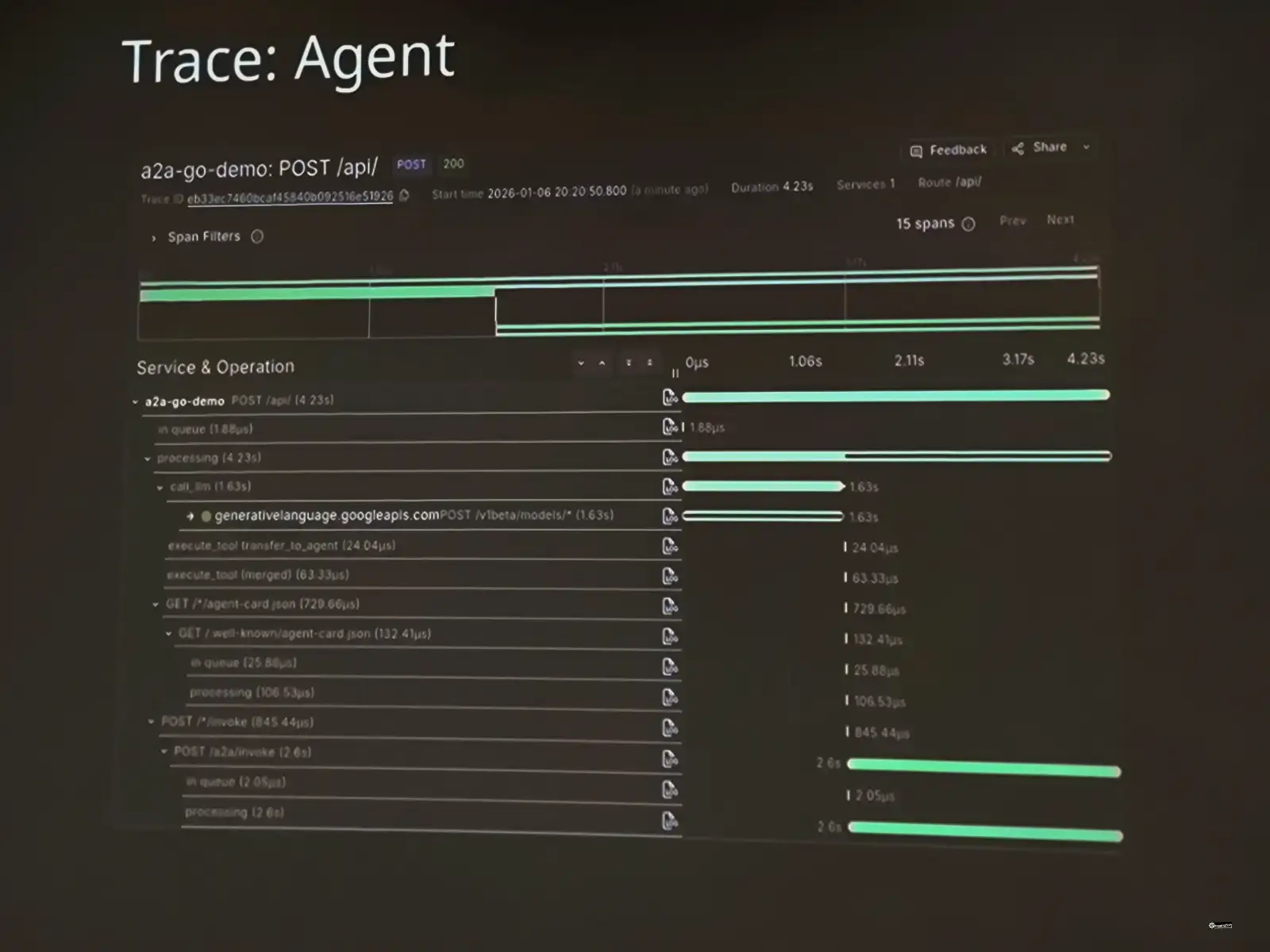

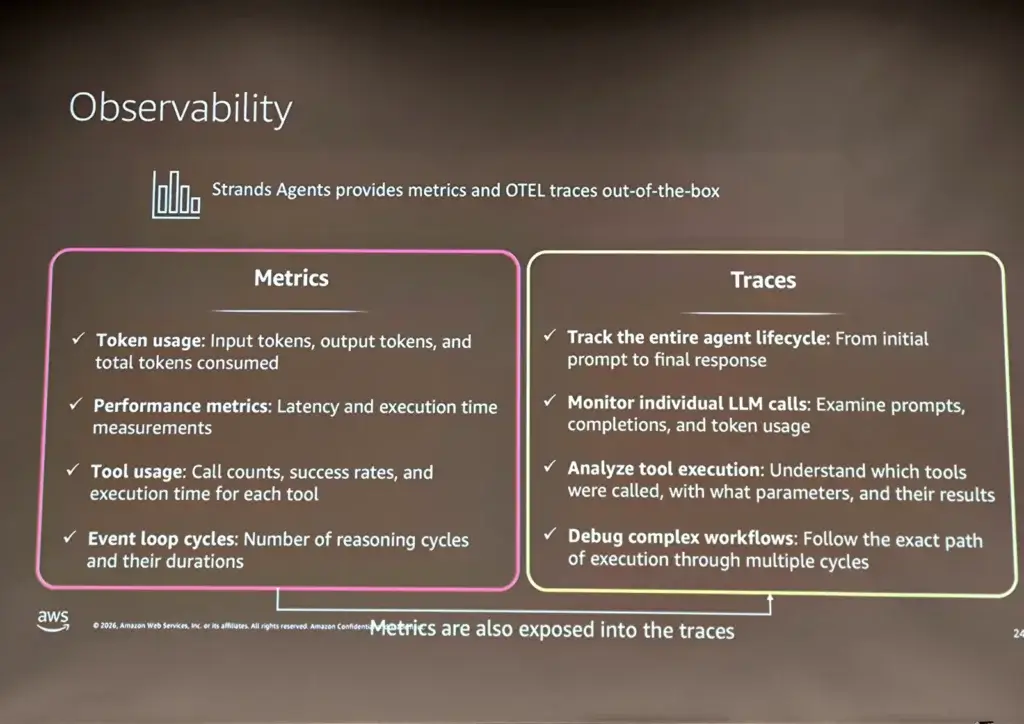

📌 สุดท้ายเรื่อง Observability มันคำถามที่เราต้องรู้หลายส่วน

- DevOps เดิมๆ พวก Latency (มันช้าที่ไหน) / traffic / error / satruration (4 golden signal - resource ตอนนี้เป็นยังไง ?)

- Tracing - เอามาหาว่า ที่ส่งไป req วิ่งไปไหน แล้วใช้เท่าไหร่

- Token Usage & Cost ถ้าเกิน limit อาจจะเจอ error จาก llm providor ได้ อาจจะต้องขยับ Tier จ่ายมากขึ้น หรือ ปรับ code การใช้ token ประหยัดขึ้น

- Code/Framework ต้องเขียน Code เอง (Manual Instrumentation) หรือ Observability พื้นฐานออกมาให้เลย (Auto Instrumentation)

- ตรงนี้มีหลายค่ายที่ทำ Datadog / Arize Pheonix / eBPG+OTEL

Why Multi-Agent Systems? Designing Collaborative AI for Real Products

Speaker Songpol Bunyang

when and why to adopt multi-agent systems

📌 การทำ multi-agent systems เราต้องเข้าใจนิยามก่อน

Multi-Agent = Divide responsibility (แยก Role), not intelligence

แต่พอแยกแล้ว มันมีความซับซ้อนต่อไปในส่วนการเอาผลลัพธมารวมกัน จะจัดการยังไง ตรวจสอบอย่างไร (Feedback& validation) แต่มีข้อดีนะ พอแยกแล้วเรา Scale เฉพาะส่วนได้นะ

📌 เข้าใจรู้แบบงานกันก่อน ไม่ใช้ทุกงานต้อง multi agent

- No Agent - Summay

- Single Agent - มี task เล็กๆ ทำแล้วจบ เช่น หาไฟล์

- Multiple Agent - แบ่งงานตาม Specialize โดยมี key การจ่ายงาน ให้ถูกคน และตรวจสอบผล

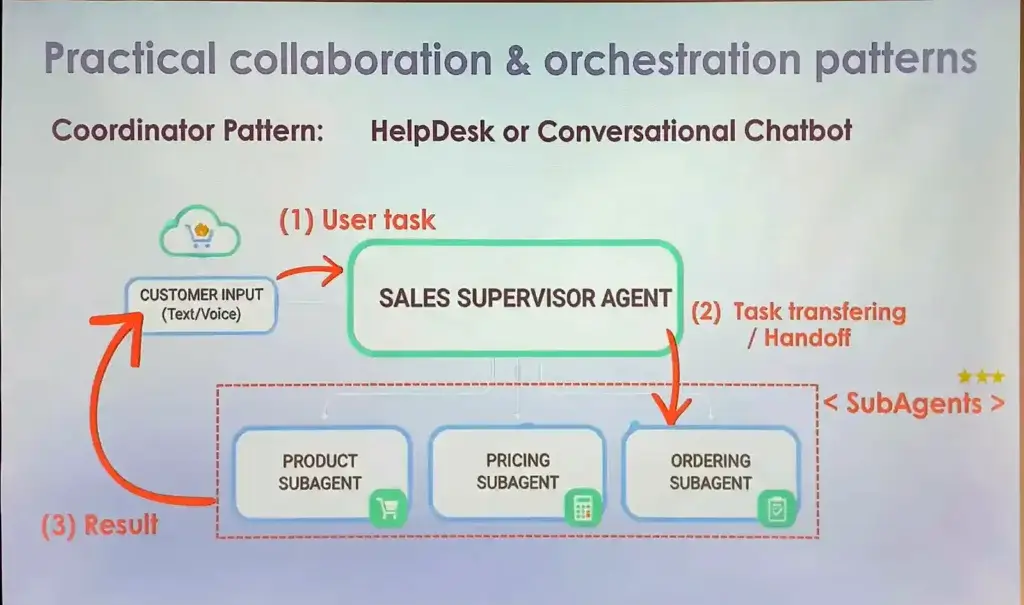

Practical collaboration & orchestration patterns

📌 Supervisor Pattern มีแนวทาง 2 แบบ hand off task / Agent as a tools tools

- Hand off task หัวหน้าเลือกงานให้ลูกน้องทำหน้าที่ตอบคำถามต่อเลย

- Agent as a tools - มองเป็น Tools เมื่อเสร็จหัวหน้าต้องมาตรวจก่อน มาเขียนคำ อาจจะไม่ต้องมี memory ทุก Agent ลด cost ได้

📌 Orchestration pattern - มีตัวควบคุม (Orchestrator) มาทำ Reasoning) และเรียกใช้เครื่องมือที่เกี่ยวข้องจนกว่าจะได้คำตอบ หรือ max iteration

- Parallel อันนี้ ไม่ recommend เพราะ ระหว่างทำงาน มันไม่คุยกัน ตอนรวมกันจะไปคนละทาง หรือต้องมาถกกันใหม่

- Single treaded - เป็นแนวทางที่ nvidia นำเสนอมองว่าตัว Agent หลัก orchestration ที่เหลือเป็น Set Of Tools ให้ LLM มา Call แล้วคิดหลายรอบแทน (Multi-Turn) แบบตัว https://github.com/NVlabs/ToolOrchestra

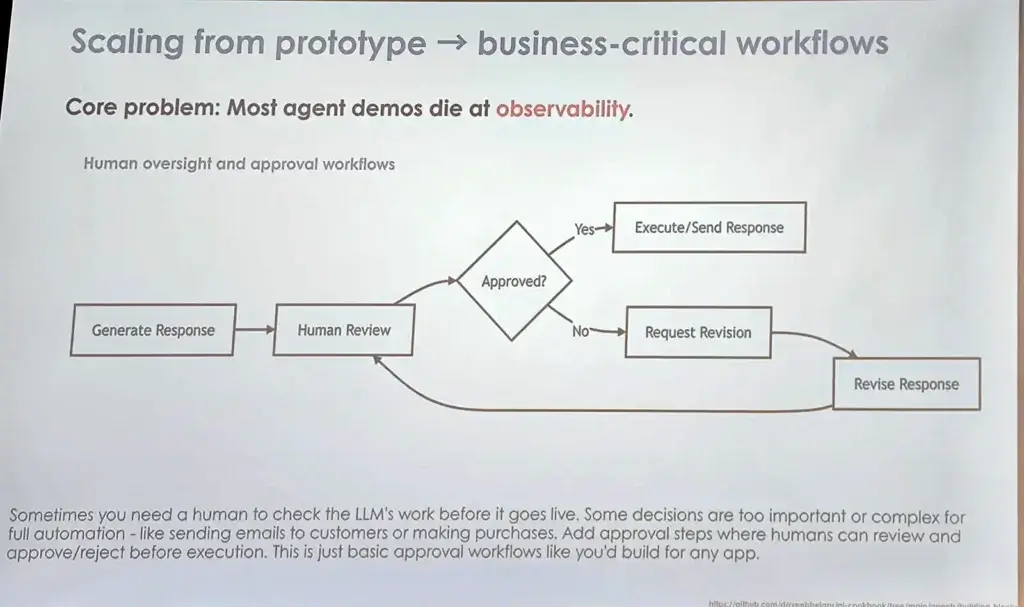

Scaling from prototype→ business-critical workflows

เราต้องเข้าใจว่า AI - LLM คำตอบ Unpredictability มันตอบแต่ละรอบไม่เหมือนกันน

ดังนั้นก่อนทำ เพื่อใช้งานจริง แบบตอบลูกค้า ควรทำในส่วนของ Observability

- Human in the loop เพื่อกันปัญหา มีคนคอยตรวจสอบ หรือปรับ Prompt ให้ตอบชัดเจนขึ้น ถ้าใน Gemini Feature Deep Research ทำแบบนี้นะ ถามเราบ่อยๆ

- Control Output

- บังคับให้ LLM ตอบเป็น JSON และมีตัว Verify (Logic /Agent) ตรวจสอบความถูกต้อง ถ้าไม่ถูกต้องให้ทำซ้ำตามรอบที่กำหนดไว้

- จัดการความไน่แน่ใจของ LLM โดยเอา Agent อีกตัวมาดู intent แล้วกำหนด handling ที่เหมาะสมได้ เพื่อคุมโทนการตอบ (แปลง Non-Deterministic > Deterministic)

นอกจากนี้ อาจจะต้องเอาข้อมูล Observability มาคุมค่าใช้จ่ายได้ด้วย แบบถ้า Token ไหลผิดปกติ คนที่ต้องเข้ามา Take Action ได้

BOTNOI มี หลักสูตร AI Agent จากประสบการณ์จริง ของ BOTNOI ลองไปส่องได้

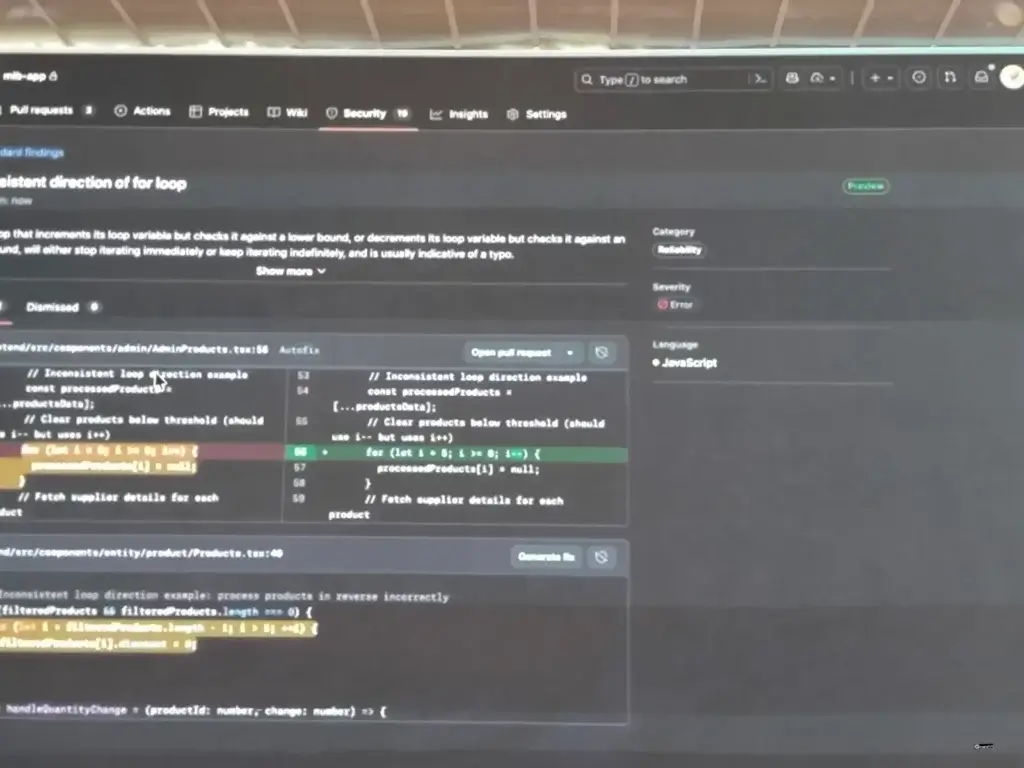

Agentic DevOps: AI-Native SDLC Transformation with GitHub

Speaker Jiratouch Mahapol

Challenge ของการสร้าง Product ของ ทีม DEV ในยุคนี้

- Codebase - complexity มันมาเยอะขึ้น จัดการยากขึ้นด้วย

- Ship faster

- เราเองขยับตัวตามไม่ทันต้อง Up Skill ให้ทันตาม Business Growth

- สุดท้ายเรื่อง Security ทุกวันนี้มีความเสี่ยงเยอะจากหลายจุด

และการทำงานแบบเดิมๆ มีหลาย Role ร่วมกันทั้ง Idea 》Design 》Implement ทำให้งานขาดช่วงได้เลยเป็นจุดที่เอา AI มาช่วยใน SDLC โดยที่ยังมี Human In the Loop เช่น

- เรียนรู้จาก Cidebase เดิม ทำให้การตอบ และแนะนำได้ตรงจุดมากขึ้น ลดปัญหาการทำความเข้าใจ Code

- Automate Task ช่วยการ Testing / Debugging เป็นต้น

- Shift Left ตรวจสอบ Security Issue

สำหรับตอนนี้จากเดิม GitHub (Source Control + CI/CD) จะมีงานเฉพาะงานอื่นๆได้ อย่าง Security / Plan / Supply Chain / Governance โดยมีเพิ่ม Feature สำหรับ Agent ดังนี้

- Agent HQ จัดการ Agent ตัวอื่น จากค่ายอื่นๆ ทำงาน ตอนนี้รองรับ Claude Code / Codex

- Coding Agent เป็น backgroud mode ช่วงเราแนะนำ Code

- Coding Agent with Security Check - เอาไว้ตรวจ Code + Security ทีเดียว

- Code Review - ตาม Rule ที่มี หรือ เอา standard ขององค์กรมาใช้

- Code Quality - maintainability Reliability ของ Code

- เปิดใช้ จ่ายตาม repo ได้ ให้ CodeQL ทำงาน

- Default Branch Policy ถ้า Quality อย่าง Test Coverage / Security ไม่ถึงห้ามลักไก่ชิงเอาเข้าก่อน - App modernization เอา AI มาช่วย แปลง legacy มาเป็น ver ใหม่ ตอนนร้รองรับ .net spting

- SRE Agent ช่วยดู Observability และมาทำ Proactive areactive เพื่อให้ app healthy

- Copilot Autofix - ตรวจจับ Code จาก CodeQL / Security สามารถทำ Remidation ช่วยแก้ไช Code เบื้องต้น และเปิด PR ให้คนมา Review ตรวจสอบก่อน Merge เข้า Branch หลักต่อไป

- และ การทำ Custom Agent ใน github มีตาม SDLC Plan /Code / Code review / Test & Secure / Operate

การจัดการ Agent จะอยู่ในส่วน Mission Control เป็นหัวหน้า กระจายงานลงใน agent ย่อยๆ ทำงานแบบ parallel หรือ sequential โดยเรากำหนด task / target branch และ agent ที่จะให้ทำงาน

และถ้าต้องการจัดการหลายๆ Repo มีส่วน Campains เพื่อทำ Standard Rule และ Apply ใช้่กับหลายๆ Repo รวมถึงเปิด Copilot Autofix มาจัดการเลยไหม ?

ภาพรวมด้าน Quality จะมี Dashboard แสดงผลการตรวจ

- Standard - Rule Base ดูพวก code มีโอกาศ null infinite loop

- AI

- CVE พวก OWASP Top Ten

นอกจากนี้มี GitHub Plan - GitHub Advancd Security - shift left เจอก่อน เจ็บน้อบกว่า โดย security จะ native ไปปนับ pr เลย ตรวจ dependency scan / secret scanning / code scanning ตั้งแต่ช่วงแรกๆเลย - ลดปัญหาปลายทาง

กลับมาที่ Coding บ้างตอนนี้ GitHub Coplilot มี 3 แบบ มีแบบ IDE / Mobile และ CLI ตอนทำงานแบบ Agent เราสามารถใช้งานตาม use case

- เราเตรียม spec หรือ ใช้ AI ช่วย

- Plan mode เพื่อดูก่อนว่า AI มันแตก Task ให้เราอย่างไร ?

- CLI มา delegate งานให้ coding agent ทำ ระหว่างมันทำงาน เราติดตามได้ และแทรกงานได้ เช่น อย่าลืมทดสอบเคสนี้เพิ่มนะ

- Review เราสามารถ Agent Code Review ตรวจสอบ ก่อน Accept PR

นอกจากนี้เรายังสามารถทำ Agent App โดยใช้ Copikot SDK รูปแบบการคิดเงิน จะคิดเป็น Request base / not token base

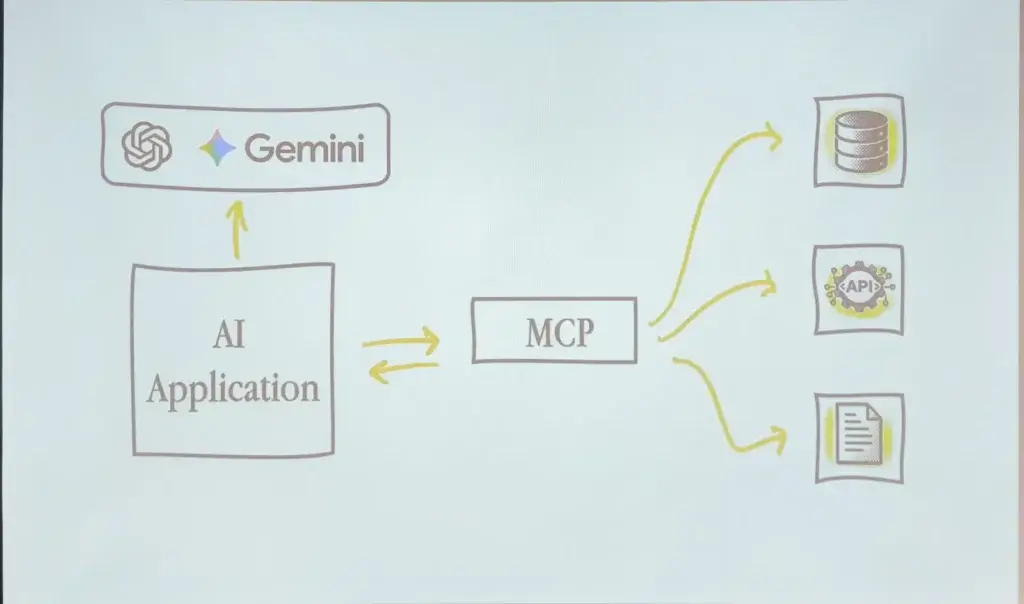

Building Tool-Driven AI with Claude and MCP

Speaker Stephen Simon

MCP หรือ Model Context Protocol เป็นมาตรฐานกลางที่ช่วยให้ AI Model (LLM) มันมีความสามารถเพิ่มขึ้น เพราะข้อจำกัดของ Model มีองค์ความรู้จำกัด และข้อมูลบางอัน อาจจะมีการมโน (hallucination) นำเสนอโดยทาง Antrophic นะ โดย Key ที่สำคัญ

- Host - เครื่องเรานี่แหละ

- Server - ตัวที่มาบอกข้อมูลให้ AI รู้ โดยมี 3 แบบ Tools / Resource / Prompt ตอนนี้มีการเชื่อมต่อ 2 แบบ STDIO / Streamable HTTP

- Client - ขา AI Agent ของเราจะเข้าไปหาว่ามี อะไรให้ AI เอามาใช้ได้บ้าง

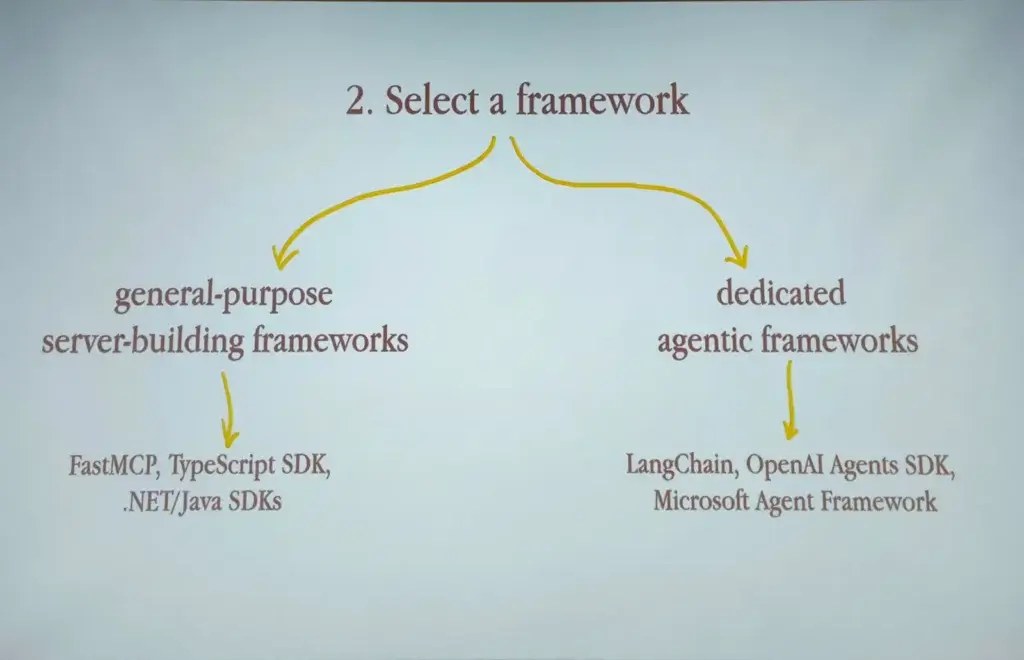

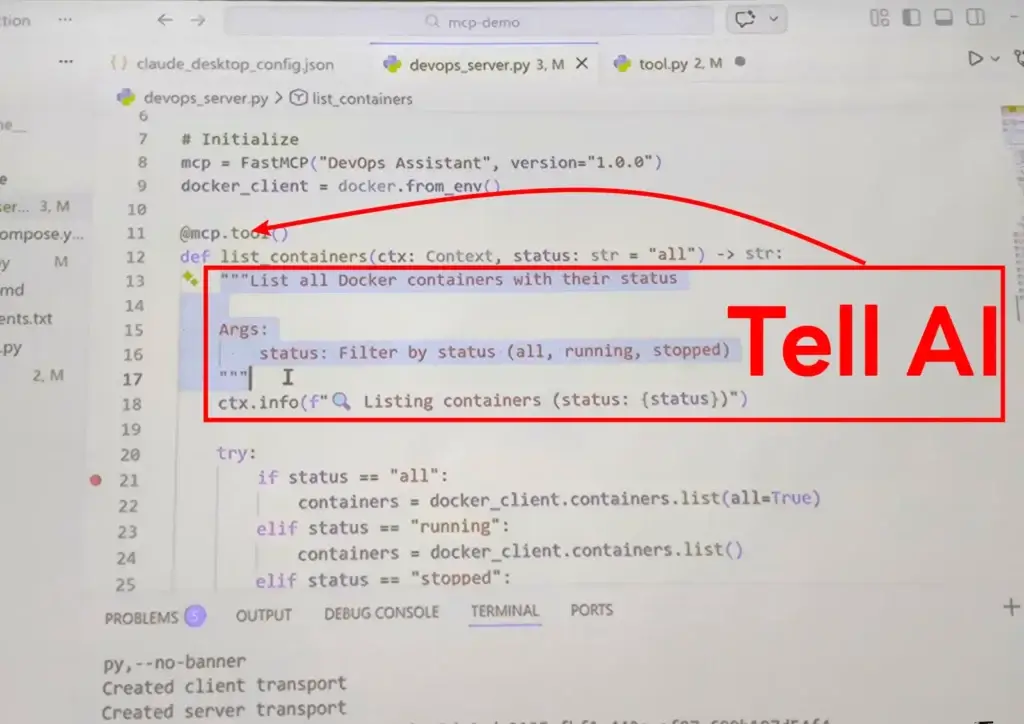

ขั้นตอนการสร้าง MCP Speaker มีคำแนะนำ 5 ข้อ

- Pick Language - หลักจะเป็น Python / Typescript

- Select framework

- General Purpose ข้อดีใช้ได้หลายแบบ แต่บางอย่างเราต้องมีเขียน Code เอง อย่างตัว Python จะเป็น FastAPI

- Specific Purpose มีการปรับแต่งมา ข้อดี เริ่มได้ไว ถ้าใน Python - FastMCP

- Write a tools

@mcp.tool()/ Resource@mcp.resource("docs://{name}")/ Prompt@mcp.prompt() - Add Authentication มันเป็นขั้นตอนที่คนมักลืมกัน ต้องมาตรวจว่าใครมีสิทธิ์แต่ไหน เข้าถึง Data ส่วนไหนได้บ้าง

- Test Edge Case ทดสอบ โดยจะใช้ Tools อย่าง MCP Inspector แล้วขยับมา App ก็ได้นะ

สำหรับ Session มี Demo DevOps MCP มาตรวจสถานะของ Microservice ที่เตรียมไว้ (Docker) Source Code ก็ตามนี้เลยครับ https://github.com/codewithsimon/mcp-demo

แอบขายของนิดนึง ผมมีเขียน Blog MCP นะ

- ลองใช้ Microsoft SQL Server mcp server กับ Claude Desktop กัน

- มาลองปรับ Code .NET(REST API) เดิมเป็น MCP Server

From Agentic AI to Physical AI

Speaker Witthawin Sripheanpol

สำหรับ Session นี้มาแหวกเลย แล้วเขียนยากสุดด้วย ความรู้เราอาจจะไม่ถึงขั้น 5555 ถ้ามีอะไรตกหล่นแนะนำแก้ได้เลยนะครับ

Buzzword Physical AI มาจากไหน ?

มาจากคุณ Jensen Huang (CEO NVIDIA) เปิดตัวคำนี้มาตั้งแต่งาน CES 2024 จนถึงปี 2026 มีพัฒนาขึ้นเรื่อยๆ โดยบอกเลยว่ายังจากยุค Agentic AI จะเป็นยุคของ Physical AI เดิม Agent as a Chatbot จะมีการพัฒนามาขึ้นต่อ Device จริงได้ นึกภาพแบบใน Starwar ที่มีหุ่นหลายๆแบบเดินสวน ทำงานคู่กับเรา

ช่วงนี้ AI มัน Hype นะต้องระวังนิดนึง บางเคสอาจจะไม่ต้อง LLM ใช้แค่ intent base หรือ ทำ few shot

ตอนนี้เป็นยุค Multi Agent / Agentic อีก

Physical AI คือ อะไร ?

ตัว AI ที่ใช้ Enviroment จริง จากเดิมยุค Agent มี LLM เป็นสมอง แล้วมีส่วน Memory และ Tools เพื่อให้ AI เรียกใช้ ทำตาม Input ที่หลักๆมาจาก Chat / File ไปทำ auto regressive เพื่อทายผลลัพธ์

ที่นี้ ถ้ามันเป็น Physical มันมีอะไรที่มากกว่า Chat / File นะ เพราะอีก 1 Input ที่ตัว AI ต้องรู้

- ตอนนี้สภาพแวดล้อมเป็นอย่างไร

- หลังจาก Action หนึ่งเกิดขึ้นไป มีผลกับสภาพแวดล้อมยังไง

จะรู้ได้ต้องมีพวก sensor และสั่ง actuator พวก arm / leg / wheel พวก robot ต่างเอาสถานะกลับมา

ตัวอย่าง สั่งให้ AI ไปหยิบแก้วน้ำ ด้านหน้า มันต้องมาหาก่อนตรงหน้ามีไหมนะ แล้วถ้าไม่มีต้องเดินหา ทางที่เดินต้อง Feed กลับไปให้ AI มันคิด และสั่ง Physical ออกมาให้สอดคล้องกัน

มันมีคนไปรวบรวม แล้วถ้าอยากทำ Physical AI ต้องเข้าใจ Fundamental พวกนี้ก่อนนะ

- Autonomy - จากเดิมที่คนคุม หรือทำตามคำสั่งที่วางไว้ ตอนนี้มันคิดเองได้ โดยจากความเข้า Semantic(ความหมาย) และ Policy (ที่คุม Style การทำงาน)

- Context Sensitivity - เข้าใจในสภาพแวดล้อมและสถานการณ์ที่เจอ เราจะรู้ได้ต้องเข้าใจ Device ที่ตัวเองมี ว่ามีแขน ขนเท่าไหร่ รับรู้ข้อมูลของตัวเอง และสภาพแวดล้อมที่เปลี่ยนไป

- Physical Embodiment - Device และเป็นข้อมูลส่งกลับไปให้ AI ด้วยนะว่าขยับ ลงแรงไปเท่าไหร่

- Sensory Perception - ข้อมูลจากเซ็นเซอร์ เช่น กล้อง (Vision), เสียง (Audio) หรือ พิกัดที่อยู่ เป็น Information นิ่งของเอาเข้าไป AI

- Motor Competence - เอาข้อมูล AI สั่งไปทำงานและ ผมที่ได้มี Feedback กลับมาด้วย เช่น ให้ไปหยิบมาม่าหมูสับ สิ่งที่ตอบกลับมามันมีไหม

- Learning Capability - เอา Feedback จาก Sensory / Physical / Motor Competence กลับไปให้ AI คิด แล้วตีความว่าสิ่งที่ทำตรง Semantic และเพิ่ม ลด Policy อะไรบ้าง

Model AI อันนี้จะกลุ่ม frontier model เข้าว่าเป็นยุคถัดไปจาก Gen AI

Challenge Physical AI

ยังไม่มี General AI ที่เอาไปแปะ Apply กับ Physical Device แล้วใช้งานได้เลย ต้องมีการ Training ใหม่ตาม Physical Device นั้นๆ เช่น Robot มี 2 แขน 4 แขน หรือ เดิน 8 ขา ต้องมี Pattern การเรียนรู้ที่ต่างกัน

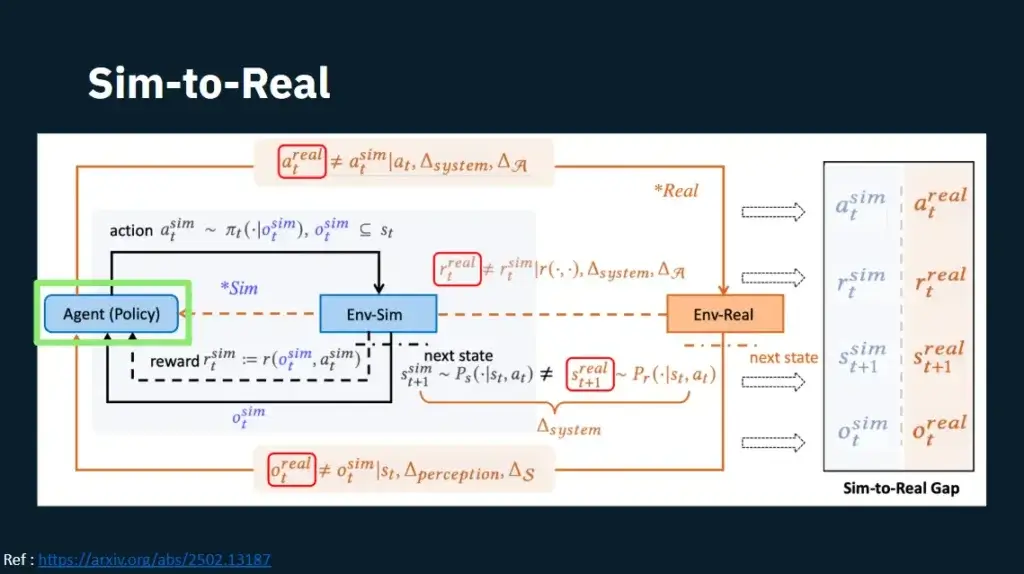

Simulation > Real Physical AI (World Model)

การเรียนรู้มันจะใช้ Cost มหาศาลเลยนะ พวก GPU / ไฟฟ้านี้แหละ รวมถึง Device จริงๆ อาจจะช้าและ ในที่นี้เลยมี Idea ว่าเอาสภาพแวดล้อมมาสร้างฉาก คล้ายใน Game แล้วทำ Simulation สิ

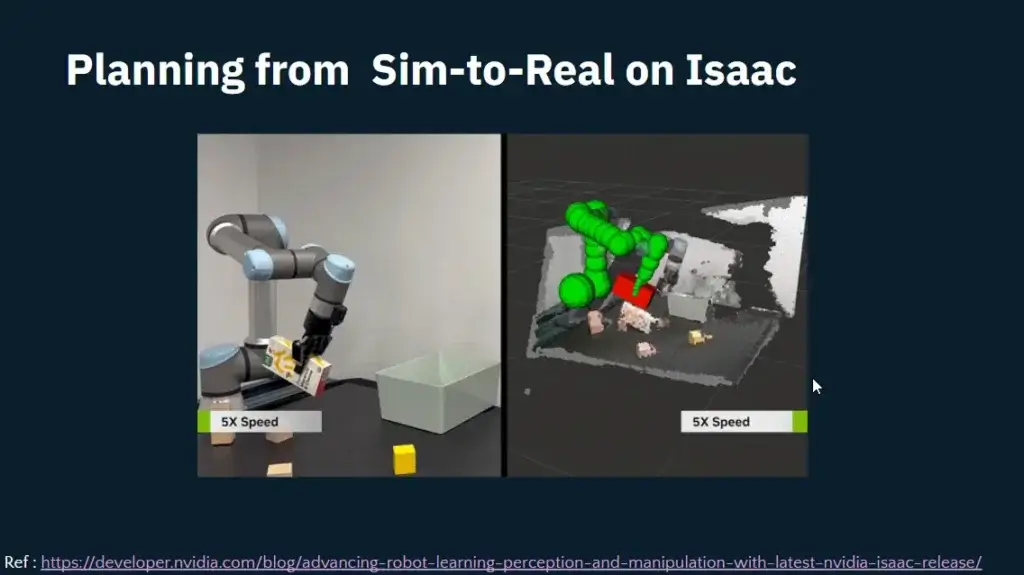

ถ้าใช้ Simluation อีกอันที่ทำได้การ Scaling Agent on parallel execetion เอา dataset หลายๆแบบมาลองให้มันเรียนรู้ พอมันจำ pattern ได้ แล้วมาสรุปว่า เฮ้ยเราจะขยับนิ้วแบบไหนได้ดี เหมาะสมที่สุด

ตอน Sim เราจะได้ข้อมูล Obsdervation ระดับนึง มองเป็น Memory Stream ก็ได้ เข้า reward func และทำ back propagation วิธีการเดียวกับ LLM เพิ่มข้อมูลจาก Enviroment รอบข้างยัดเข้าไปด้วย ซึงถ้าจะให้แม่นต้องทำสภาพ Envirment ให้เหมือนจริงมากขึ้น พอได้ข้อมูลระดับนึง เหมือนได้ยินว่า 5 -10 Frame นะ ก็เอาไปสรุปส่งให้ Device เอาไปทำงานอีกที

แต่มันมีปัญหานะ

- Noise จะได้จัดอะไรที่ไม่เหมือนตอนเทรน อารมณ์เรียนตอนเรียน กับตอนสอบ ซึ่งอันนี้แก้โดยเอาพวก Diffusion Model / กฎทางฟิสิกส์ (Physical) จาก 3D Blender / Unity มาทำให้สมจริง รวมถึงการทำ Hybrid Sim-Real Synchronous เอา Env จริงมาโยนเข้า AI จากพวก กล้อง (Vision), ไลดาร์ (Lidar) และ Depth Camera

- Data ที่ไม่เพียงพอ อันนี้เอา Diffusion มา Gen เพิ่ม

Project ที่เกี่ยวข้อง

- Google เอา 3d env เข้ามา train ให้รู้จัก และมีการตอบสอบกัล env ตัว sima deeepmind พวกเอาพวกฉากในเกมมามองลองเล่น และตัดสินใจ

- NVIDIA Isaac: เป็น Project ที่ใช้ทำ Parallel Simulation และการทำ Transfer Know-how จาก Simulation > Real Device

- World Model พวก JEPA

Resource: Slide พวกสูตร Paper ดูในนีนะ เขียน Blog ไปตาลอยไป 55

Unlocking Context Engineering with Microsoft Foundry and Neo4j

Speaker Zaid Zaim / Christian Glessner

AI ไม่ใช่ Silver Bullet ทุกปัญหา การจะเอา AI มาใช้ เพื่อตอบข้อมูลในองค์กร โยนไปตรงๆ มันจะเป็นแบบ Shit In, Shit Out (เอาเอี้ยอะไรมาเนี่ย เสียงในหัว AI 555)

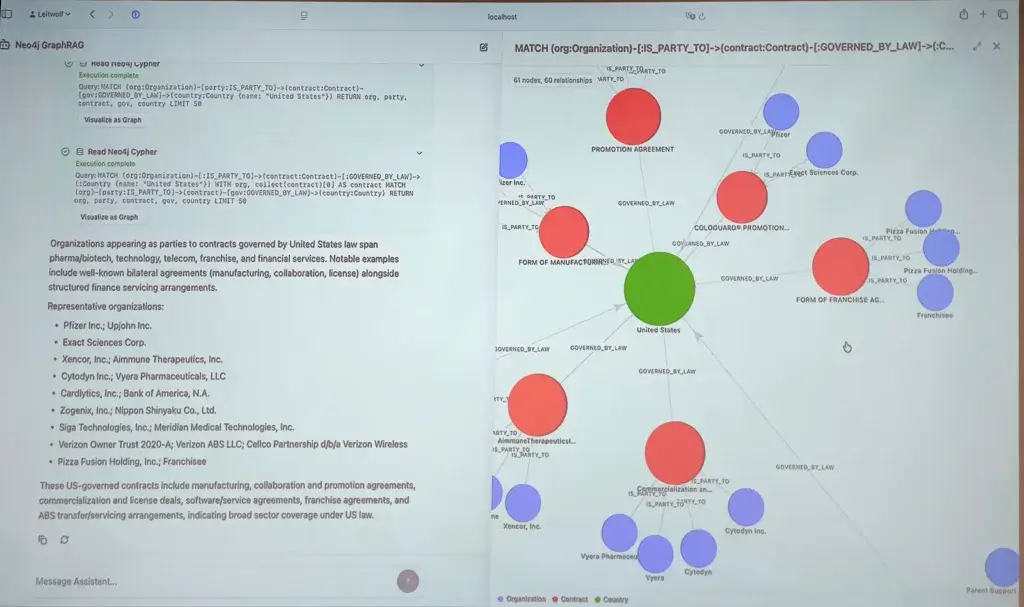

สิ่งที่เราควรทำเข้าใจข้อมูลเดิมที่มีก่อน และจัดระเบียบให้เรียบร้อย สำหรับใน Talk นี้จะเอา Graph มาเป็นตัวช่วยจัดความสัมพันธ์

Context Engineering การทำเข้าใจบริบทของข้อมูล มีวิธีทั้ง Prompt Enginnering / Memory / State (history - chat) / RAG รวมไปถึง Stucture Output ด้วย สำหรับเคสนี้ใช้ GraphRAG

สำหรับ Sesson นี้ลองอ่าน GraphRAG in Action with Microsoft Agent Framework & Azure AI Foundry ของงาน AI Community Day Bangkok 2025 มันต่อยอดอีกทีครับ

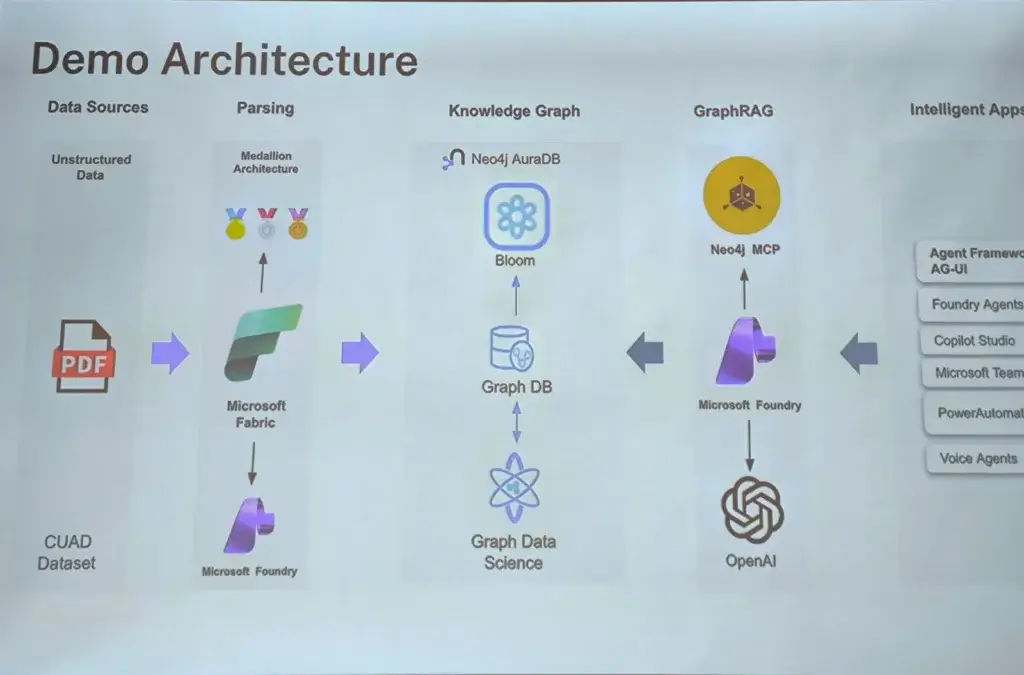

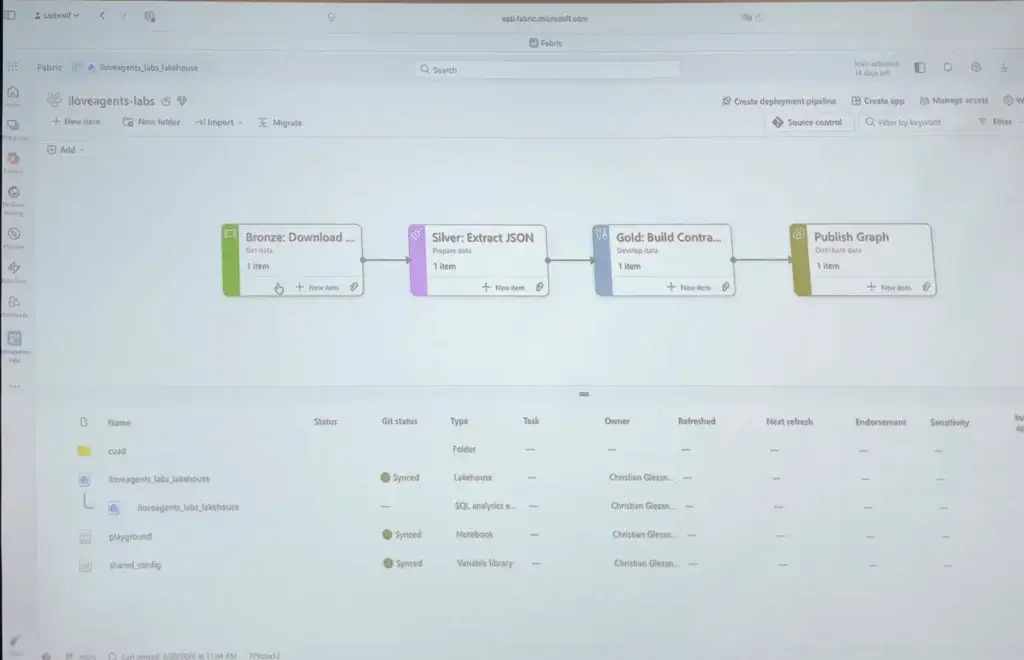

Tech Stack จะ Improve มาจากของเดิมที่เป็น CLI Base ดังนี้

📌Microsoft Fabric + Azure Content Understanding มาช่วยในการแปลงข้อมูล Contract Understanding Atticus Dataset (CUAD)

- ที่ใช้ Azure Content Understanding เพราะมีความแม่นยำ (83.5%) ในการทำ Field Extraction แปลง PDF > JSON มากกว่า กว่า GPT-4 (64.4%)

- ขั้นตอนการทำงาน Microsoft Fabric แบ่ง 3 ระดับ น่าจะฟังถูกนะ

- Bronze Layer - จัดการข้อมูลดิบ จากไฟล์ zip, แตกไฟล์ออก และเก็บข้อมูลเหล่านั้นไว้ใน OneLake

- Silver Layer - Field Extraction แปลง PDF > Markdown > JSON

- Gold Layer - Data Cleaning เช่น คำเดียวกัน เขียนตัวเล็กใหญ่ เอา AI มาแปลง และบันทึกข้อมูล Delta Table Graph Database (Neo4j)

📌Neo4j Aura - เอาข้อมูล Vector Embeddings จาก Fabric มาเก็บไว้ ตอนนี้ Neo4j Bloom (Query) / Neo4j Graph Data Science (หา Insight พวก Graph)

📌GraphRAG - จาก Neo4j MCP + Foundary(OpenAI Model) และ Data ใน Neo4j

📌Intelligent App เอา App มาเชื่อมกับ Foundary ซึ่งทได้หลายแบบ Foundary Agent / Copilot Studio / MS Team / Power Automate / Voice Agent หรือ ถ้าสาย Code Microsoft Agent Framework (AG-UI) มาแสดงผลได้

อ๋อ และมีฝากงาน 2 อัน Course graph RAG academy By Neo4j (ไปเรียนกันได้) และมีงาน Live Neo4j Node AI - April 15, 2026 at 7am PT | 15:00 BST

Microsoft Fabric IQ: Turning Unified Data Into Unified Intelligence (Data Agent & Operations Agent)

Speaker Napol Hengbumrung

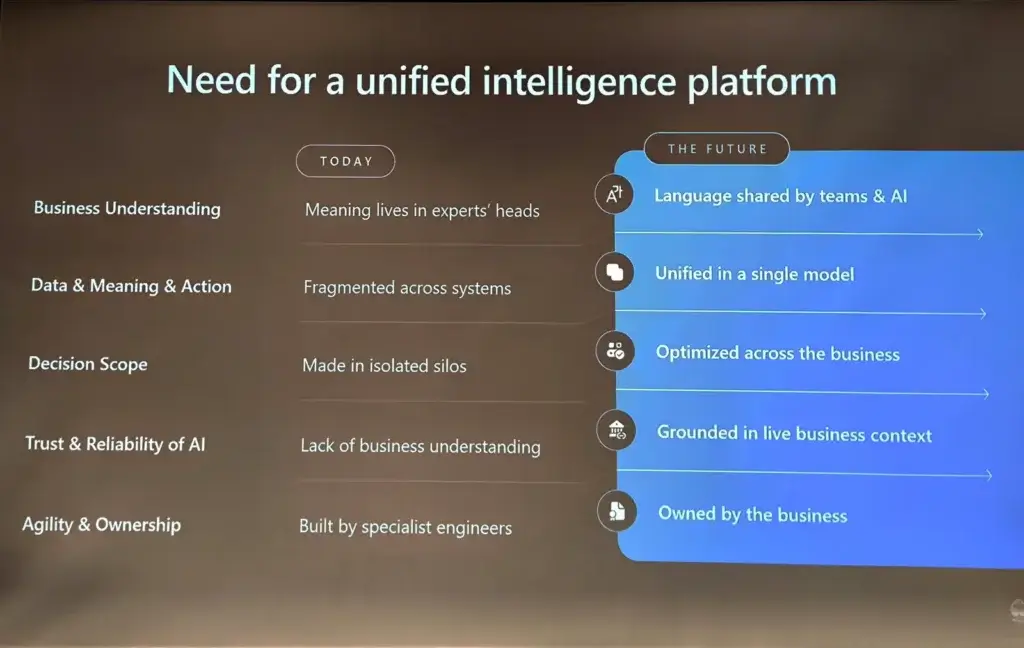

AI transform the world - ในมุม End User - Classic use case สรุป pdf ต่างๆ Work แต่ทว่ามันยังมี Use Case ที End User ยังมองว่าไม่ Work อย่างเคสการโยน Excel ลงไปให้มันสรุปยอดต่าง ออกมาให้ อันนี้ AI ยังทำผิดพลาดอยู่

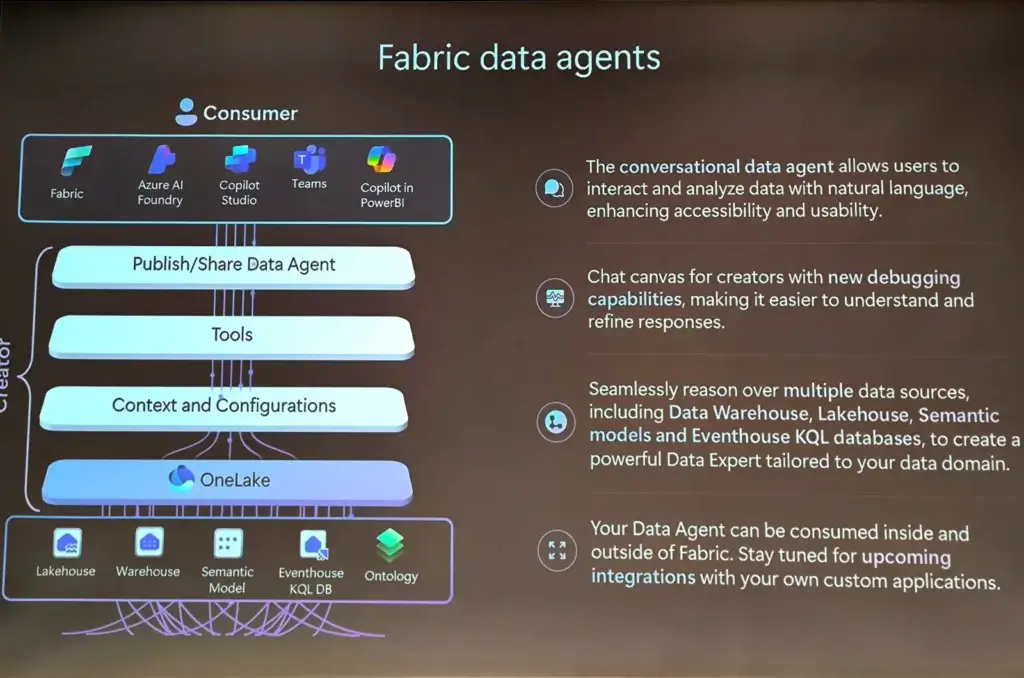

ทางแก้ของ MS เลยออก Product มา เพื่อช่วยให้ Data ที่มีหลายๆแหล่ง unify อยู่ที่เดียวกัน โดยมี tools มากมาย ตามรูปเลย

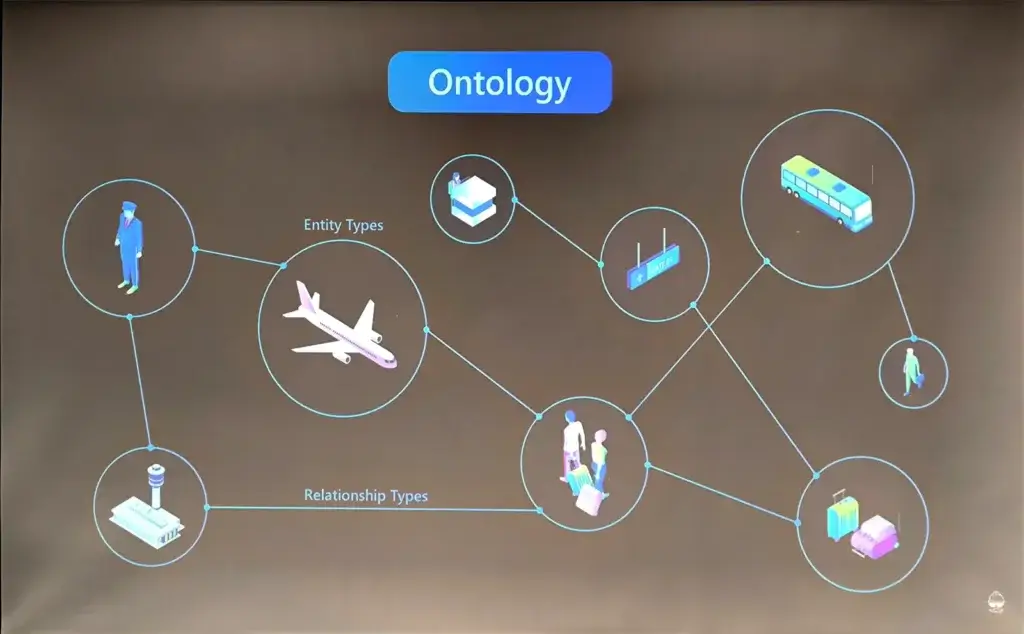

Why Unify

Data แต่ละอันมีนีความสัมพันธ์ เช่น เครื่องบิน สัมพันธ์กับ นักบิน / ผู้โดยสาร ถ้าข้อมูลส่วนใดส่วนนึง หลุดไป เช่น คนตกหล่น แต่เกิดจาก Process สายการบิน แต่พนักงานหน้างานไม่ทราบสถานะ ทำให้การสื่อสารผิดพลาด และดราม่าได้

รวมถึง Object ชิ้นเดียวกัน แต่ทว่าแต่ละแผนมองมีความหมายเรื่องเดียวกัน ต่างกันไป ทั้งในมุม place / engineer / finance เป็นต้น

สิ่งที่ Fabric IQ ปรับมา

📌Semantic models (Data Model เดิม) ซึ่งตอนทำงานจริง เราต้องจับเจ้าของ Data มาคุยกัน มายุบ Entiry อาจจะต้องจัดการพวก Key ให้ชัดเจน

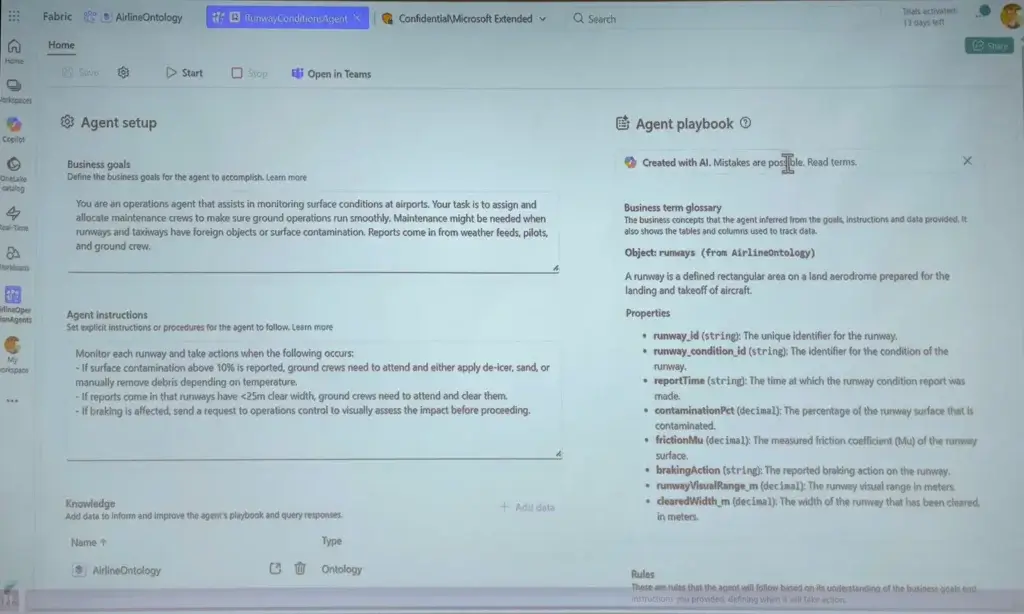

📌Ontology

- เป็นอีก View นึงที่มาช่วยอธิบายความหมายและความสัมพันธ์ของแต่ละ Entity ซึ่งมันช่วย Guide AI ให้ไปหาของที่ถูกต้องได้

- ในตัว Ontology มีให้กำหนด Properties (Static หรือ Timeseries) / Relationships รวมถึง Rule Policy และ Action ที่เกี่ยวข้อง

- Tools เป็น No Code นะ

- พอมี Relationships > Knowledge Graph > มันจะช่วยให้ AI Agent ทำ multi-hop reasoning

จากนั้นมี AI Agent เพิ่มมา 3 ตัว

📌Data Agent (plan f2 ขึ้นไป)

- เอาข้อมูลเดิมๆมี่มี จัดโครงสร้างไว้แล้ว อย่าง Data Model / Ontology

- ไปเชื่อมกับ ms team / foundary มาตอบคำถามได้ หรือ อื่นๆก็ได้ การทำงานมันต่างพวก RAG เพราะ เรามี Schema ให้ AI มันเข้าใจ แล้วเขียน Query ออกมาได้ รวมถึงคุมตาม Policy และ Rule ที่ครอบไว้

- เชื่อมได้ 5 Data Source

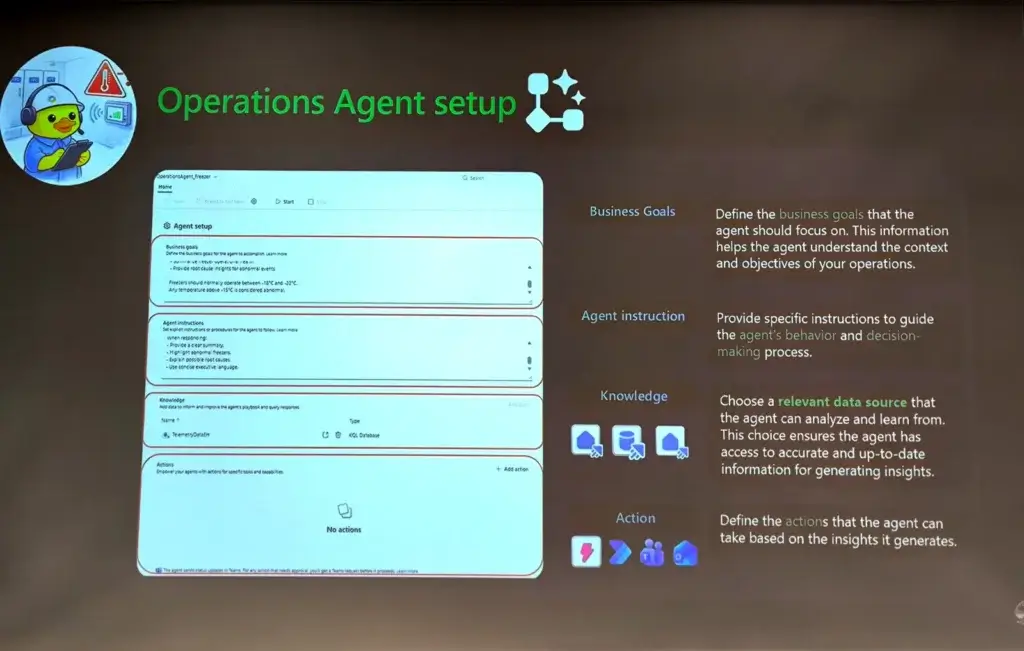

📌 Operation Agents

- พอเรามี Data + Schema เรามา Topup ส่วน Data มาเป็น Action ได้ ตาม Trigger หรือ Realtime Activator ได้ โดยตรงนี้เราเตรียมพวก Knowledge มา Guard มันได้นะ

- ตัว Action ก็ไปเรียก Power Automate

- สุดท้าย playbook ออกมา ที่ถูก Design ตาม business rules

📌 Foundry IQ Agents - Knowledge Base ขององค์กรจาก Structure / Unstructure Data

Resource: Fabric IQ / วิศวกรเป็ด

AI for Product Developer

Speaker Chokchai Phatharamalai

ตั้งแต่มี AI เข้ามาปัญหาของ Productivity ถูกแก้ไป และได้ดีด้วย แต่มันก็เกิดปัญหาใหม่ขึ้นมา Code มันใช้ได้แหละ แต่ไม่รู้ว่าข้างในมันทำอะไร พอมี AI เข้ามาเลยจะมีคน 2 แบบ

- Tap style - ตรวจก่อน ค่อย Apply ลง Code เรา ซึ่งคนกลุ่มนี้ ไว้ว่าจะเปลี่ยนไป AI Model จะความเร็วเท่าเดิม

- All in AI - ให้ AI ลุยแก้ Code เลย ให้มันทำงานได้ อาจจะให้ AI มา Review เดี๋ยวมีปัญหาค่อยถาม AI เอา

จริงๆแล้วปัญหา มันใช้ได้แหละ แต่ไม่รู้ว่าข้างในมันทำอะไร มีมานานตั้งแต่ยุต Stack Overflow นะ แต่พอมี AI มา Gap นี้มันกว้างขึ้นเรื่อยๆ

ที่นี่ลองนึกภาพว่ามันพังที่ Prod ถ้าเราไม่เข้าใจที่ AI ยัดลงมือ งานหยาบเลยนะ เพราะเวลาที่ใช้ Debug มันยากกว่าตอนสร้างขึ้นมา //เอาจริงๆ ที่ บ มี Dev Style นี้สาย Create แต่ไม่ Maintain มันกินเวลาชีวิตจริงๆ

แก้ Code มันใช้ได้แหละ แต่ไม่รู้ว่าข้างในมันทำอะไร ยังไง !!!

📌อย่างแรกเลย Back 2 Basic เน้น Problem Solving ก่อนจะใช้ AI ให้ทำ 3 อย่างนี้ก่อนด้วย

- Learning - ถามเลย ว่าที่ AI มัน Genๆ มา ทำอะไร เพื่ออะไร ให้มันสอนเรา ดีกว่าสอดไส้

- Decision - ตัดสินใจ ให้นี้ Human in The Loop คน ตัวเราเอง ต้องต้ดสินใจ เพราะเราต้องเข้าใจที่ AI มันยัดมา ถ้าไม่เข้าใจ อาจจะหาคนอื่นมาช่วย Review ตัดสินใจได้

- Make Change ให้ AI Apply + Test

📌Gen AI Usefulness formular f(Model, Product, Your Skill) - ใช้ AI ให้แจ่มต้องเข้าใจ 3 องค์ประกอบก่อน

- AI Model มีหลายค่าย OpenAI / Claude หรือ พวก OpenSource

- Product ตัวเชื่อม Model พวก UI ChatGPT หรือ พวก Copilot / Cursor อันนี้ Speaker แนะนำเลือก Product ที่ไม่มี AI Model มันจะบังคับให้ optimize ใช้ได้กับทุกเจ้า และมีการคุม Context ได้ดี เพื่อคุม Cost

- Your Skill

📌สุดท้ายการใช้ AI ต้องมีการวัดผล เอาง่ายๆ Framework PDCA มาตอบโจทยฺ์

- Plan (Plan Mode/ Thinking)- เข้า AI Plan Mode ใน copliot / Cursor เราจะได้ดูว่ามันจะทำไร แล้วเราดูแล้วมัน make sense ไหม

- Do (Action Mode) ให้ AI มันทำงาน เบื้องหลังที่เราต้องรู้ Input ที่โยนให้ AI มันมี

- Prompt

- History

- Rule พวก skill / llm.txt / openapi / บังคับ Style / Architecture / ทำ Test

- Attachment - Example / Best Practice ต่างๆ - Check - ควรมี Automate Test สำหรับตรวจใน Level Unit / e2e Test

Test ยิ่งมีเยอะ จะช่วยให้งานเราเดินไว มันช่วยจับผิด สิ่งที่ AI ยัดมาได้ รวมถึงเพิ่มความมั่นใจก่อนส่งมอบด้วย

- Act มา Review + Improve

- Clear context ลดปัญหา การหลอน โดยการ clear chat

- Verifiy ผลที่ได้ และ adjust rules

- Adjust prompt

📌Consideration Note

- พยายามเก็บ Asset พวก Rule / Test / OpenAPI / Design / Architecture Note เพราะเวลาเราเปลี่ยน Tools หรือ เปลี่ยนคน ของพวกนี่้จะช่วยให้ AI หรือ แม้แต่คนแรก ทำงานไม่สะดุด

- ทำ Data Goverance ให้เรียบร้อย แยกส่วน Personalize Data / Tracing Data ออกจากกัน มันจะช่วย

- กันพวกของ หลุดให้ AI

- ทำ Observability ได้ดีขึ้น เวลาพังสามารถซ่อมได้เร็ว หรือ ให้ AI Agent มาแก้ แล้วเรามาดู PR ตรวจก่อนเข้า Branch หลัก

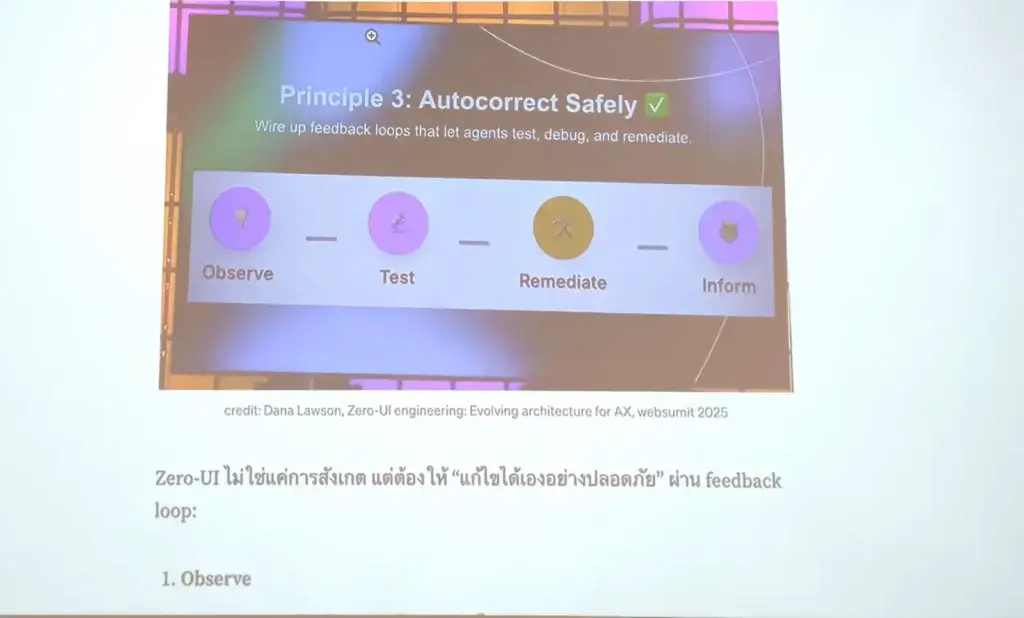

มี Blog Zero-UI Engineering: 3 Principles และ 5 ขั้นตอนสู่สถาปัตยกรรมที่ “คิดได้เอง” - Principle 3: Autocorrect Safely

Engineering Practice ต้องดีก่อน แบบ hardcode dbname อย่าหาทำ ถ้าเรื่องนี้แข็ง เวลาเอาไปใช้กับ AI จะไวขึ้นด้วย

ถ้าของเรามันดี สะอาด มีระเบียบ AI จะเข้าใจง่าย ตาม Blog UX → DX → AX เมื่อผู้ใช้ไม่ใช่แค่ “มนุษย์” แต่รวมถึง “AI Agents” ด้วย

Practical and Essential Design Patterns for Building Agentic Systems

Speaker Tanisorn Jansamret

อันนี้เหมือนมาเสริม Session How to Stay Sane in the Age of Agents / Why Multi-Agent Systems? Designing Collaborative AI for Real Products

AI Agent

ถ้าทำ AI Agent อันนี้มาเราต้องมีปัญหาอะไรบ้างต้องมาคิด ?

- Learning Curve - ของทีม และคนที่เกี่ยวข้อง

- Lack of control & flexibility

- Limit Visibility - เราไม่รู้ blackbox ที่ซ่อนไว้

- Challenge to build amd maintain

ฝั่ง AWS เลยออกตัว strands-agents โดยที

- มันเป็น Open Source (Python/TypeScript)

- การทำงานแบบ Agentic Loop มี 2 ส่วน

- Reasoning เอา ความสามารถ Reasoning ของ Model (Thinking) มาให้เลือก Tools ที่เหมาะสม หรือไม่ใช้

- Action - Call Tools และเอาผลที่ได้มาเป็น Feedback loop และ Generate a final response - ใช้ Model ของค่ายไหนก็ได้

- รองรับ Protocal A2A

- Multi Agent Orchestration

- รองรับทำ Safeguard / Guardrail ในตัว Evaluation

- เหมาะสำหรับ Prod เพราะมีการจัดการ Observaability ในตัว

- มี Tools ต่างๆ

- Built In มา อย่างพวก Calculator / http_request

- Multi-modal

- ถ้าไม่เพียงพอเอาพวก MCP ที่มีอยู่แล้วมาเชื่อมได้ รวมถึงทำ Custom Tools - มีพวก Monitor / Observability ในตัว

- Integration - AWS, AgentCore Memory, LiteLLM, Mem0, RAGAS, Tavily และ Langfuse

Scale Idea / Design Patterns

เจ้า strands-agents รองรับ Pattern จากที่ความอิสระในทำงานจากน้อยไปมาก

Agent As A Tools >> WorkFlow (Control) >> Graphs (Balance) >> Swarms (autonomy)

| หัวข้อ | Agents as Tools | Workflow | Graph | Swarm |

|---|---|---|---|---|

| Idea | โครงสร้างแบบ "หัวหน้า-ลูกน้อง" | ต้องการระบบที่ทำงานตามลำดับขั้นตอนที่แน่นอน | ควบคุมเส้นทางการทำงาน แต่ยังต้องการให้ AI ช่วยตัดสินใจในแต่ละจุด | ห้ Agent ทำงานร่วมกันแบบอิสระ แบบทำงานกลุ่มระดมสมอง |

| Control Flow | Orchestrator เป็นผู้ตัดสินใจ | ไหลตาม Flow ที่กำหนดไว้ - Deterministic | AI ตัดสินใจตาม Nodes / Edges ที่กำหนดไว้ | Agent ตัดสินใจส่งต่องาน (Handoff) ให้กันเองตามความเหมาะสม |

| จุดเด่น | Separation of concerns | Systemic - ถ้า Task ก่อนหน้า Fail ก็ตีตรงหมด | รองรับการทำงานแบบ Basic / Parallel Error Handling | Complex Task ส่งต่องาน และมี Max Loop ไว้คุมจำนวนรอบ ไม่ให้เสีย Token |

| Shared Context | Tools Parameter | ส่งต่อผลลัพธ์ในแต่ละ Task | shared dict object | shared context or working memory |

| Cycle (Loop) | N | N | Y | Y |

นอกจากนี้ ถ้าเป็นการสื่อสารระหว่าง Agent ค่ายอื่นๆ สามารถใช้ Protocal A2A

Resource Multi-agent Patterns (Strands Agent)

อื่นๆ - ที่เข้าไปฟังแป๊บนึง / Workshop Resource

- Multi-Agent Systems in Business - เหมือนผมเข้ามาช่วยท้าย Q&A แล้ว จับใจความสำคัญว่า WebApp ยุคนี้ นอกจาก for Human ต้องทำสำหรับ Agent แนวๆคิด SEO

- สำหรับ Workshop Getting Started with Coding Agents using GitHub Copilot (Sirasit Boonklang) ถ้าใครไม่ได้เข้ามาดูในนี้ได้เลย GitHub - aeff60/agentcon-bkk-2026-coding-agents

- Workshop From Single Agent to Agent Orchestrator: A Stage-Based Architecture with Microsoft Foundry (Mihail Mateev)

- Doc: https://github.com/mihailmateev/agentcon-workshop

- Code: https://github.com/mihailmateev/foundry-agentcon-csharp-v03

แล้วก็เดือน 5 จะมีจัดงาน AgentBootCamp Bangkok

Blog ท่านอื่น

- Agent Con Bangkok จุดเริ่มต้น และ keynote By Apipol Sukgler

- พัฒนา AI Chatbot กับเอกสารทางกฎหมาย ในงาน Agent Con by Thannob Aribarg

- สรุป Workshop: Low-to-No-Code Open Source Agentic Solution for Dev & Biz with Langflow จากงาน AgentCon Bangkok (Charunthon Limseelo) by Insightist AI Transformation Thailand

Reference

Discover more from naiwaen@DebuggingSoft

Subscribe to get the latest posts sent to your email.