งานนี้ผมได้บัตรมาแบบงงๆเลย เพราะจะลองเข้ามาฟังหลายปี แล้วไม่ได้บัตร ปีนี้ได้เฉย เลยมาฟังและจดๆไว้ โดยมีหัวข้อ ส่วนใหญ่ไปทาง AI น้า ลองอ่านกันได้

Welcome Opening

Speaker Norasit Sitivechvichit

เริ่มต้น Speaker ตั้งคำถามว่า ประเทศไทย เรามี potential จะก้าวขึ้นไปด้วย Tech อย่างไรบ้าง โดยมีการตั้งคำถาม Source GitHub

📌 How many Devs in Thailand ?

- ไทยเรายังมีสัด Dev ต่อประขากรทื่ยังน้อยอยู่ 12 คน ต่อประชากร 1000 คน แต่ถ้าเป็น 166 คนต่อ 1000

📌 Outcome จาก Dev (Android Apps)?

- Trend คล้ายกันครับคำถามที่แล้วครับ

📌 Efficiency (Apps Per GitHub Dev)

- พบว่าข้อมูลตรงนี้ของไทยต่างออกไปนะ มีทำได้สูงพอๆกับ USA และมีหลายตัวที่เติบโต จาก Startup มาเป็น Unicorn อย่าง Lineman BitKub เป็นต้น

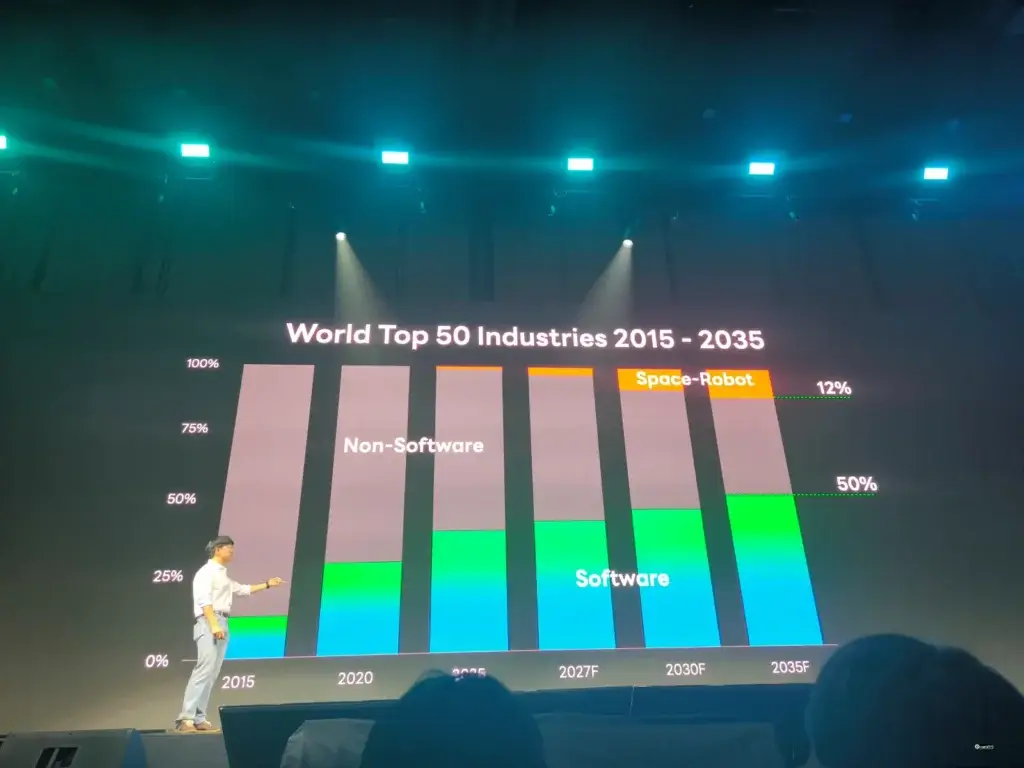

📌 ถ้ามองในมุม Global World Top 50 จะพบว่าสัดส่วนของ บ Software + AI + Robotic มากขึ้น อันนี้ AI ลอง forecast ไปถึงปี 2035 แสดงว่า ไทยเราตอนนี้เริ่มลงมือทำ สร้าง Community เพื่อ share และขยายวงความรู้ต่อไปครับ

Keynote: LINE Platform Strategic Vision and Roadmap

Speaker Weera Kasetsin

งาน Line Dev Conf จัดมาเป็นปีที่ 6 แล้ว โดยเริ่มมาตั้งแต่ปี 2019 และเปิดตัว Open Platform ปี 2024 และสำหรับปีนี้เน้นฝั่งการศีกษามีจัดบัตรสำหรับนักเรียนย นักศึกษาโดยเฉพาะ

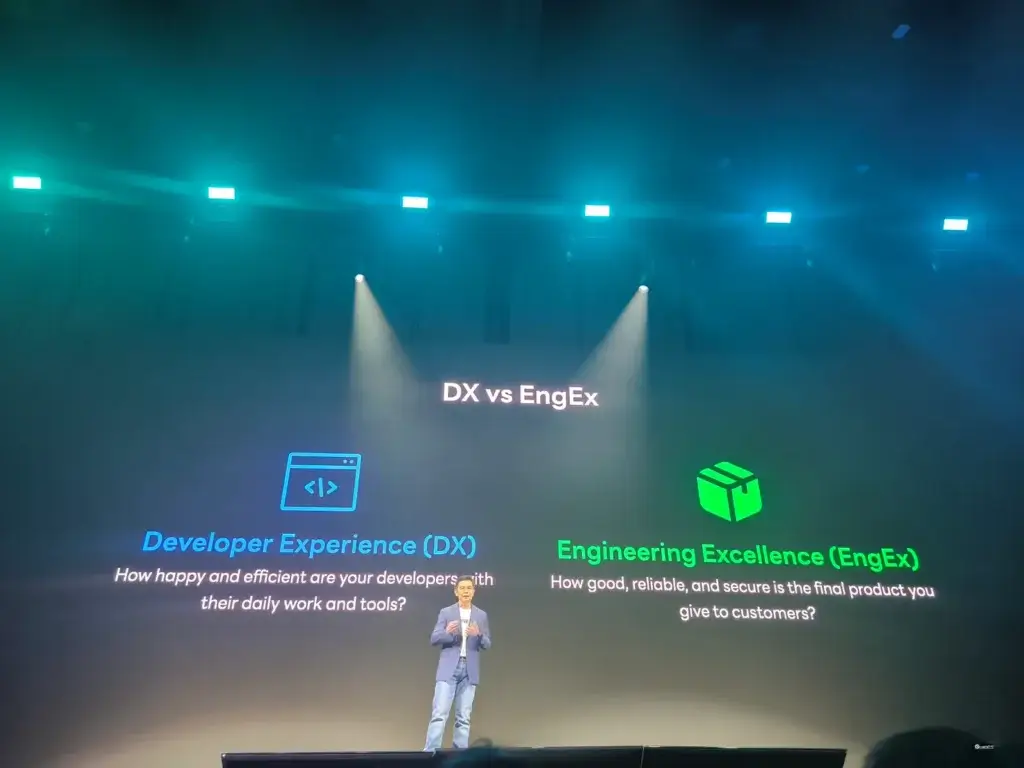

สำหรับปี Line มาใน Theme Engineering Next Gen-Experience 2025 เอา AI มาใช้ในการทำงาน เพิ่ม productivity จากเดิมที่เน้นส่วน DX (Developer Experience) dev ง่ายสะดวก ปีนี้จะเพิ่มในส่วน EngEx (Engineering Excellence) ให้คนที่ใช้ของต่อจาก Dev ทีมรอบข้าง Pather / User Happy มาขึ้น โดยจะส่งเสริมไปใน 4 มุม

- People - มีการแชร์ km เข้า comminuty จาก Line API Expert มากขึ้น

- Tech - ทำให้ Open Platform ง่าย และสะดวกมากขึ้น

- Process - เพิ่ม starter kid / cli tools ทำมาเพิ่อ dev ให้เริ่มทำงานได้ง่าย

- Product - อะไรที่มีแล้ว เราสามารถต่อยอดได้ จากตัว mini app / bot marketplace และ seamless payment

Resource: https://speakerdeck.com/linedevth/keynote-line-platform-strategic-vision-and-roadmap (Slide)

LINE API Essential Updates for 2025

Speaker Jirawat Karanwittayakarn / Warit Wanwithu

วันนี้ที่ 13-SEP International Programmer's Day เวลาลงตัวแบบพอดีเลย สำหรับในส่วนของ Tech มีส่วน Update 6-7 เรื่อง ดังนี้

📌 Community เปิดมามาตั้งแต่ ปี 2018 user 53k

📌 API Usage ของ

- Line Chatbot มี 680k + 25%

- Liff (web framework ใน line) 330k +30%

📌 Messaging API

- AI Agent with Line Bot MCP Server ( เช่น เราเอา Line Bot เชื่อม Claude Desktop มาทำ Liff ได้) เดี่ยวมี Session Demo ตอนท้าย

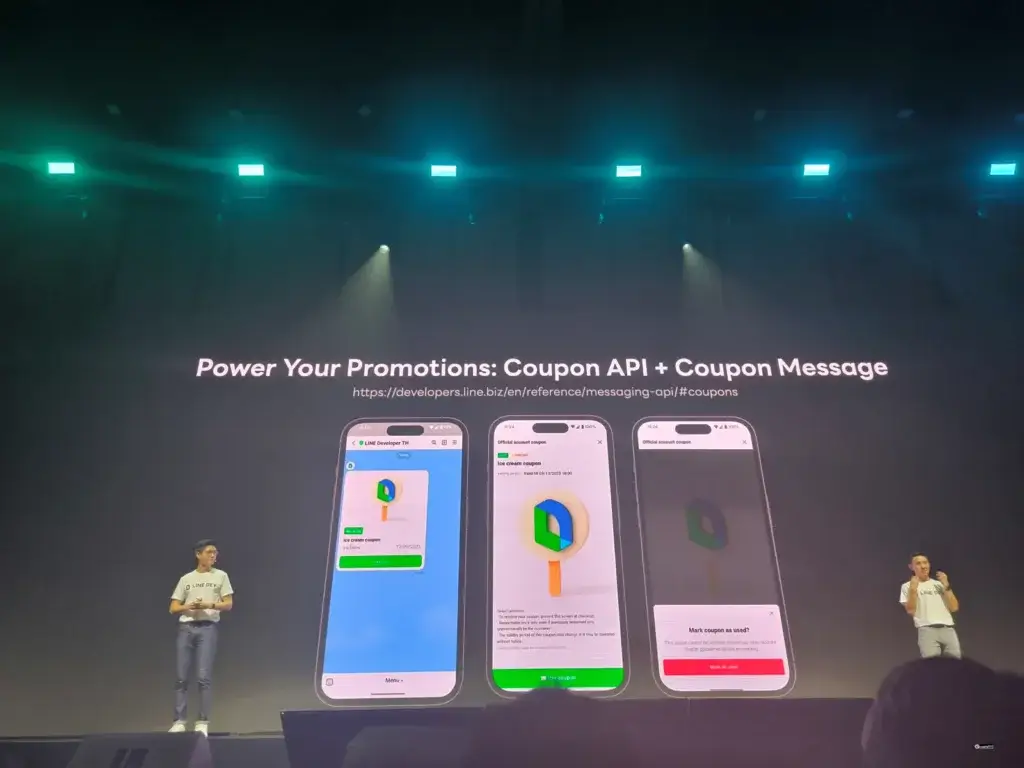

- API สำหรับสร้าง Coupon จากการสั่งซื้อ หรือ จาก Line Beacon

📌 LIFF

- Seamless LIFF Switching (V 15.12.0) - เปิด LIFF ได้หลายตัวสูงสุด 5 หน้า และข้อมูลไม่หายด้วย (ผมชอบมากในมุม User ตอนใช้กดๆ มันหายไป)

- ปีที่แล้วมี Liff CLI ให้ลอง ตอนนี้เพิ่มความสามารถ โดยใช้ ngrok ver ล่าสุด v3 จะได้ไม่เจอฟ้อง Deprecated

📌 Line Mini App

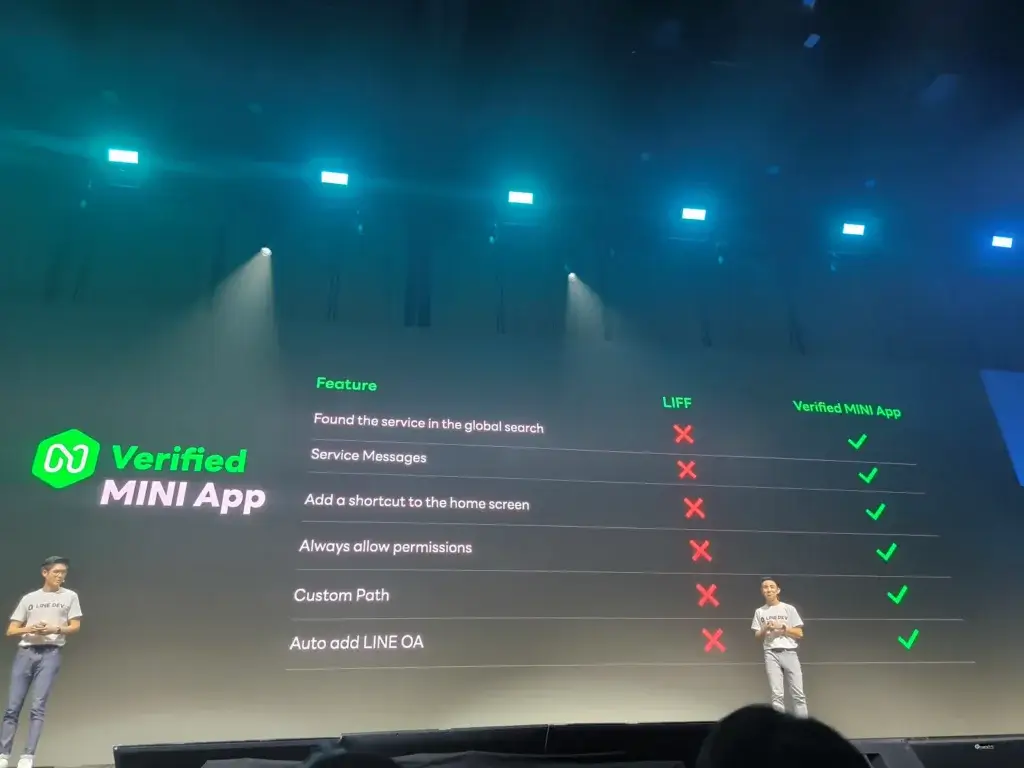

- ทำ App โดยใช้ simple html js css โดย deploy แล้ว ได้ทั้ง android / ios ถ้าเป็น App ที่ Verify แล้วจะได้ปลด lock feature ตามนี้เลย

- ตัวอย่าง App ในไทย ที่ใช้ Line Mini App มีหลายตัวเลย อย่าง Finnomina / Q-Change / TQM / MedCare / Dusit Central Park

- นอกจากนี้มีแนะนำ Use Case ของทาง Line Japan ว่าเอา Mini App ไปทำอะไรบ้าง

- suShi Tech จาก Tokyo มี mini app ช่วยหาของฝาก ครบจบใน app (ai photogrammetry สร้าง map + Line Pay)

- Hikky Metaverse app สำหรับ virtual event ด้วย webgl

- นอกจากนี้ ยังมีหลาย use case เช่น การจองคิว / QR สั่งอาหาร / QR ตอบคำถาม และให้ข้อมูล

📌 Line Developer Partner Program - พอ tech × biz มาเชื่อมโยงกัน และทำ app ออก โดยแบ่ง authorize / professional / expert) น่าจะ link นี้นะ ให้ Claude หาให้ LINE Developer Partner Program

📌 ปลายปี 29-30 NOV 2025มี Line Hack 2025 ชิงเงินรางวัล 50k นะ

Resource: https://speakerdeck.com/linedevth/line-api-essential-updates-for-2025 (Slide)

TicketO: Reinventing the event experience with AI on MINI App

Speaker Thepnatee Phojan / Supakarn Laorattanakul

Event ในไทยเติบโตอย่างมากทั้งในกลุ่ม ทั้ง Skill & Community (Tech Meetup / Workshop), Mice (Exhibition / Townhall) และ Entertainment (Concern / Fan Meet) แต่ปัญหาของงานพวกมีเหมือนกันว่าทำยังไงให้สะดวก

- Organize จัดงาน ลงทะเบียน รับ Feedback

- Attendee มาวางแผน ร่วมสนุกในงาน แบบ Quiz

ทาง TicketO ออกแบบระบบ โดยใช้ Line Platform + AI มี 3 ส่วนที่สำคัญ ดังนี้

- Pre-event

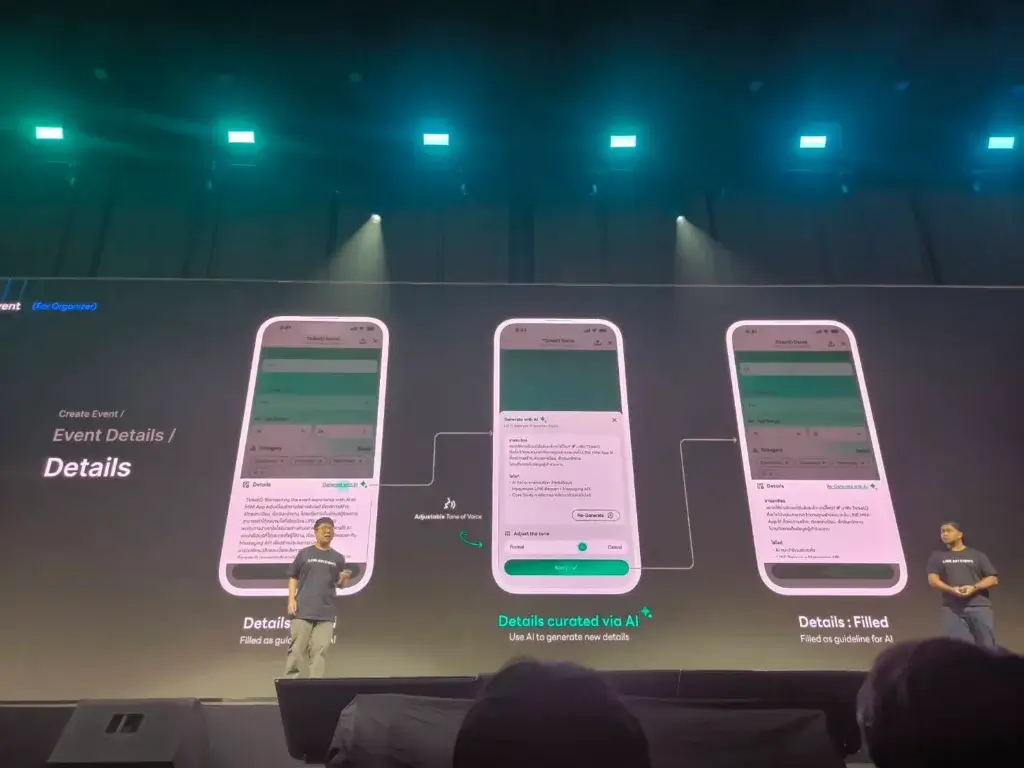

- Event Builder - สร้างข้อมูล Event ชื่อ วันเวลา สถานที่ ประเภทบัตร Quota ต่างๆ รวมถึงมีการนำ AI มาใช้ Generate Desc จากข้อมูล category / persona / mood

- Registration ลงทะเบียนผ่าน LINE MINI App QR Code + Service Message ยืนยันการลงทะเบียน - On-event

- Check-in สแกน QR ที่หน้างาน หรือ ใช้ตัว Line Beacon ตรวจก็ได้

- กิจกรรมเสริมอื่น วางแผนการเดินทาง / Quiz หรือ Mission ต่างๆ เพื่อสะสม Point เพิ่ม Engagement - Post-event

- Feedback จากแบบสอบถามของผู้เข้าร่วมงาน

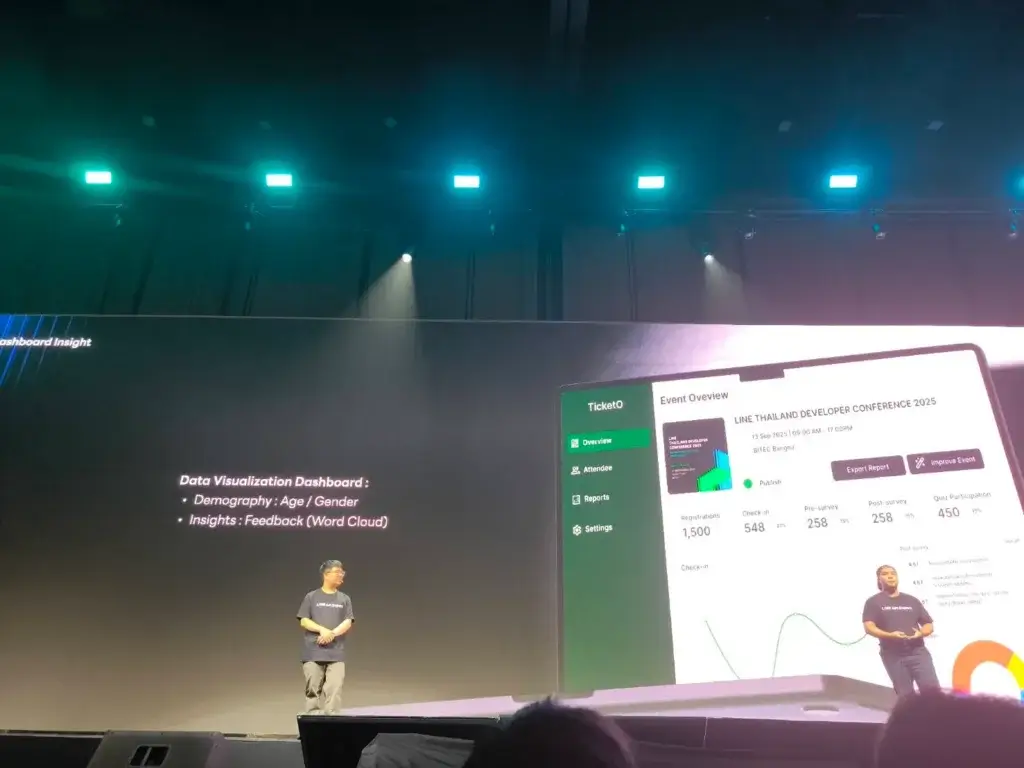

- Dashboard แสดง Insight ภายในงานทั้งหมด และเอา AI มาช่วย Summarize เพื่อเกิด Feedback loop

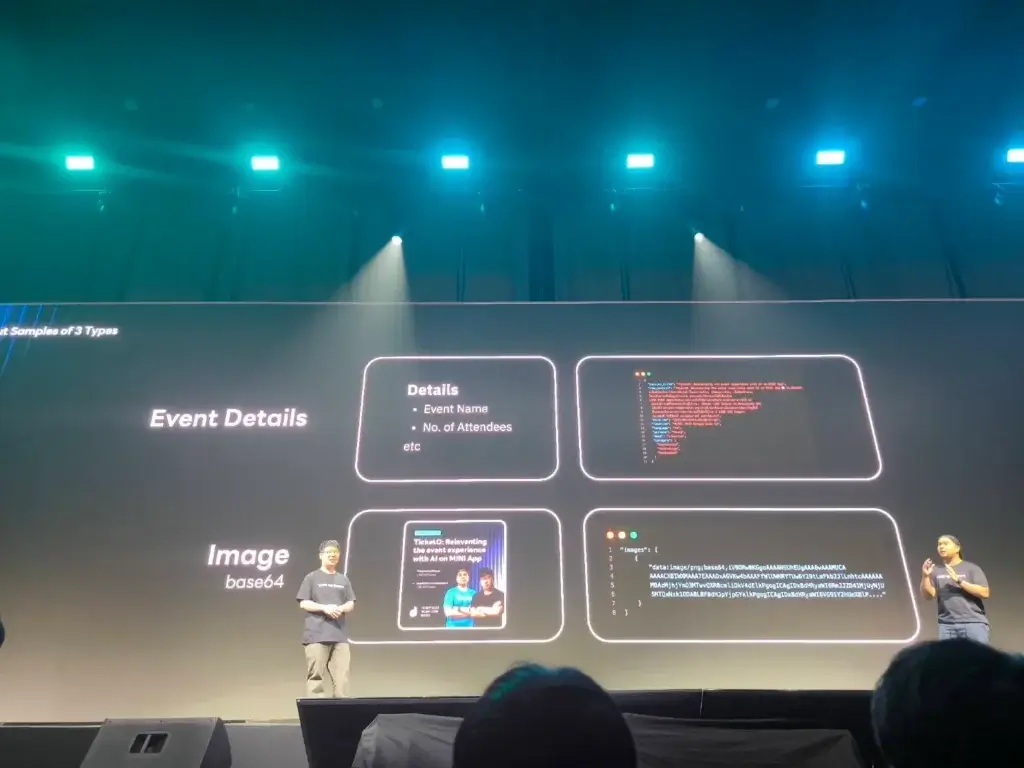

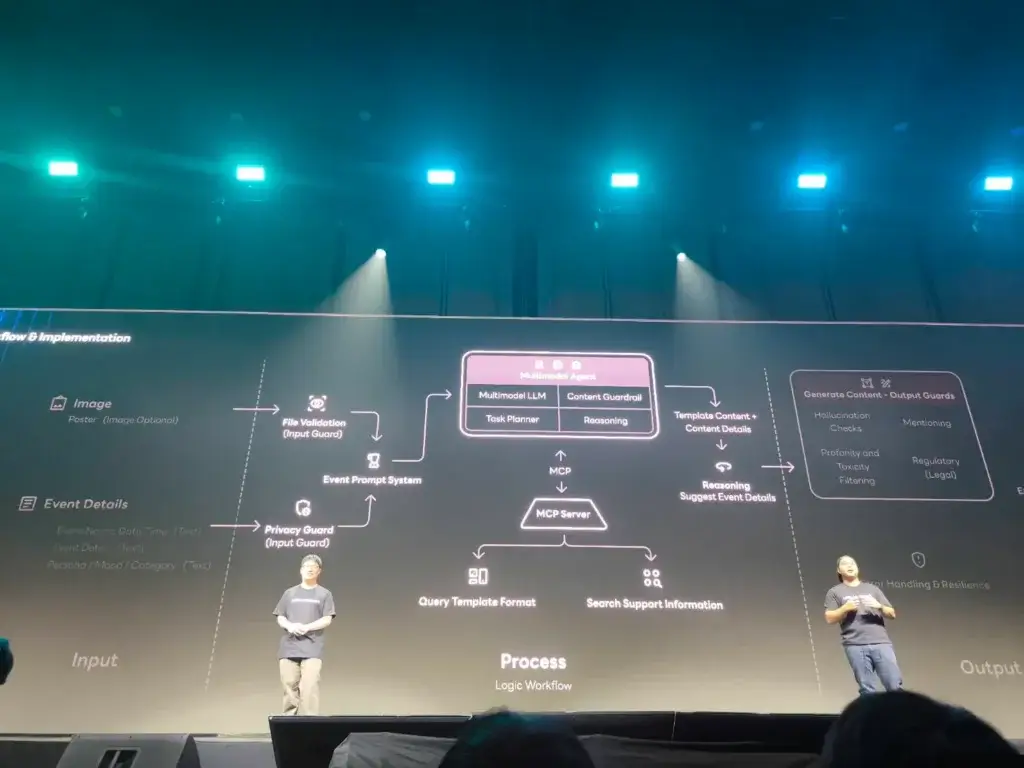

Tech เบื้องหลัง

📌ส่วน AI จะใช้แบบ Multi Modal Model มีการกรองข้อมูลตั้งแต่

- Input ตรวจก่อนว่ามีอะไรที่ชัด Privacy หรือ คำหยาบไหม

- ให้ Multi Modal Model ประมวลผล > เลือก MCP Server ที่เหมาะกับงานนั้น ส่ง Prompt Template ที่เหมาะสม หรือให้ Tools ทำงานที่เชื่ยวชาญต่อ

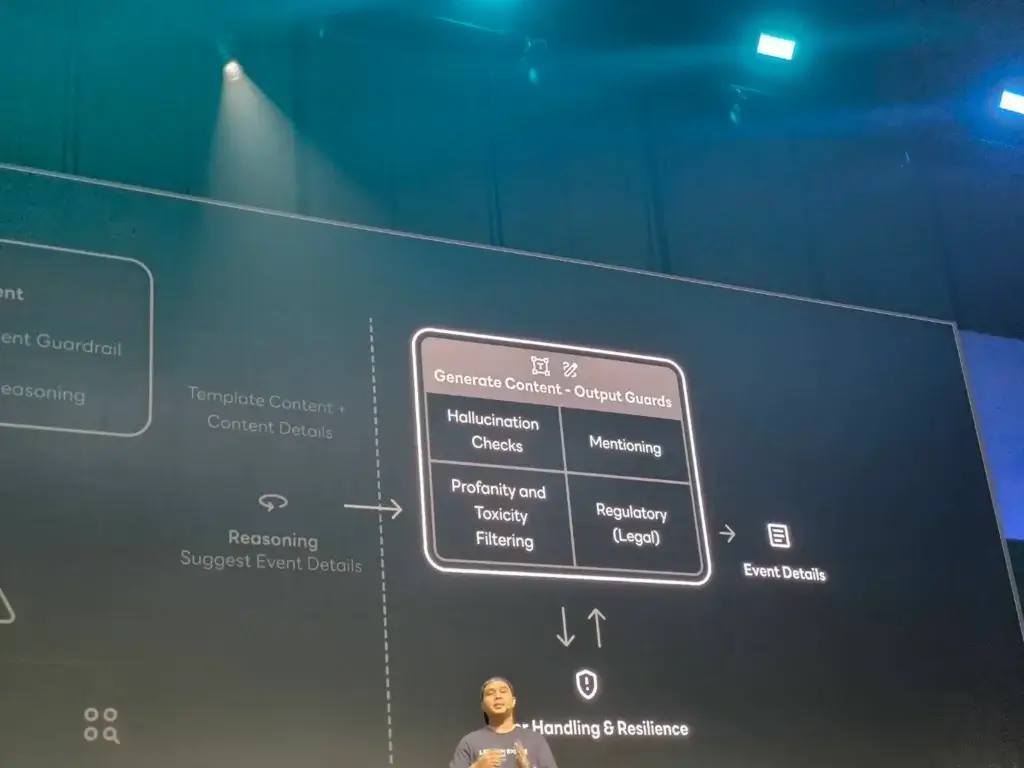

- และสุดท้ายมีการทำ Guard Rail มาตรวจกัน คำต้องห้าม / หลอน privacy / regulatory พวกฏหมายต่างๆไ เป็นต้น

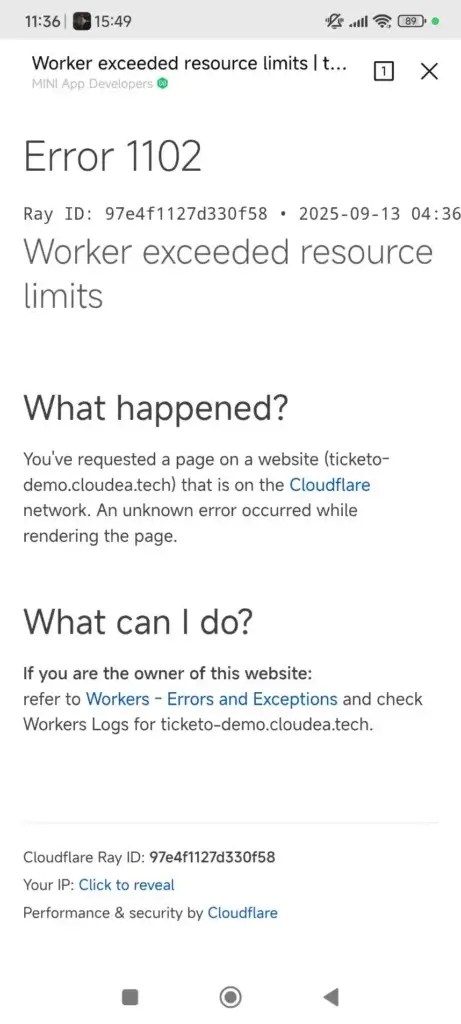

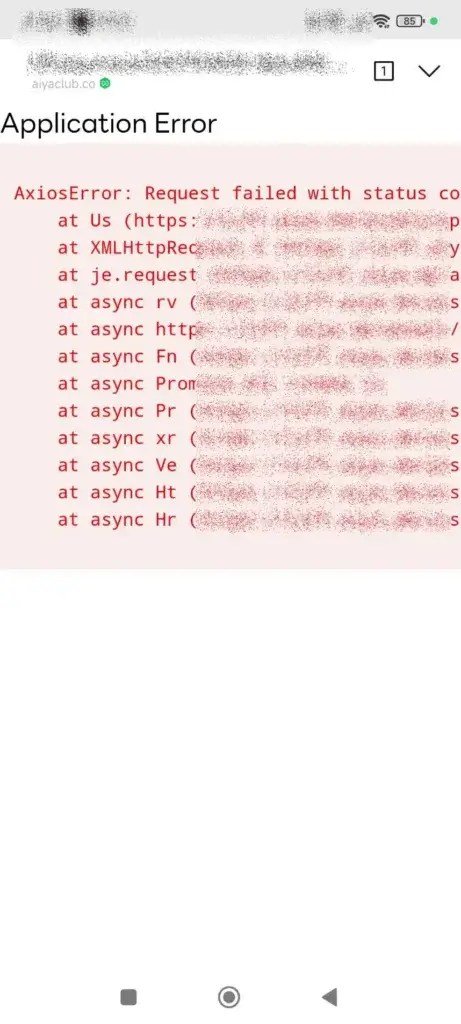

📌LINE MINI App - ง่าย เพราะไม่ต้องมาจัดการหลาย platform และถ้าได้รับการ Verified MINI App ยิ่งสะดวกขึ้นไปอีก ทั้งการทำ Home Shortcut / Custom URL Path / Always Permission (กล้อง/ไมค์) / Auto-Add OA เป็นต้น รวมถึงการใช้ Service Message ได้ และมี Demo ด้่วย แต่มันแตก แต่เราก็ไม่ได้เป็นผู้ที่ถูกเลือก แงง

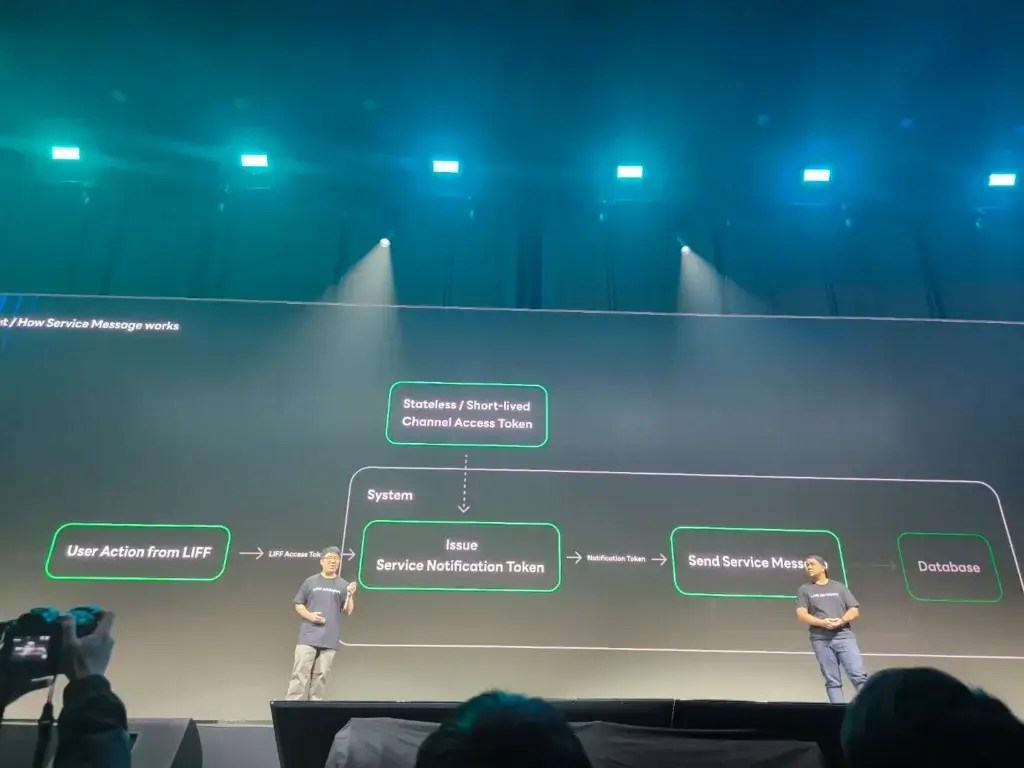

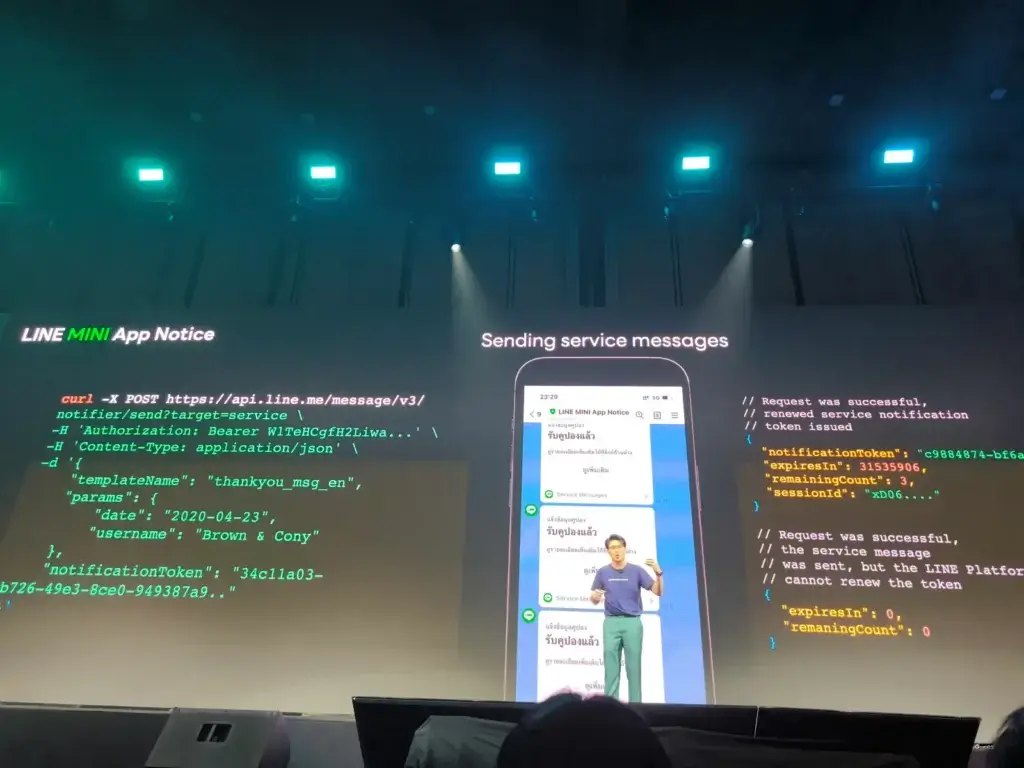

📌Service Message ยืนยันการลงทะเบียน การใช้งานต้องเอา Token ของ LIFF / Line Mini App มาขอ โดย Service Notification Token อายุ 1 ปี 5 message เอาจุดนี้มาปรับกับ Business ได้

📌Key: AI เป็นผู้ช่วย ไม่ใช่คนต้องมาคุมตอนท้าย / Line Mini App ช่วยลดเวลาได้ / Optimization loop

Resource: https://speakerdeck.com/linedevth/ticketo-reinventing-the-event-experience-with-ai-on-mini-app (Slide)

Next-Gen Retail: LINE MINI App with AI Location Intelligence

Speaker Atchariya Darote

ตอนนี้มันมีการตลาดอยู่ 2 แบบ ทั้งส่วน Offline (awareness แต่วัด Conversion-เข้ามาเป็นลูกค้า ยาก) กับ Online (ถ้า Data มากพอ เราเข้าใจลูกค้ามากขึ้น) แต่ยังมีจุดเสริมได้ อย่างบางธุรกิจที่มันต้องมาจ่าย Offline เช่น ร้านอาหาร หรือ กลุ่มบริการจะดีกว่าไหม ถ้าเราทำให้ Offline + Online แบบ Seamless จึงเป็นที่มาของ O2O

Solution เอาข้อมูลของทั้ง 2 ส่วน Offline + Online ทำให้เรารู้จักลูกค้ามากขึ้น และยิงโปรโมชันได้ตรงใจ และเกิด Action ต่างๆต่อ เช่น การเก็บคูปอง มาใช้บริการหน้าร้าน เอา Feedback ไปปรับปรุงต่อ

Tech เบื้องหลังที่เชื่อม Offline + Online ใช้ beacon (line beacon) + Bluetooth และ Platform Line

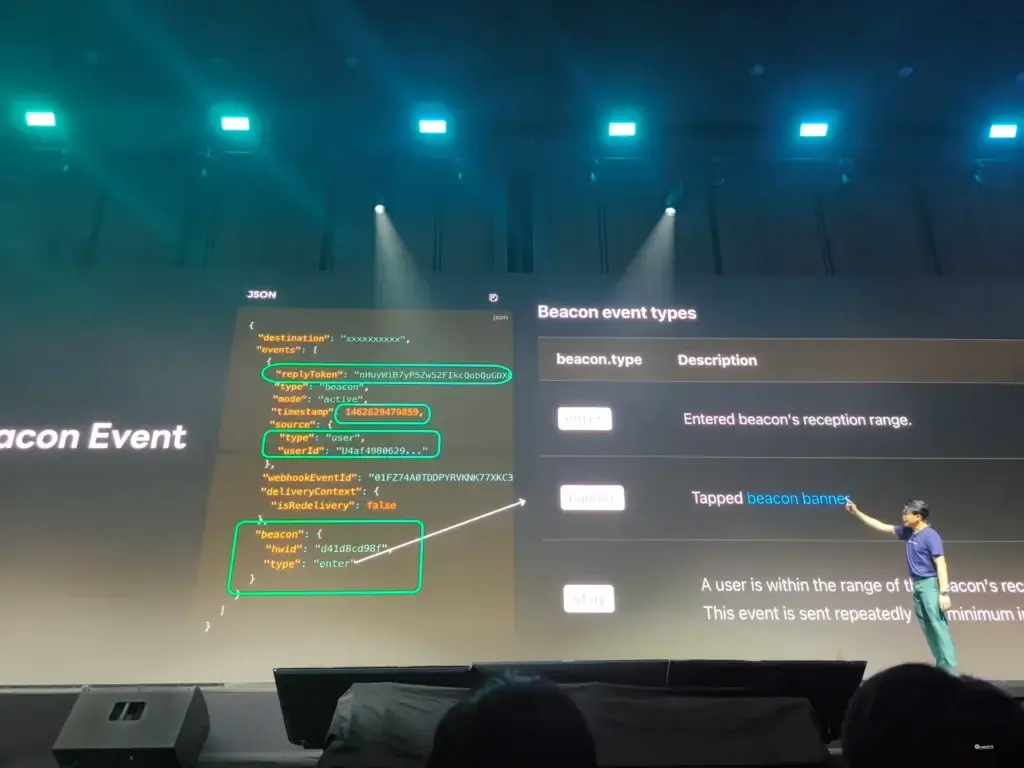

- LINE Beacon (AiBeacon) ระยะ 3-100 เมตร เครื่องเล็กเท่ามือเอง โดยมี event ที่เราสามารถเอาไปปรับใช้ 3 ตัว ได่แก่

- Enter: เข้าสู่ Beacon ได้ รู้แล้วว่า UserId เข้ามาในระบบ

- Banner: เกิดเมื่อคลิก Beacon Banner ตาม Ads ที่ส่งเข้าไป

- Stay: ดู indoor tracking และทำ web hook ตาม และปรับการส่งโปรตามพื้นที่นั้นๆ ที่ User อยู่

- LINE MINI App

- ทำ App รอบเดียวได้ หลาย mobile platform รวมถึงมีระบบข้างหลัง เช่น การจัดการโปรให้ / แจก coupon รวมถึงเราปรับ Flow ได้มากขึ้น

- ถ้าตัว App ผ่านการ Verify สามารถทำหลายๆอย่างได่ เช่น การทำ Home Short Cut หรือ ลดขั้นตอนวุ่นวายที่ต้องขอ Permission ทุกจุด / Auto Add Friend

- Line Service Message

- โดยเอา Token จาก LIFF / MiniApp มาขอ Service Notification Token โดย 1 ปี ส่งได้ 5ครั้ง ฟรี

- ระบบต้องเก็บ Token ส่วนนี้ และ ทาง Biz ปรับ Campain ให้เหมาะสม - TimescaleDB เอามาเก็บ Time Series Data

ส่วน Business Campaign Design อย่างเช่น ถ้าเข้าใกล้ยิง Ads และผมลองแล้ว 555 (เข้าใจว่าโดน Rate Limit ของ Cloud จู่ๆคนรุมเข้าไปเยอะ

Sample Flow

- Demo ในงาน

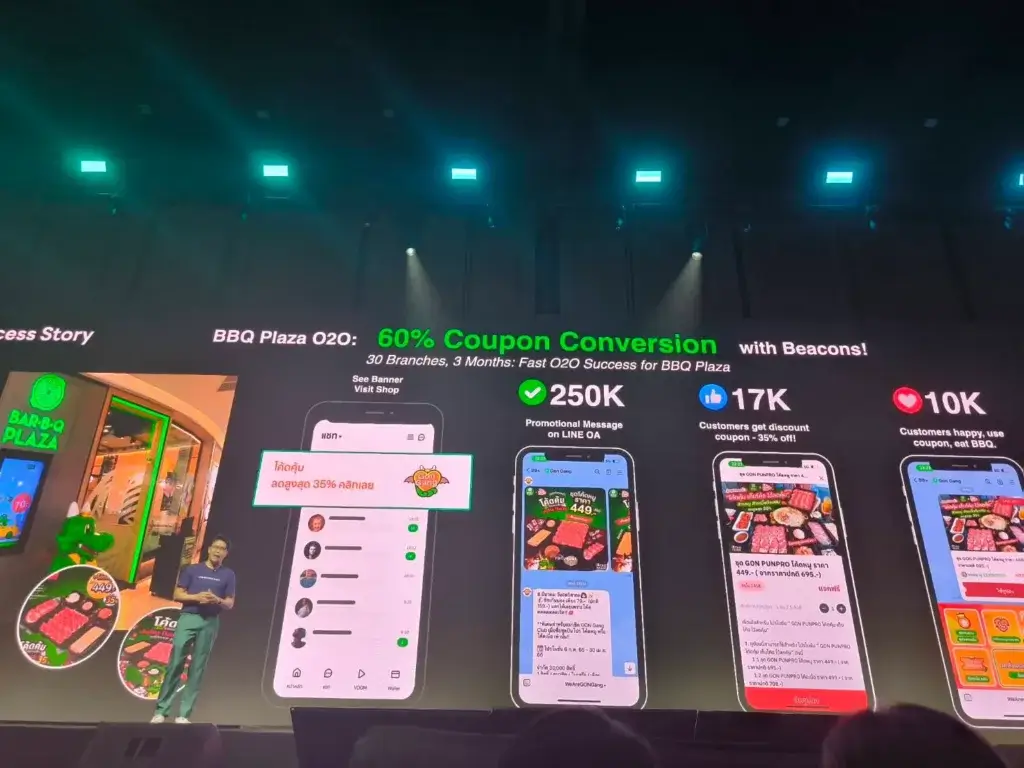

- BBQ Plaza

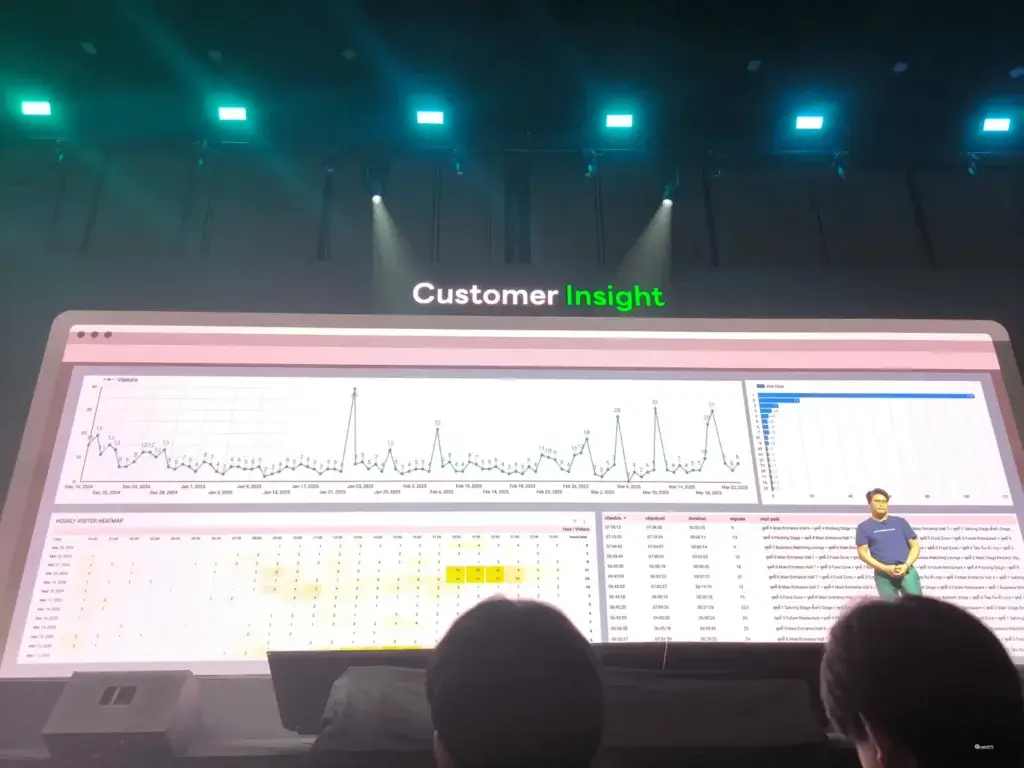

สุดท้ายจากข้อมูลที่ได้ทั้งหมดต้องมาวัดผล Funnel/ Impression / indoor tracking / CRM ภาพข้างล่างเอาข้อมูลเก็บใน TimescaleDB มาวิเคราะห์ เอา AI มาต่อยอดได้ด้วย

Resource: https://speakerdeck.com/linedevth/next-gen-retail-line-mini-app-with-ai-location-intelligence (Slide)

LINE Group Bot by Zwiz.AI

Speaker Chanakarn Chinchatchawal

N'Zee เป็น AI Chatbot แรกๆ ที่ทำตอนปี 2019 เพื่อเอามาช่วยจดวันลาของทีม มี Blog ด้วยนะ และใช้มาเรื่อยๆจนโต Feature หลายอย่าง

- Leave Management

- ตั้งแต่ลา / ยกเลิกการลา

- จนถึงสรุปวันลาที่เหลือ / ใครลาวันนี้มาบ้าง - Internal FAQ ตอบคำถามจากใน KM เช่น

- ถามข้อมูลในกลุ่ม / ถามเบอร์ /

- หรือ ส่งมุก ขำบ้าง

- สาระมีนะ Check Response Time - 2021 เพิ่ม Support Sale / CS Team เช่น

- ให้กำลังใจ ตามเป้า

- หรือ บันทึกยอดขายคร่าวๆ ก่อนออกเอกสารเต็ม

- หรือ แก้เคส ปัญหาเจอซ้ำ และ automate ได้ แบบพวกการเปลี่ยน package หรือ user pass - 2023 เพิ่ม book meeting room ปรับจาก Line Flex มาเป็น Line Liff จอง ยกเลิก และดูคิวชน

- 2025 เอา Generative AI / LLM เข้ามาใช้งาน

- ลองคิดโปร หรือดูดวง

- และคุม scope การใช้งาน อย์ูในไลน์กลุ่มขององค์กร

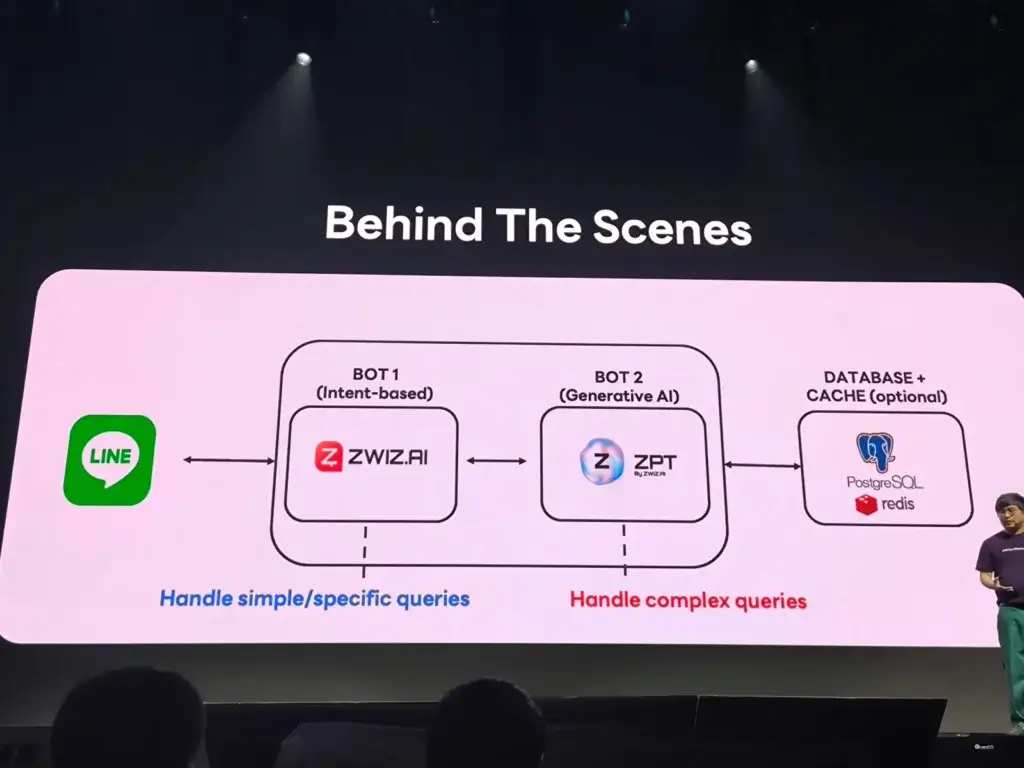

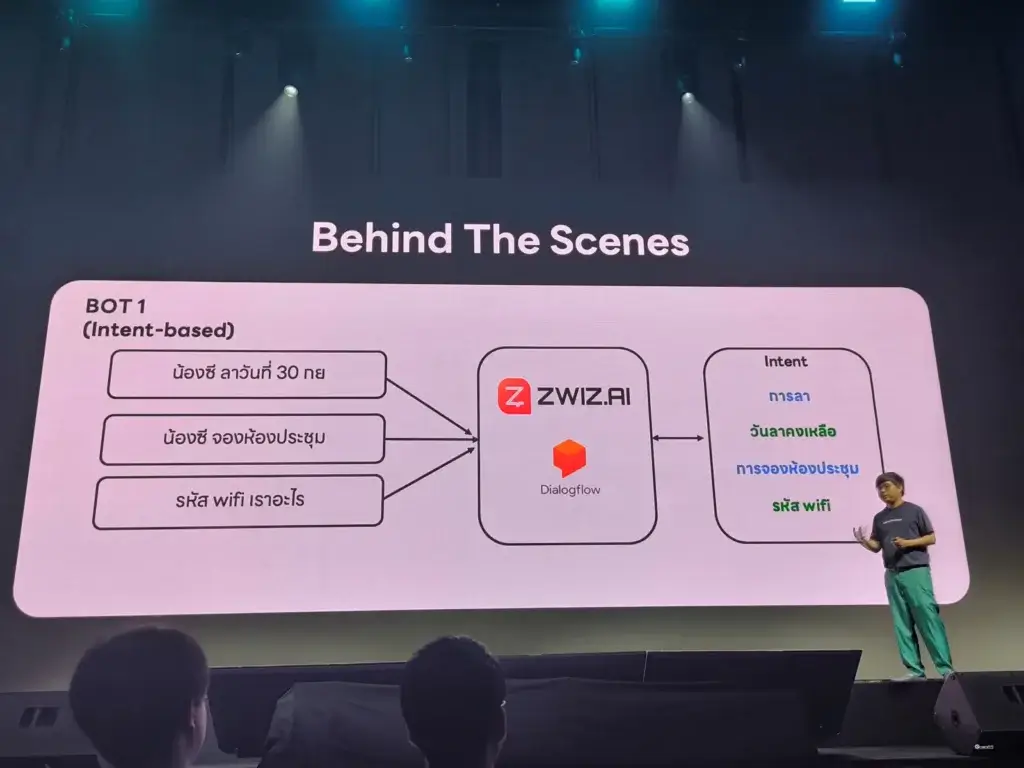

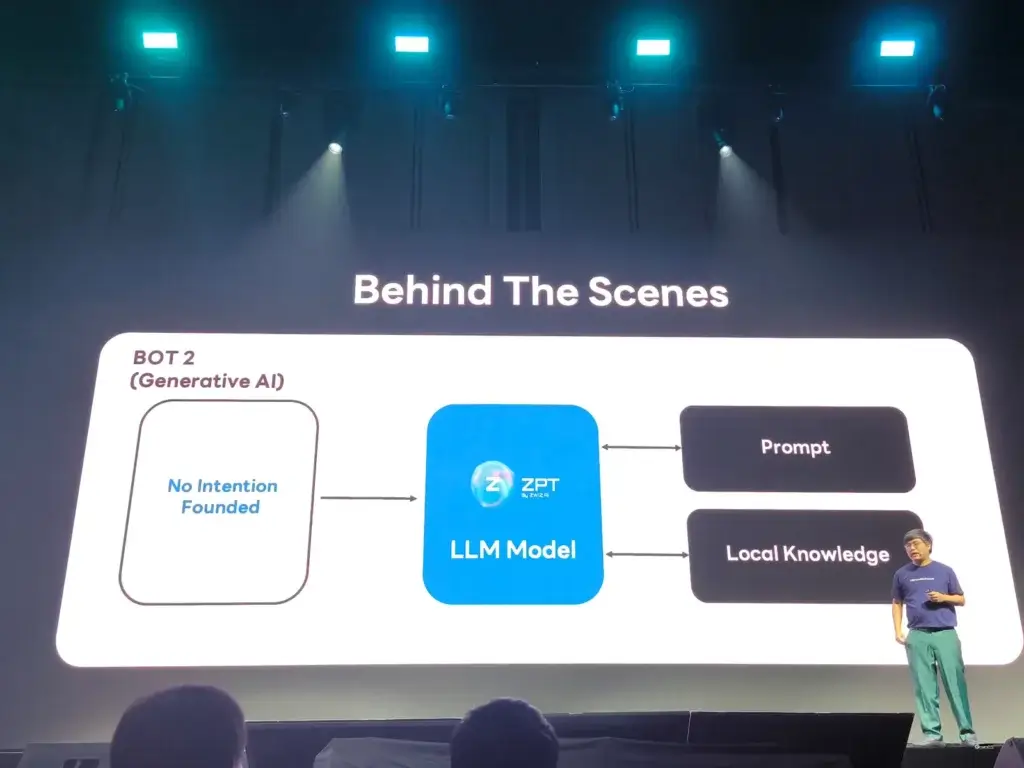

Tech Behind N'Zee + Architecture

- Intent Base AI คล้ายกับ Dialog Flow เป็ย AI ทำงานตาม Intent ที่ pre-define ไว้ และทำหน้าที่เป็น Guard Rail ของ LLM

- LLM Model ถ้าส่วนแรก ตอบไม่ได้ให้ bot อันนี้ทำงาน กับข้อมูลภายในองค์กร

- ส่วนที่ AI ทำไม่ได้มี ระบบหลังบ้าน เพื่อให้ AI เรียกใช้งานอย่างการลา จองห้องประชุม และ Database เก็บข้อมูล

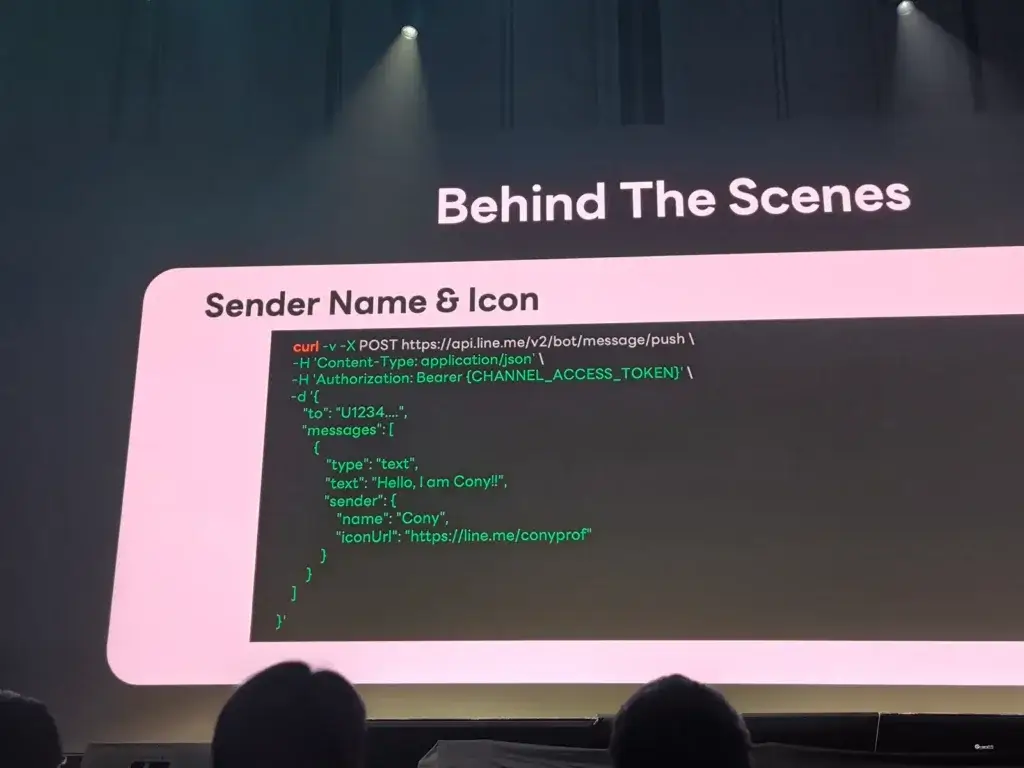

- นอกจากนี้ การตอบแต่ละ Agent กำหนด Sender Name + icon เพื่อกำหนด persona และทำให้เรารู้ได้ว่า Agent ตัวไหนทำงานนั้นๆ

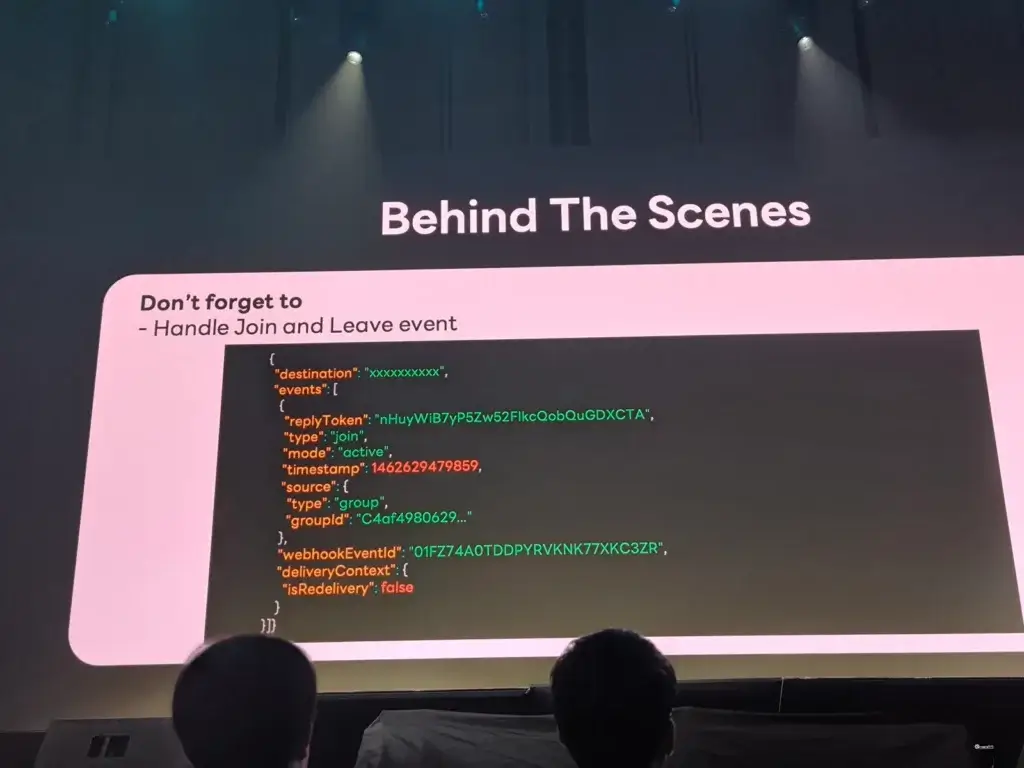

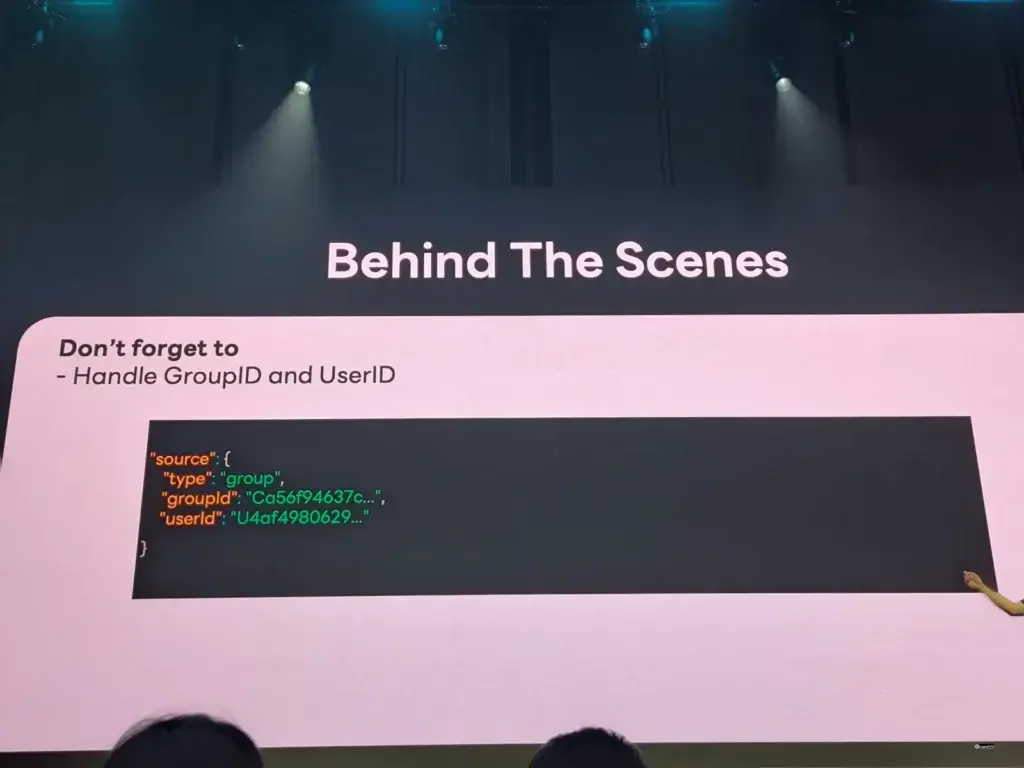

- และการคุมสิทธิการเข้าถึงก็สำคัญ ให้กำหนด groupid / userid เพื่อไม่ให้ bot ไปทำงานอื่น ตอน join มี web hook บอก เรา check ได้นะ ถ้าเราไม่คุม อาจจะจอปัญหา Cost ของ LLM บานได้ เพราะมีคนแอบใช้

ค่าใช้จ่ายของ Line API ตอนนี้

- Reply 0 บาท

- Push API no of member × 0.06 THB (ราคาตามโปร)

Resource: https://speakerdeck.com/linedevth/line-group-bot-by-zwiz-dot-ai (Slide)

ArgoCD: Deploy with confidence, conquer YAML mysteries

Speaker Neutron Soutmun

ปัญหาที่เรามักพบเจอประจำ

- Coding อันนี้เขียนมา เพื่อทำอะไร ใครรู้บ้าง หรือมี God Know

- Deploy แล้ว มันจะแตกไหม วัดดวงเอา

- YAML Hell (YAML มาบอกผลลัพธ์ มันช่วยจริง หรือทำให้เราเมา และสับสนขึ้น)

ปัญหาแรก Coding อันนี้เขียนมา ใครรู้บ้าง หรือมี God Know

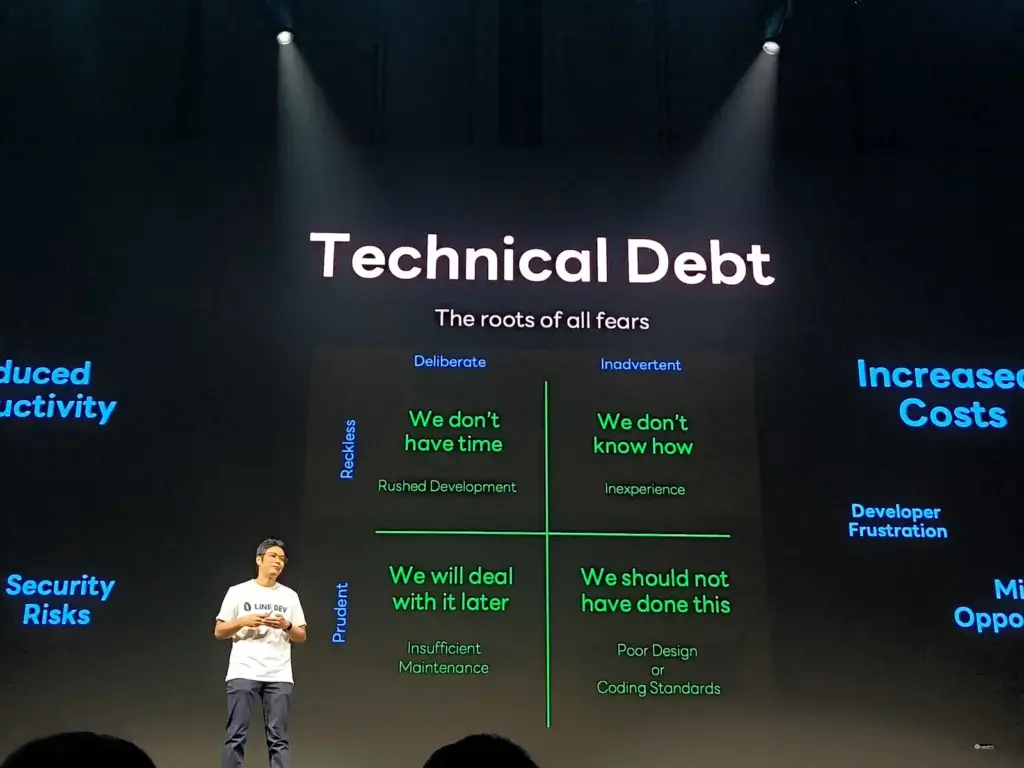

📌ที่มันเกิดปัญหานี้ เพราะสิ่งที่เรียกว่า Technical Debt หรือหนี้ทางเทคนิค การก่อนหนี้ มีหลายแบบ

- หนี้ของความรีบ (We don't have time)

- หนี้เอาไว้ที่หลัง (Deal with it later) ทำชั่วคราว แต่ใช้ชั่วโคตร

- หนี้เกิดจากการขาดประสบการณ์

- หนี้บางอ้อ (We don't know) ใช้ pattern ผิด หรือ coding standard เช่น การจัดการ exception

📌 การจะแก้ไขเรื่องนี้ GitOps ในส่วนของการ Deployment CD โดยมี Principle ดังนี้

- Declarative บอกภาพสุดท้ายว่าเป็นอย่างไร

- Versioned and Immutable

- ทำแล้ว version เหมือนเดิม ไม่มีใครไปแก้ได้ ใน line ใช้หลายแบบ

- ส่วน SRE ใช้ตัว headVer head.YearWeek.BuildNo (อารมณ์เหมือน อย บอกเวลาได้ ว่าสร้างตอนไหน Version

- Control ใช้ Git ปัญหาที่ว่า Code เราพระเจ้ารู้ ลดลง เพราะมี Process การทำ Peer Review - Pull Automatically

- Continuously Reconcile

ปัญหาDeploy แล้ว มันจะแตกไหม วัดดวงเอา

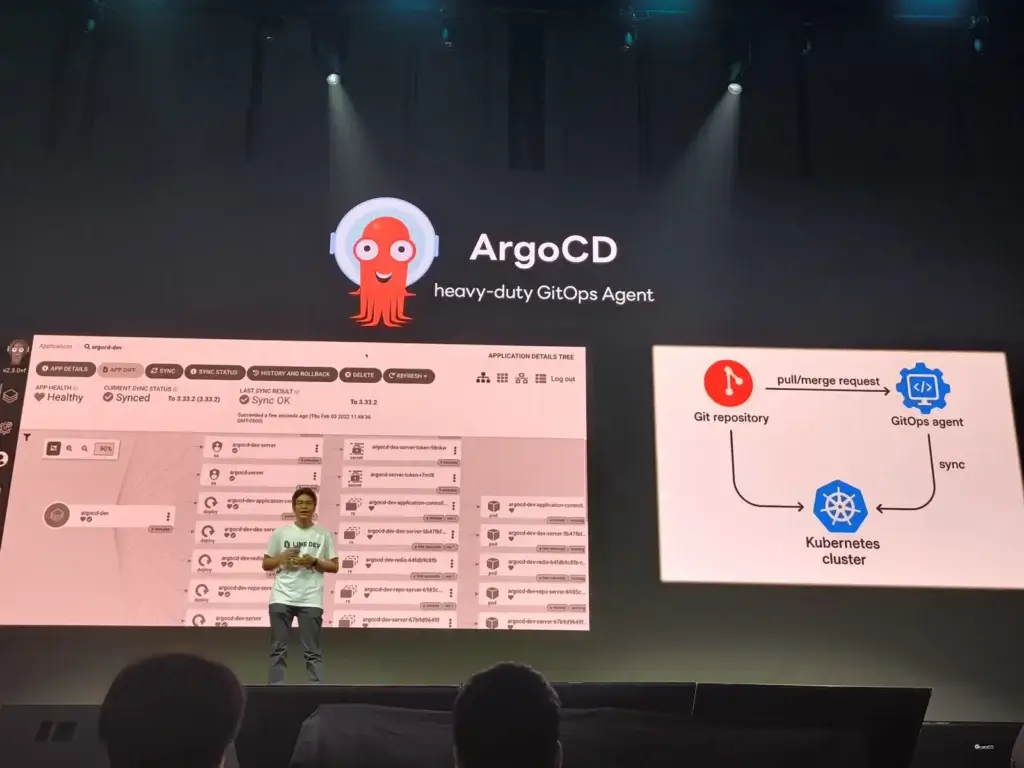

📌 GitOps ในส่วนของการ Deployment CD มี Tools ArgoCD- Pull Automatically + Continuously Reconcile

📌 นอกจากนี้แล้วยังมีส่วนของ Coding นะ อันนี้มีกระบวนการ CI เข้ามาช่วยให้มั่นใจในการ Build + Test เพื่อเรารู้ผลได้ไว (Fail Fast / Fail Early)

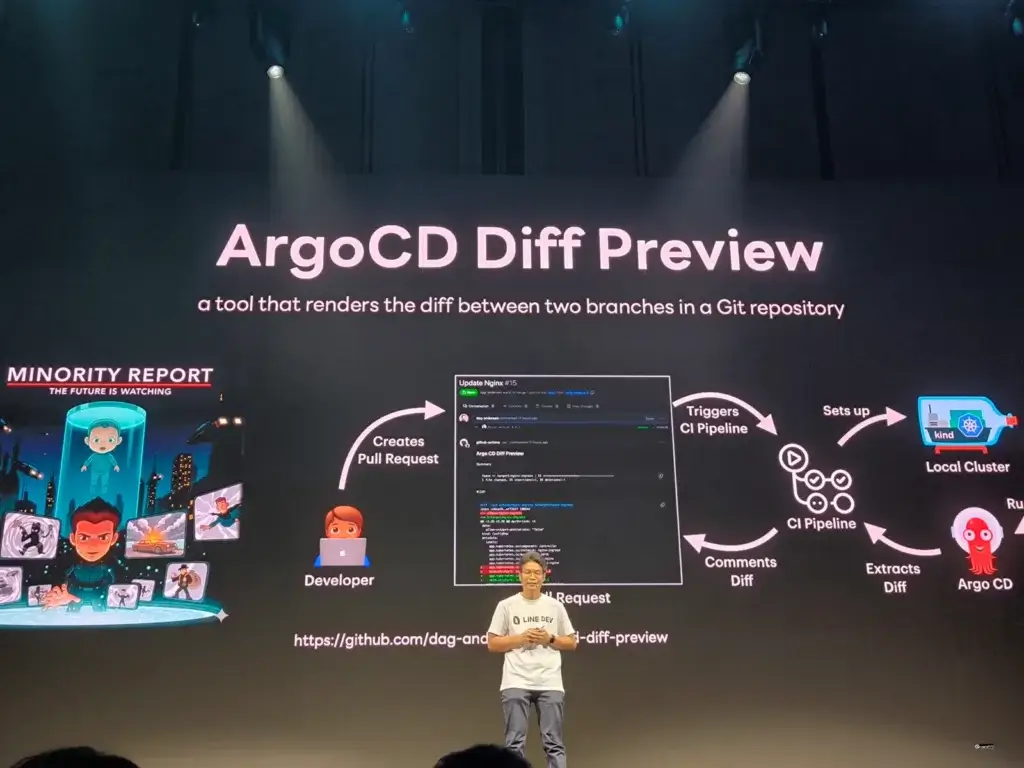

- เอาตัว Tools ArgoCD Diff Preview เข้ามา Link ใน workflow GitHub Action บอกความแตกต่าง เมื่อก่อน Line มีทำ Tools พวกนี้ใช้เองนะ สุดท้ายเอา Feature เข้า รวมกับ ArgoCD Diff Preview แบ่งปันกลับให้ชุมชน

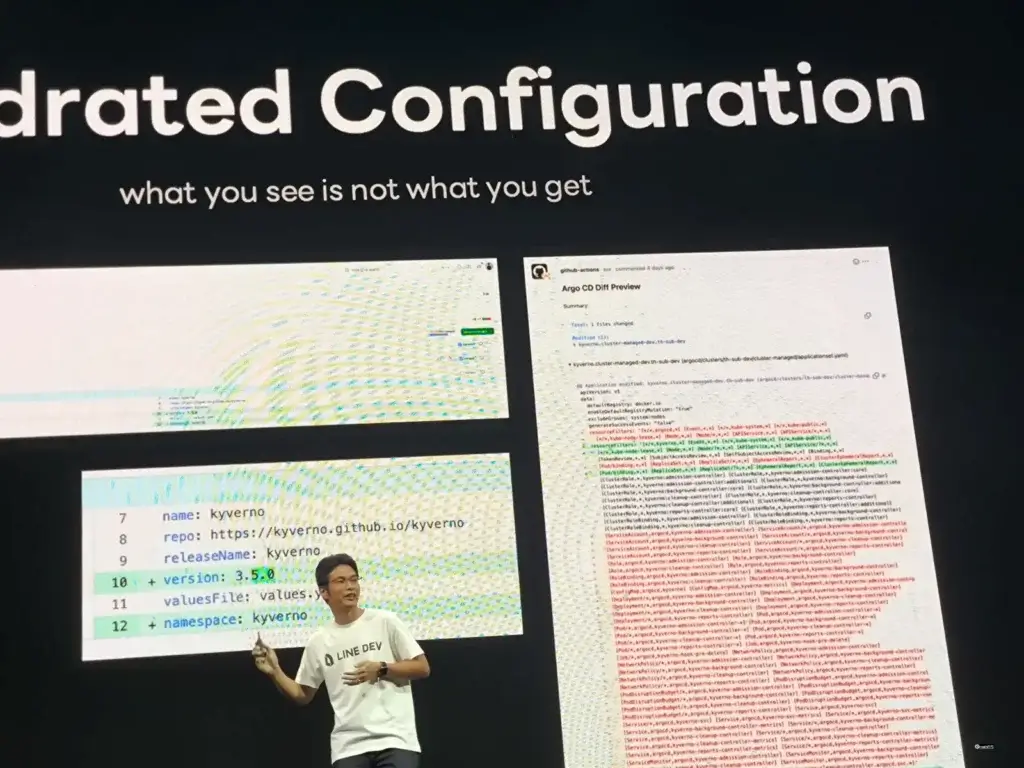

- ถึงแม่ว่า แค่เปลี่ยนเลข Version ถ้าข้างในมันปรับเยอะ Dehydrated Configuration เราต้องเอ๊ะ แล้วมาทดสอบให้มั่นใจ

📌 ถ้า CI พบกลิ่นตุๆ เราต้องมาปรับให้เข้า Flow GitOps แตก Pull Request ใหม่ และทำ Peer Review ทดสอบให้มันใจ ก่อนจะ Merge เข้า Branch หลักให้ ARGO CD Sync ใน Env ต่างๆ

ปัญหาสุดท้าย YAML Hell (YAML มาบอกผลลัพธ์ มันช่วยจริง หรือทำให้เราเมา และสับสนขึ้น)

- YAML Language Server เพื่อมาทำ Syntax Highlight ตรวจ Rule ใน IDE อย่าง NeoVim / VS Code เช่น การเคาะเยื้อง ตรวจ Schema

- Coding Standard กำหนด Format กลางในการทำงานร่วมกัน

- Linter ช่วยตรวจสอลข้อกำหนดของ Tools นั้น อย่าง K8S จะมีตัว kubeconform

- นอกจากนี้ ai assist coding guide มันแนะนำได้ แต่เราต้องตรวจ

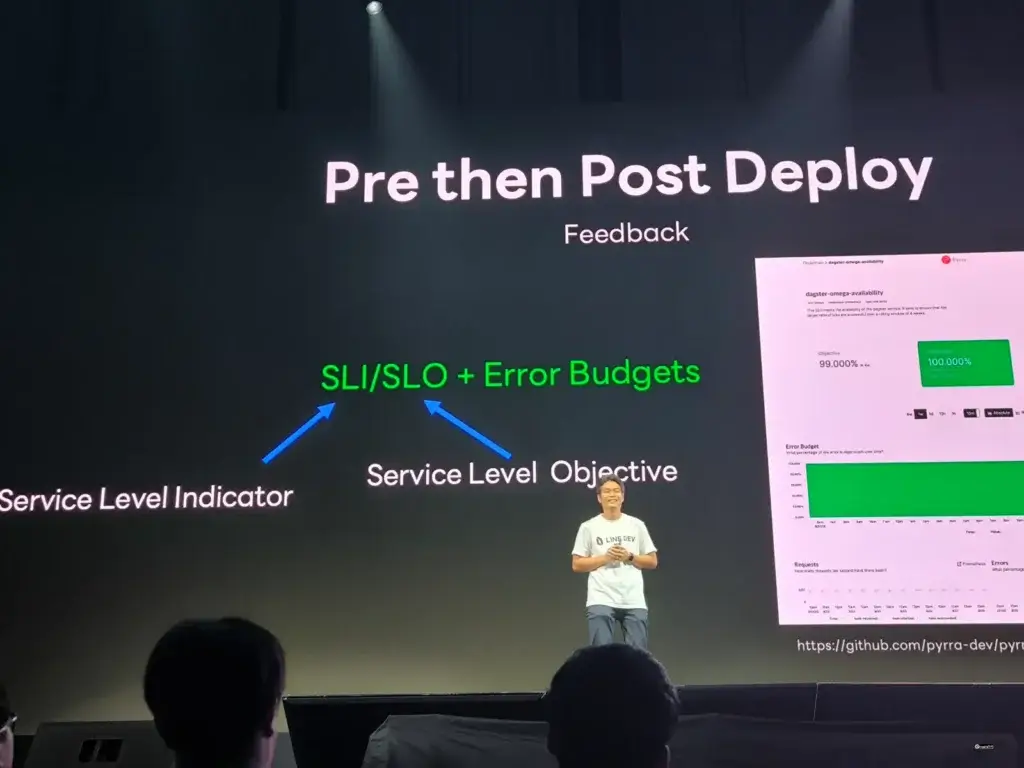

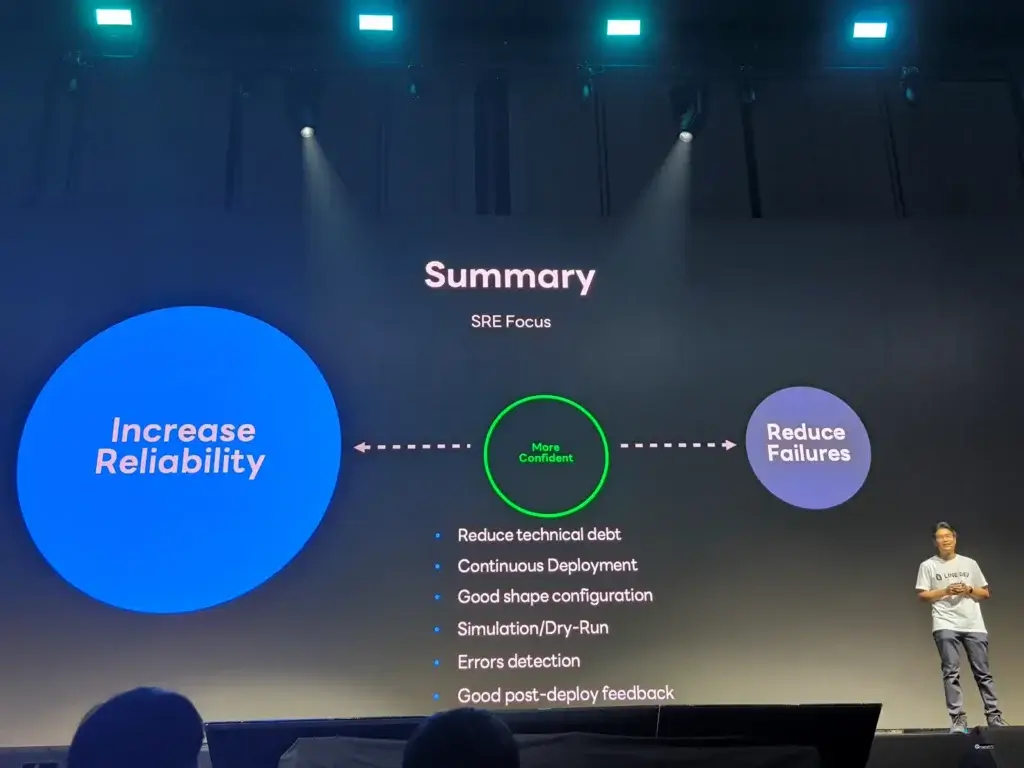

🎯 เสริมความมั่นใจหลัก Deploy SLI/SLO/Error Budget 🎯

- SLI (ตัวชี้วัดเชิงบริการ) เช่น Latency / Availability / Request Error

- SLO (เป้าหมายบริการ)

- Error Budget กันงบประมาณสำหรับข้อผิดพลาด อย่าง เช่น เรากำหนด SLI/SLO ไว้ที่ 99% อีก 1% เราต้องมาตีมาเป็นตัวเงิน ชะลอการ Release และกลับมาแก้ไข

ปิดท้ายเริ่มตอนนี้ทำได้เลย โดยนำ

- GitOps(CD) มาใช้งาน เพื่อลดการเกิด Technical Debt ใช้ Git คุม Version และการทำ Peer Review ของตรวจสอบให้มันใจว่า Config Deployment นั้นถูกต้อง

- นอกจากนี้ตั้งส่วนของ CI เพื่อเกิดการตรวจสอบ Linter / Schema / Standard

- รวมถึงการทำ Dry Run เพื่อให้เจอ Error ได้ก่อน และสุดท้ายหลัง Deploy ต้องมี Dashboard เพื่อติดตาม SLI / SLO และ Error Budget เพื่อเอา feedback มาปรับปรุงให้ดีขึ้น

Speaker เป็น 1 ใน 4 Debian Developer ของไทยด้วยนะ

Resource: https://speakerdeck.com/linedevth/argocd-deploy-with-confidence-conquer-yaml-mysteries (Slide)

Spec > Spell: Write It Clearly, and Let AI Do the Magic

Speaker Pathai Suwannawiwat

AI มีการพัฒนาแบบก้าวกระโดดตั้งแต่ปี 2022 ที่ ChatGPT เปิดตัว หลังมีของมาให้เล่นเรียบๆ 2023 (Agentic AI) / 2024 (MCP)

สำหรับการเอา AI มาช่วย Code มีตั้งแต่ช่วง 2022-2023 แล้วนะ แต่เราคิดนนี้เริ่มมาบูมๆช่วงหลังๆนี้เรียกว่า Vibe Coding ซึ่งคุณ Simon Willison

Building software with LLMs without "carefully examining the code it writes"

ซึ่งปัญหาที่ตามมาเกิดปัญหา Business / Security หรือ พวก Technical Debt แต่จริงๆแล้ววิธีการแก้ปัญหามัน คือ วิธีเดิมๆ ที่เราทำกันมานานแล้ว การเอา Engineering Mindset (Planning / Design / Testing / Refactoring) เข้ามาช่วย

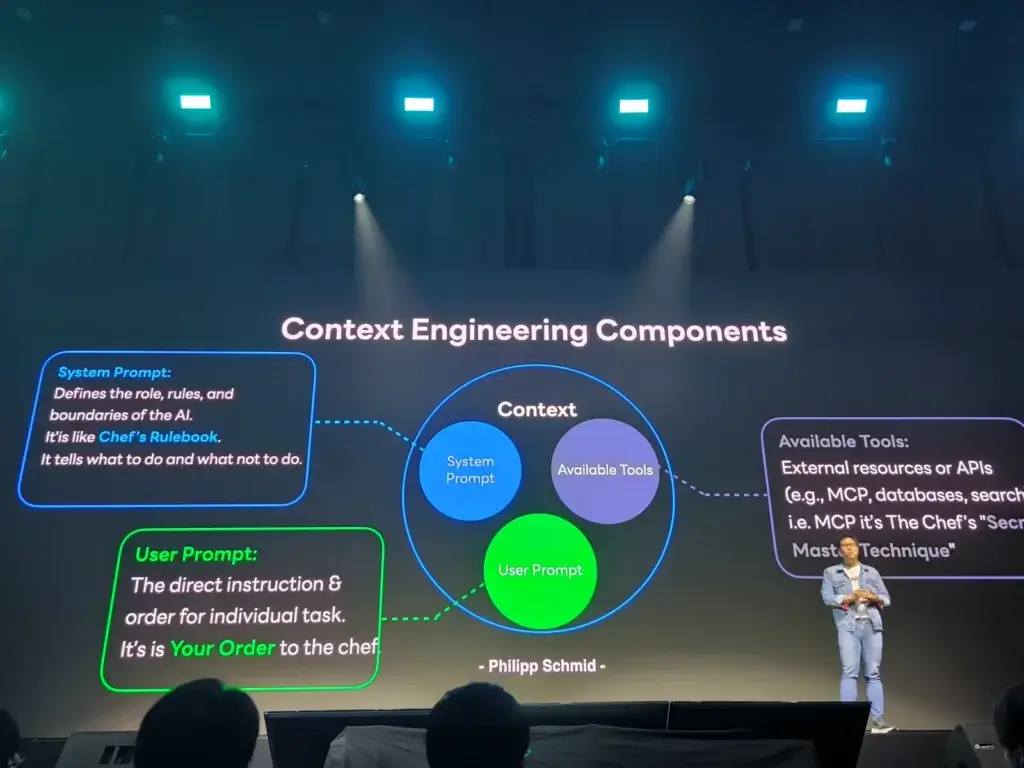

เมื่อ LLMs + Engineering Mindset จะได้เป็นตัว Context Engineering จากเดิม

- Prompt Engineering - สั่งงาน แล้วให้ AI มันใช้สิ่งที่มันอยู่จัดการไป

- Context Engineering - Prompt Engineering ที่เราใส่ Context อย่างพวก Environment / Resource / KM /Coding Standard เหมือนเรา onboarding พนักงานใหม่

ส่วนสำคัญของ Context Engineering มี 3 ส่วนที่สำคัญจากคุณ Philipp Schmid ดังนี้

- System Prompt (Chef’s Rulebook) - ทำให้ ai เข้าใจ บทบาท, เป้าหมาย, สภาพแวดล้อม หรือ รูปแบบในการพัฒนา / Coding Standard บอกภาพรวมได้

- Available Tools (Chef’s Secret Techniques & Tools) - เครื่องมือ MCP ที่ให้ AI สั่งงาน บอกเลยว่ามีอะไรบ้าง การมี MCP จะช่วยให้ AI ของเราประหยัด Cost ของ Token ในการคิดด้วย

- User Prompt (Order สั่งอะไรให้ชัดเจน) ต้องการอะไร แล้วมีผลลัพธ์ที่อยากได้อย่างไร

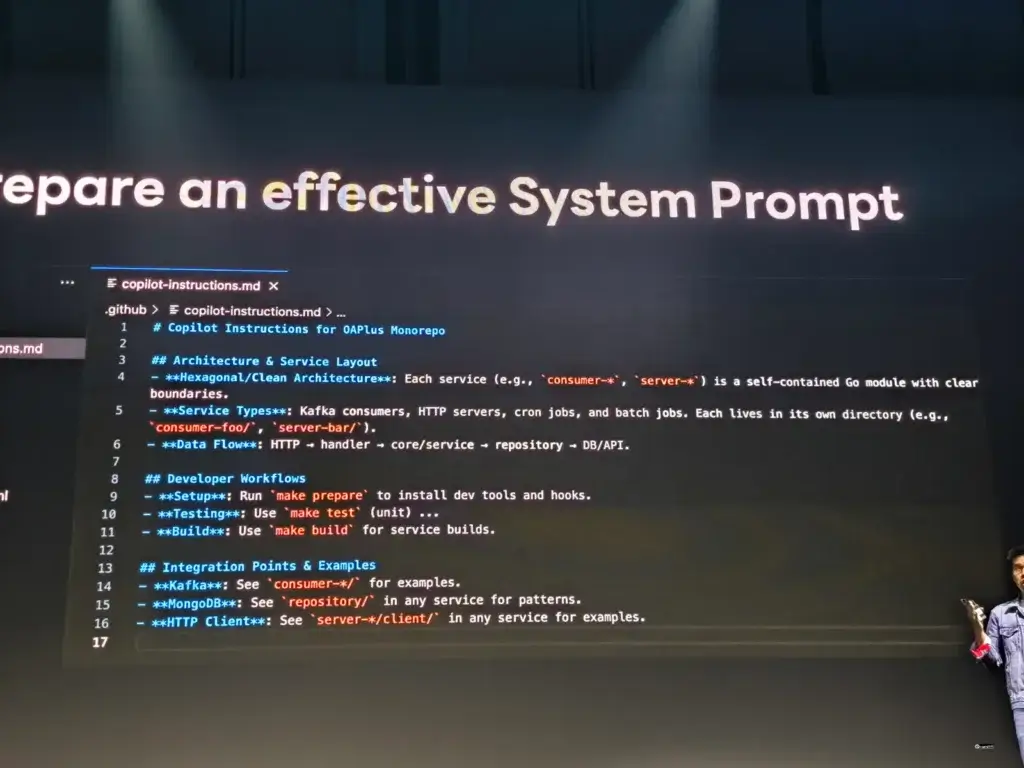

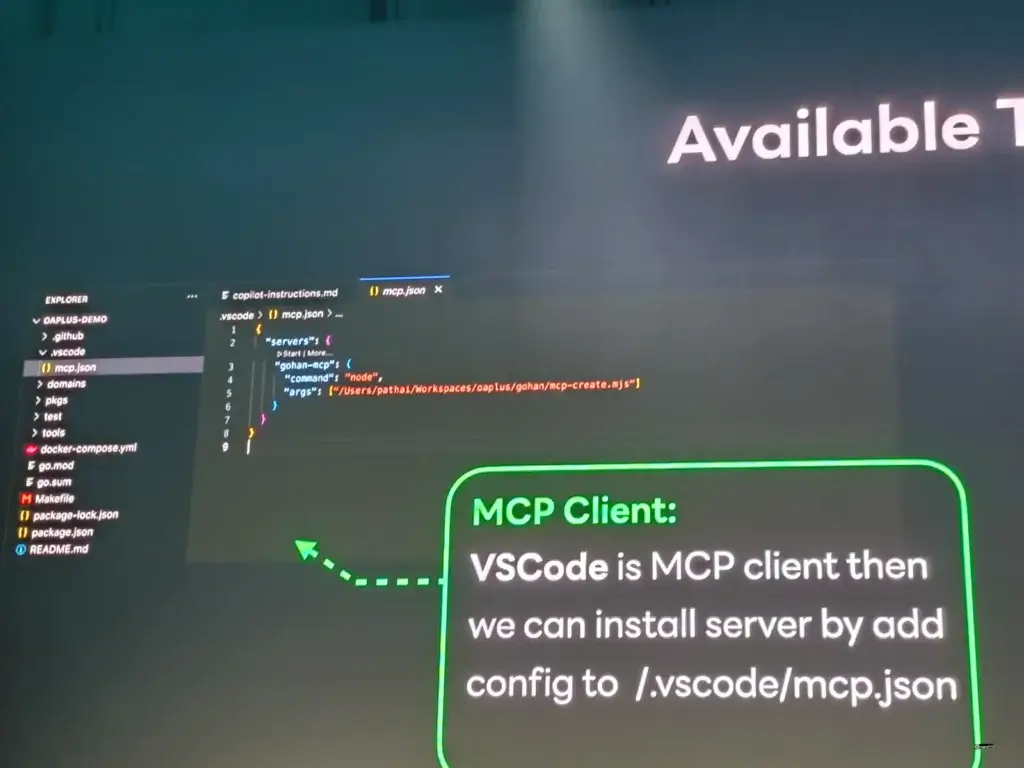

สำหรับใน Line เดิมแล้ว Engineering Mindset ได้พัฒนามาเป็น Internal Tools ชื่อ Gohan ที่ช่วยทำงานซ้ำๆ ให้เป็น Pattern เช่น การ Initial API หรือ Security เพื่อลองเอามาจัดการ Project ที่ใหญ่อย่างตัว Line OA Plus Platform ที่มีหลาย Microservice ตัวอย่าง Context Engineering โดยใช้ GitHub Copilot

- System Prompt (.github/copilot-instruction.md) บอก

- Architecture / Dataflow

- Developer Workflow

- Integration Point + Example

- Available Tools - Gohan ทำเป็น MCP Server แล้ว ใน VSCode จะกำหนดไว้ใน (.vscode/mcp.json)

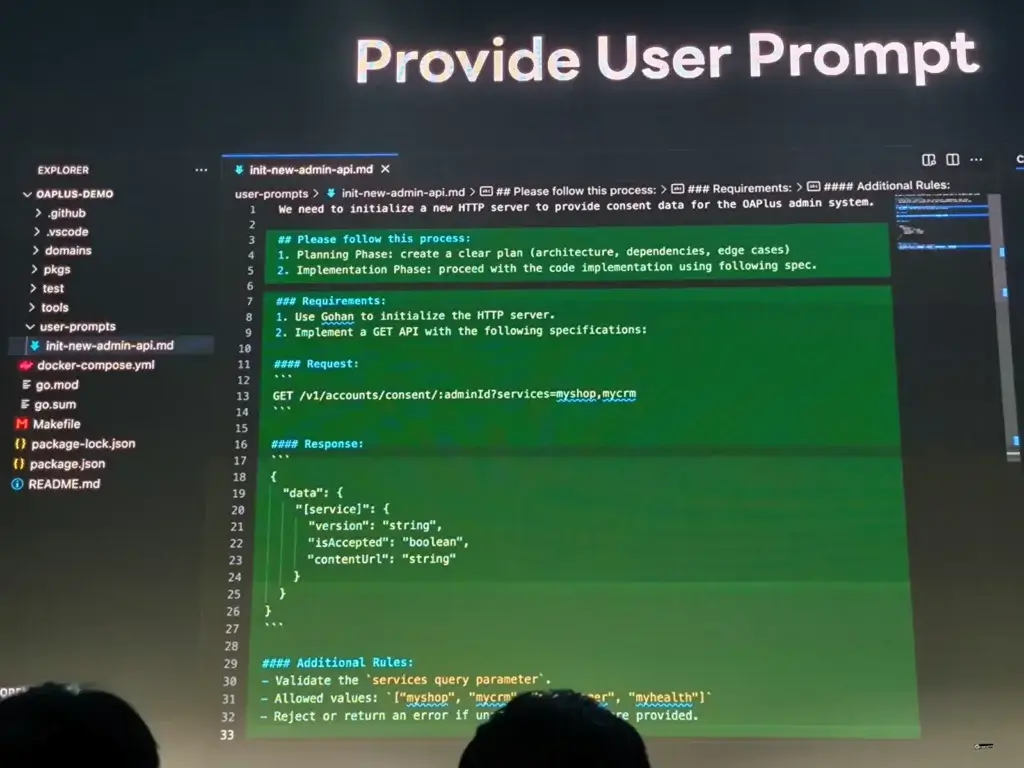

- User Prompt (user-prompts/your-reqirement.md)

- ที่เน้นย้ำบอกให้ทำตาม Process ให้ Planning / Requirement

- Sample Input + Output

- characteristic อย่างพวก Rate limit / Validation / Error handle / Http code

Resource: https://speakerdeck.com/linedevth/spec-spell-write-it-clearly-and-let-ai-do-the-magic (Slide)

Scouter: Unleashing the True Power Level of Web Performance

Speaker Charnsak Dangmanee

Speaker ทำงานในส่วนของ OA Plus Platform ที่จัดการพวก MyShop / MyCustomer / CRM

OA Plus เป็น Microservice ที่ข้างหลังมียุบยับเต็มไปหมด มี Feature ที่สำคัญ Chat / Broadcast / Rich Menu ซึ่งบางส่วนใช้ LIFF แล้วที่นี้ ในการเข้าถึงแต่ละ Service ของ OA Plus โดยเก็บในส่วน State

แล้วที่นี้เวลาเจอปัญหาว่าระบบมันช้า มัน Debug ยาก และแต่ถ้าระบบมันช้ามา ทำให้ User drop-off เสียโอกาศทางธุรกิจได้

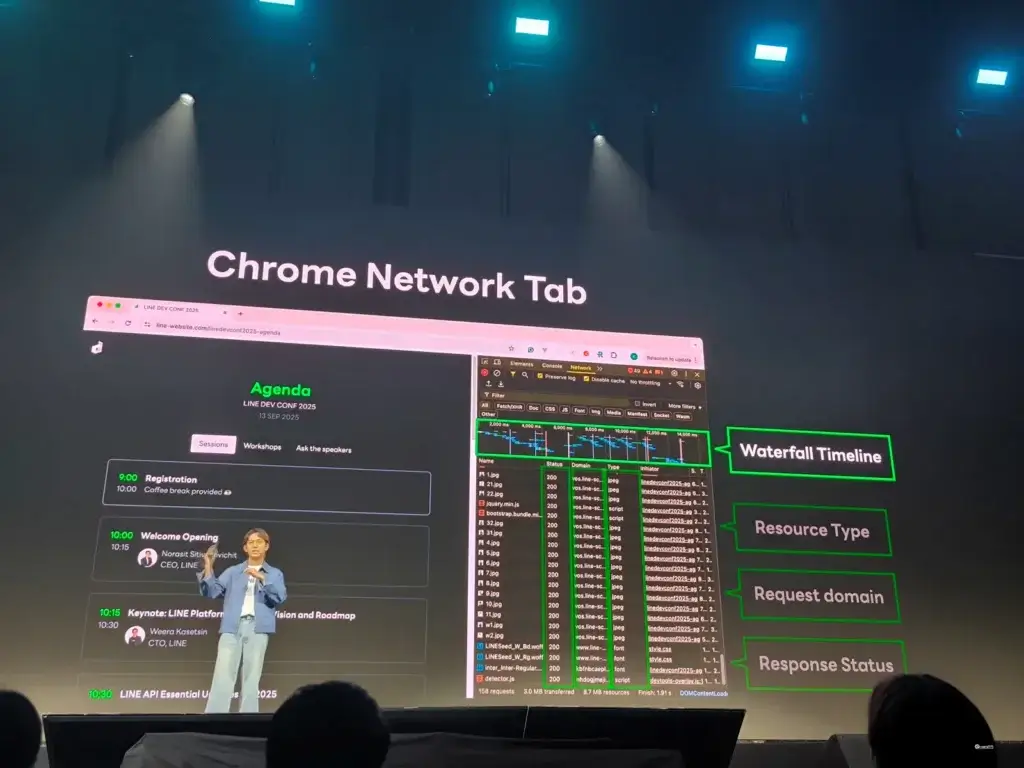

ถึงแม้ว่าปกติมี Chrome Developer Tools > Network แล้ว แต่ยังพบปัญหา 3 เรื่อง

- Overload – มี Request เยอะไปหมด แล้วหาจะเริ่มหาจากตรงไหน

- Overcomplicated – ข้อมูลที่ได้เอามาย่อยยาก เพราะมันเยอะ

- Overprocessed – การคิดตามว่า Request มันวิ่งไปทางไหนบ้าง หรือ การทำ Report สรุปต้งทำด้วยมือ

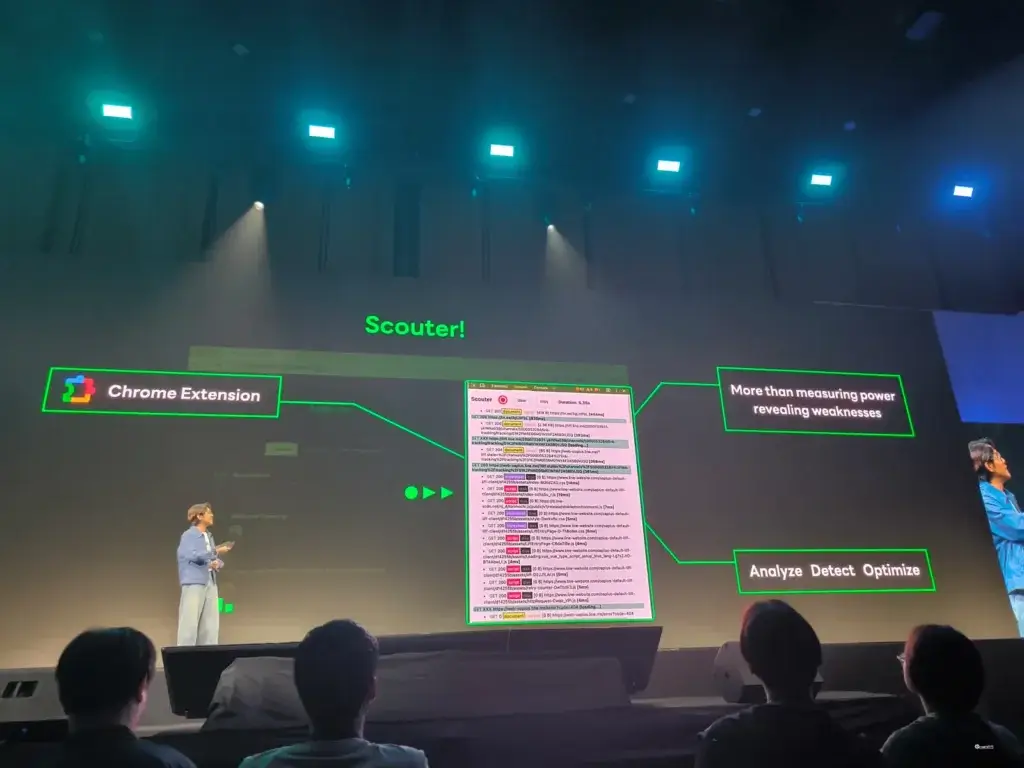

เลยเป็นที่มาของการทำ scouter ซึ่งเป็น Tools ที่ใช้งานภายในของ Line ที่มาแก้ปัญหาข้างต้น โดยมี Feature

- End-to-End Timing มีเวลาชัดเจนจองแต่ละ hop ของ request

- Visualize ให้ชัดเจน เป็นลำดับ ว่ามาจากไหน และดึงจากไหน Server หรือ Cache

- Easy to Use - มีปุ่มให้ Record / Clear / Report ได้เลยจากตัว Extension

พอได้ตัว Tools นี้เข้ามาตัว Developer เองก็ Happy มาขึ้น เพราะสามารถหาสาเหตุได้รวดเร็ว ว่าช้าจากส่วนไหน จากตัว Report + ไล่ Microservice Arch และไปปรับ Tune + วัดผลอีกรอบเทียบ

สิ่งที่ว้าวสำหรับ Tools ตอนนี้ในมุมคนฟังอย่างผมตอนแรกคิดว่าน่าจะใช้เวลาทำประมาณ 1-2 สัปดาห์ แต่จริงๆแล้วใช้เวลาเพียง 1 วันเท่านั้น โดยใช้ GitHub Copilot / VS Code โดยเทคนิคที่ใช้งานจะเป็นแบบบ้านๆ NEX (Next Edit Suggestion) chat ถามมัน หรือ ใส่ Comment ให้ AI มัน Auto Complete ให้นั้นเองครับ

Resource: https://speakerdeck.com/linedevth/scouter-unleashing-the-true-power-level-of-web-performance (Slide)

Build & Ship LINE MINI App with MINI AI Studio

Speaker Thanarat Ruangrat

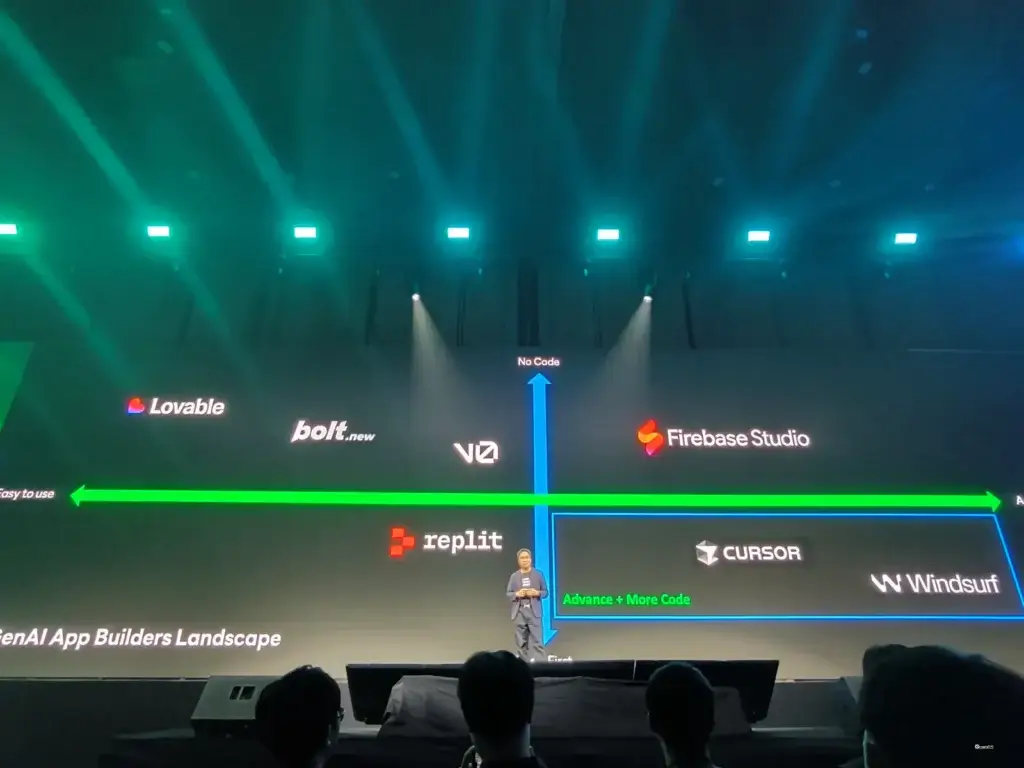

วิธีการส่งต่อความรู้ยุคแรกเริ่มจากการขีดเขียนบนกำแพง ต่อมาเป็นการจด ถัดมางานมีความซับซ้อนขึ้นทำเครื่องมือ Analytic Engine (1837) จากนั้นเริ่มมาเขียน Code + IDE จนสุดท้ายมาเป็นยุคของ AI และตอนนี้ Gen AI App หลายแบบตั้งแต่แบบพวก Low Code > Full Code

แต่ทว่า ถึงแม้ตอนนี้ AI เข้ามาช่วยได้เยอะแล้ว แต่งานส่วน Integration + DevOps ตัวอย่างลงสร้าง App ใน firebase studio AI Code 30% / Ops+Integrate 70%

เลยได้เป็น Idea ของการทำ MIN AI Studio ตัวที่ช่วยสร้าง Line Mini App จากการ Prompt โดยมี 3 Use Caseได้แก่

- Connect to data Source พวก google sheet

- Connector liff api อย่างการทำพวก loyalty program

ตัวอย่าง Prompt: Create Loyalty Program: scan QR to add point, show point history, show my profile picture, send message "You've XX points" - Mobile Testing เข้า Flow DevOps / Deploy auto พร้อมแยก Environment Dev / Test / Production

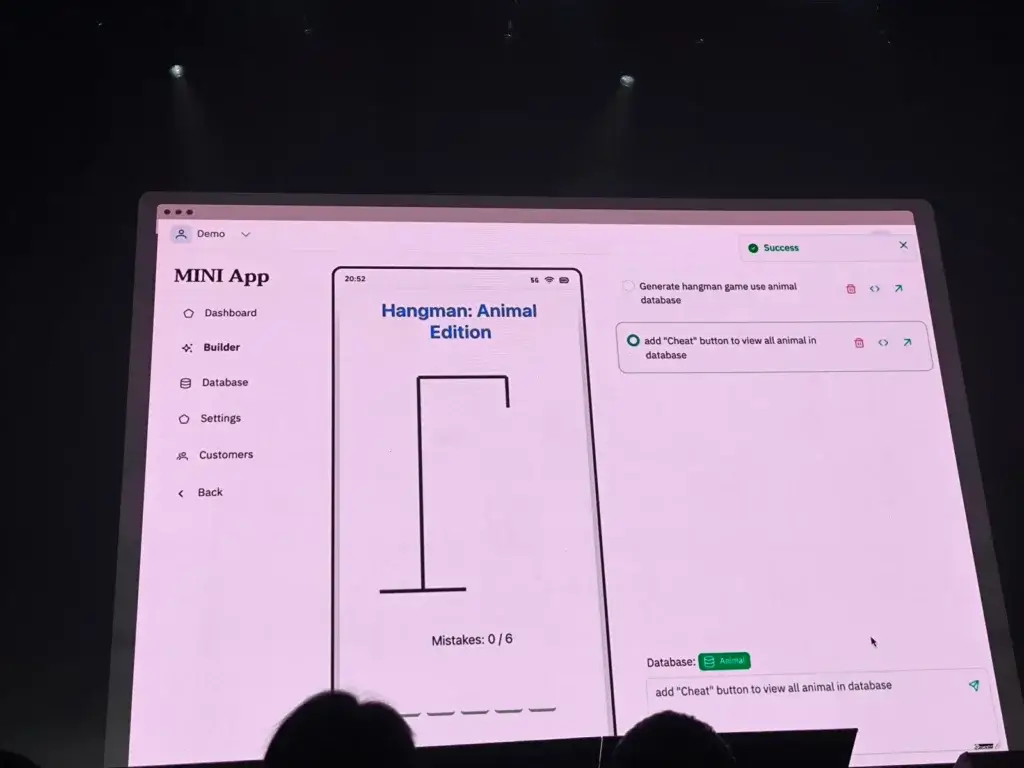

Demo ตัวอย่างมีทำ App Hangman / App สั่งของง่ายๆ โดยดึงข้อมูลจาก google sheet มาตั้งต้น และนำไปแสดงผลผ่าน liff api และ Auto Deploy

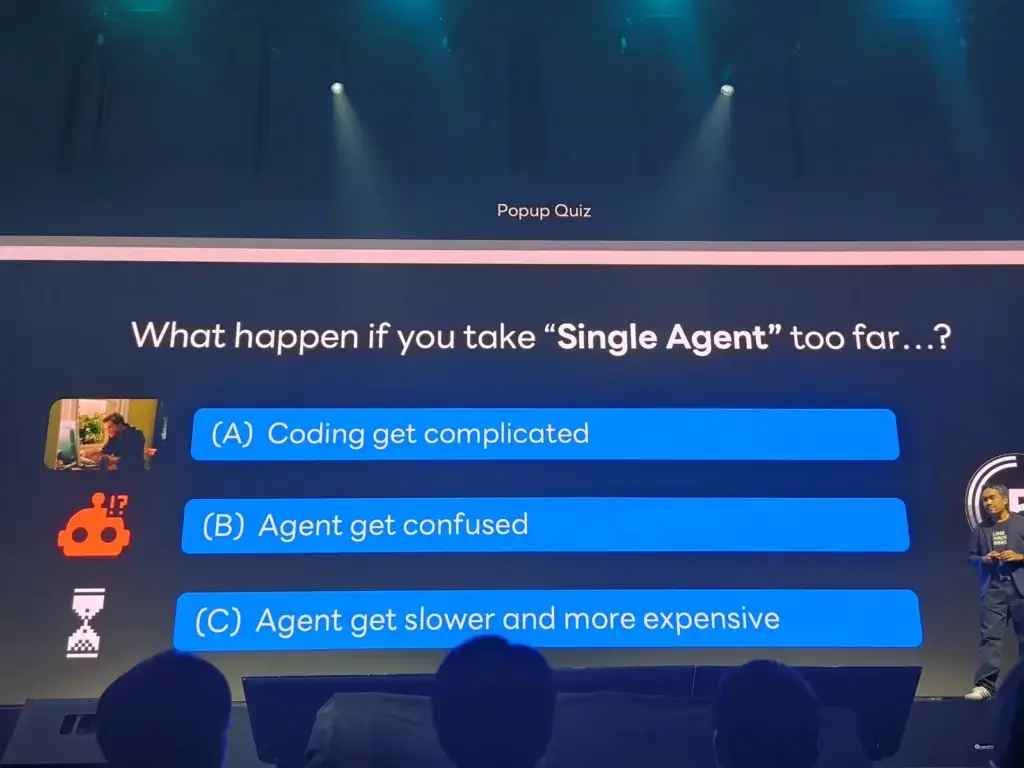

เบื่องหลังความฉลาดของ App ใช้ Multi Agent เพราะ Single มีปัญหา 3 อย่าง ตามนี้

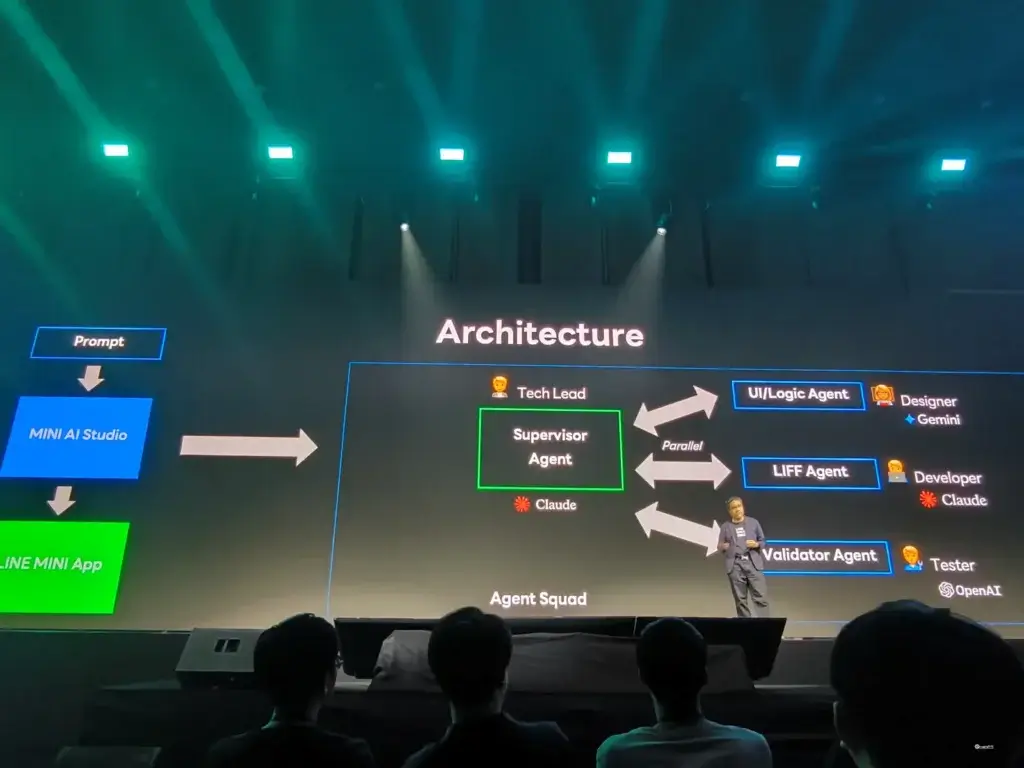

โดยการทำงานของหลาย Agent ใช้ตัว GitHub - awslabs/agent-squad เข้ามาจัดการ Agent โดยมี Supervisor Agent ทำหน้าที่เป็น Tech Lead เลือกงานที่เหมาะสมให้ Agent แต่ละตัว

- UI/ Logic Agent: ทำ UI / Navigation และพวก Business Logic

- LIFF Agent: ทำในส่วน Coding / LIFF API

- Validator Agent: ตรวจงาน และสั่งวนซ้ำจนผ่านเงื่อนไข

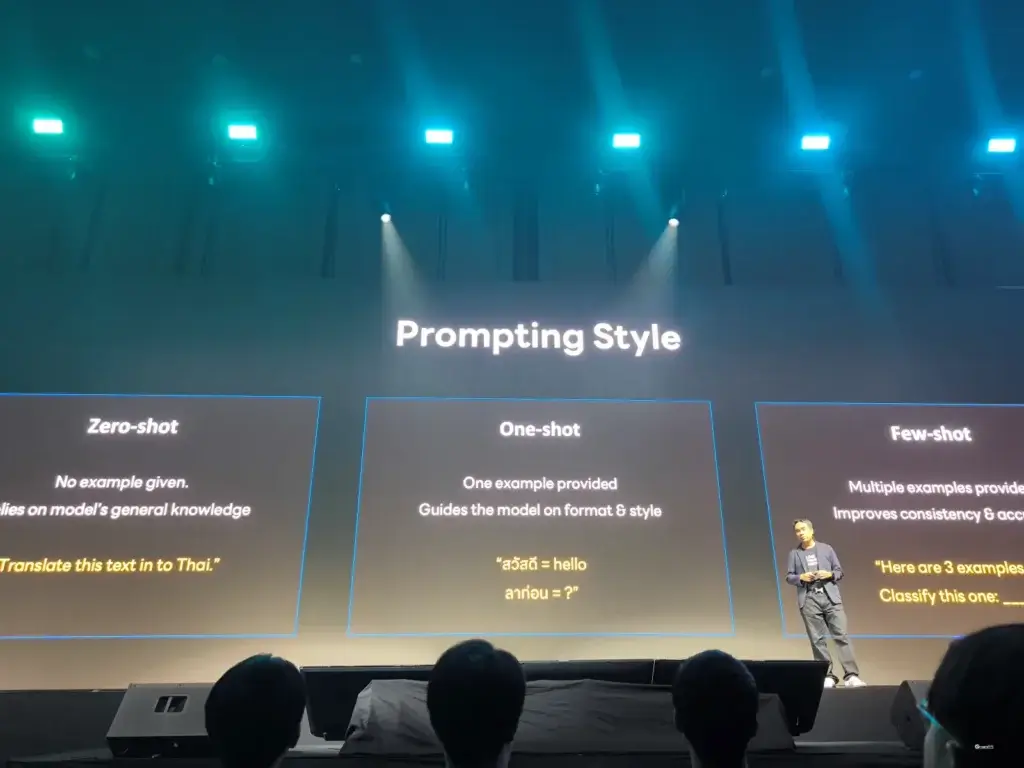

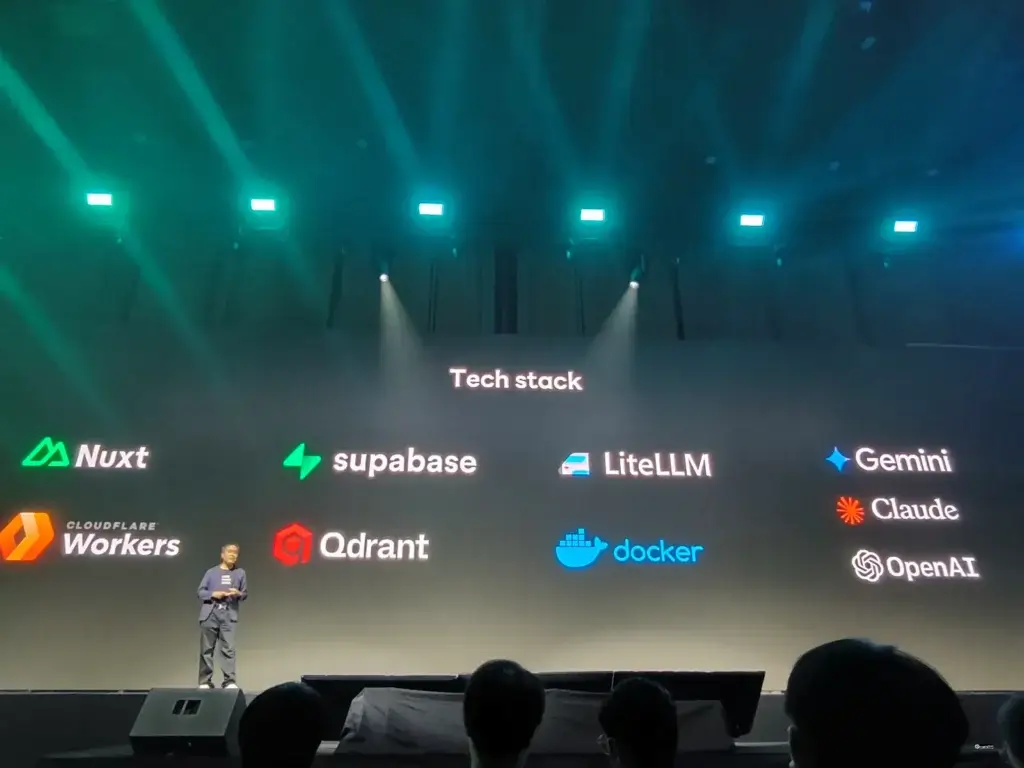

โดยที่ Agent แต่ละตัว Prompt โดยใช้เทคนิค few-shot ให้ตัวอย่างกับ LLM ก่อนทำงาน เพื่อให้ได้ประสิทธิภาพที่สูงสุด สุดท้าย Tech Stack ตามรูปเลย

การใช้ AI อย่าลืมเรื่อง Responsible AI Fairness, Safety, Privacy, Inclusiveness, Transparency และ Accountability

ตอนผมฟัง Session นี้ได้ Mini App เลย ส่งโพยหวยใต้ดิน 5555 และจากที่พัง Session นี้ เราต้องปรับแนวคิดการ App จากเดิมที่ Coding ก่อนก่อนมาเน้นเขียน Spec ให้เรียบร้อย จริงๆมันกลับไป Flow Software Engineering นะ User / SA คิดมาก่อนเลยว่าเรามี Data + Use Case ไหน และมาออกแบบจอ

สุดท้ายทำ Prompt และสั่งให้ IDE (Mini AI Studio) มันทำงาน และเราเข้า Flow Deploy > Review > Acceptance Criteria ไหม ? วนจนกว่าจะตรงความต้องการ

และ Hackathon ช่วยให้เราเจอความรู้ใหม่ๆ รวมถึง validate idea เรากับ mentor และเพื่อนที่แข่งด้วย

อยากลองใช้ close beta ติดต่อ link https://www.facebook.com/thanaratdev นะ

Resource: https://speakerdeck.com/linedevth/build-and-ship-line-mini-app-with-mini-ai-studio (Slide)

No REST, No Stress: Connect MCP with LINE Shopping

Speaker Woraphol Janekittanpaiboon

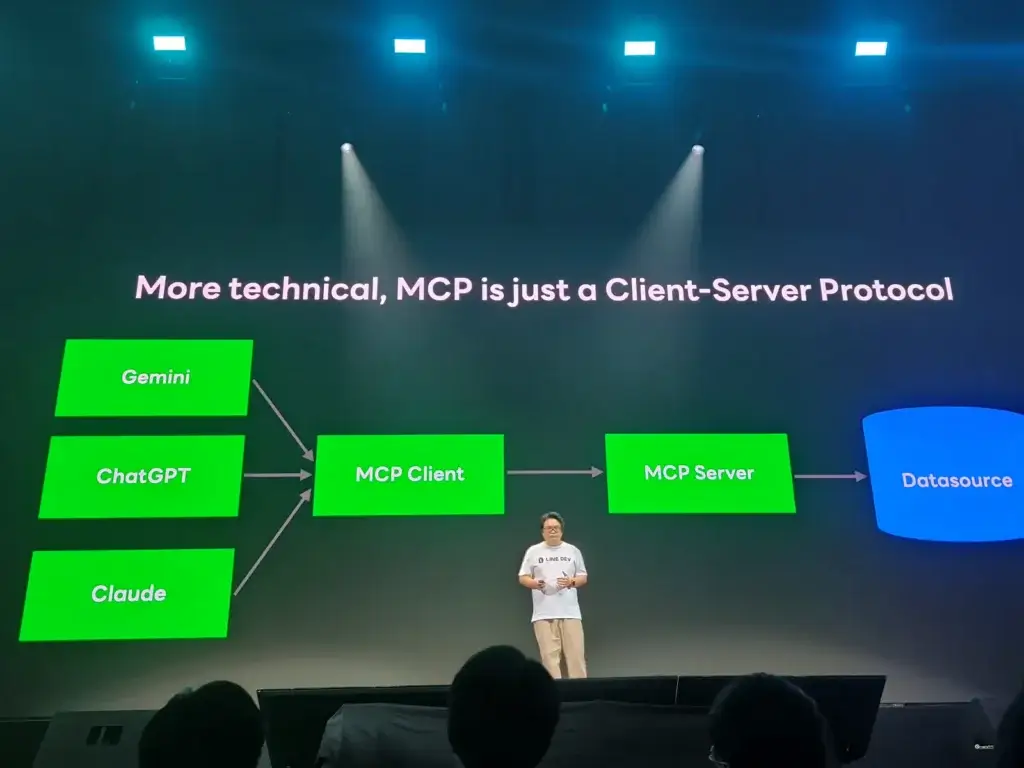

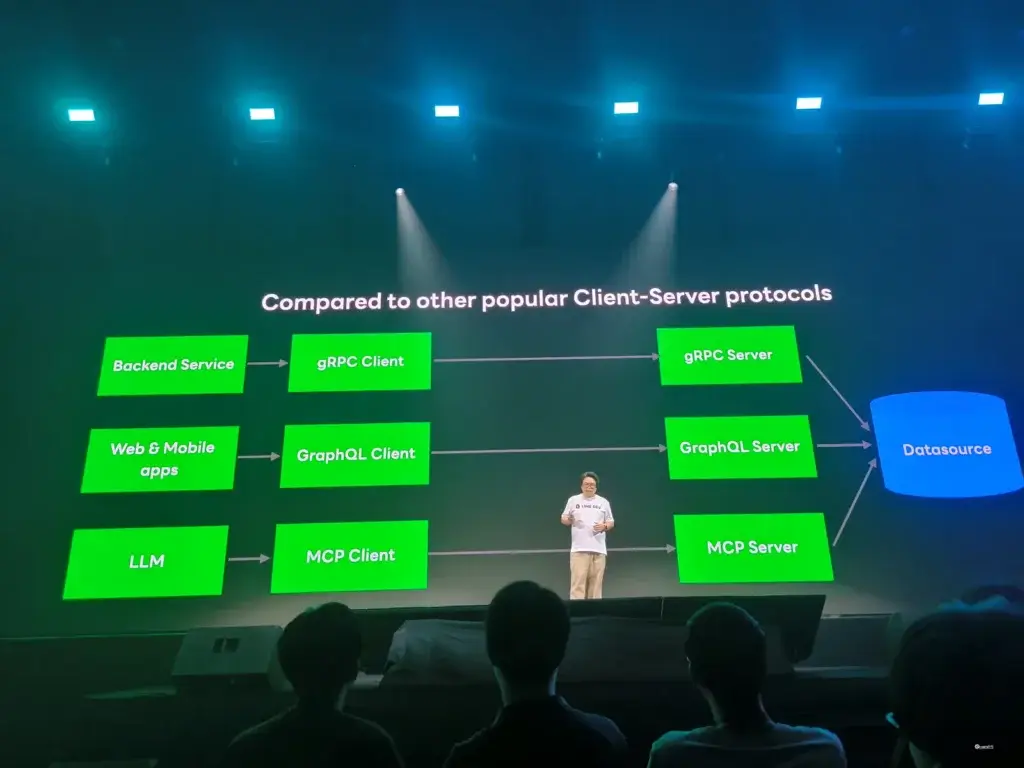

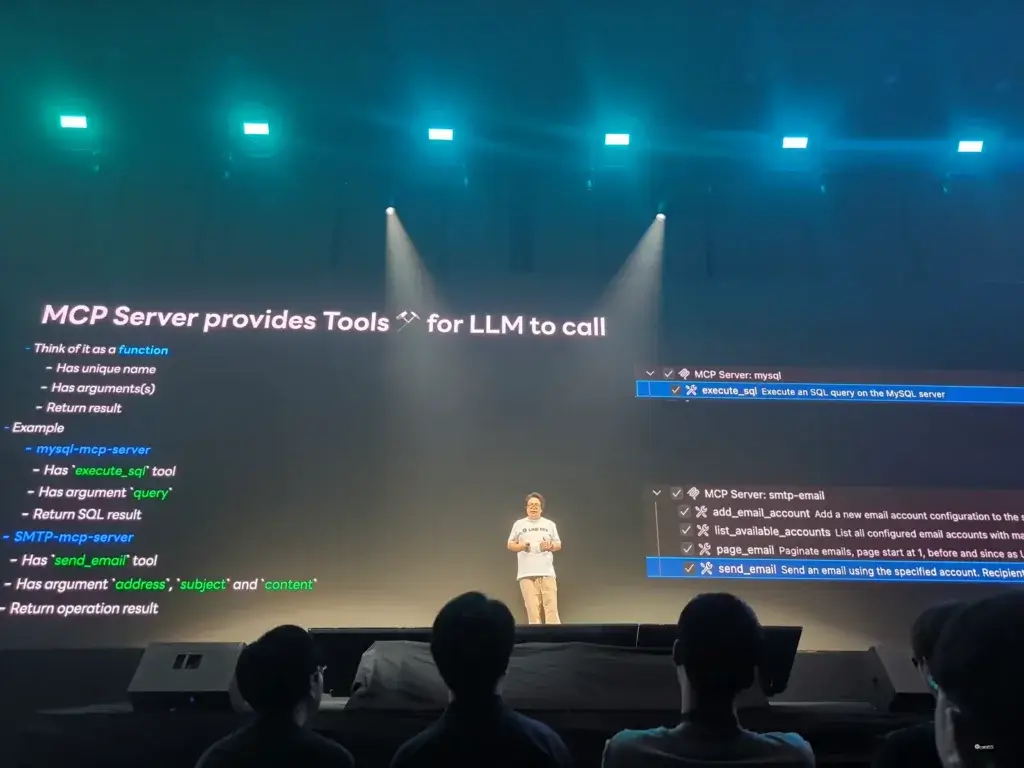

ปีที่แล้ว LLM มี feature ใหม่เข้ามาอย่างตัว Function Calling ที่ทำให้เข้าถึงข้อมูลล่าสุดได้จาก API ที่เตรียมไว้ แต่ความยาก LLM ChatGpt / Gemini / Claude มีเทคนิคเรียก Function ที่ต่างกัน

MCP (Model Comtext Protocol) เข้ามาแก้ปัญหานี้ทำเป็นตัวแบบ USB C เป็นภาษากลาง ให้ LLM เพื่อสั่ง resource รอบๆข้างได้ โดยมีภาพรวม - vs API แบบเดิมๆ

ถ้าลองเอามาใช้งานจริงหละ เราต้องรู้อะไรบ้าง Task ที่ต้องทำ + Function ที่ MCP เตรียมไว้ให้ ยกตัวอย่าง เช่น ถ้าต้องการคัดเลือกผู้เข้างาน Line จาก Id ที่หารด้วย 100 ลงตัว เวลาสั่่งให้ LLM ทำ มี Task ให้มันเรียนรู้

ข้อ 1-3 ใช้ MCP Server ของ DB MySQL / ส่วนข้อ 4 ใช้ MCP Server SMTP

- LLM - Get Table ที่เกี่ยวข้อง >> ใช้ mcp mysql function execute_sql

- LLM - Get Column ของ Table นั้นๆ >> ใช้ mcp mysql function execute_sql

- LLM - เอา Table และ Column มาเขียน Query และดึงข้อมูล >> ใช้ mcp mysql function execute_sql

- LLM - เอาข้อมูลที่ได้ ส่ง EMAIL ไป >> ใช้ mcp SMTP function send_email

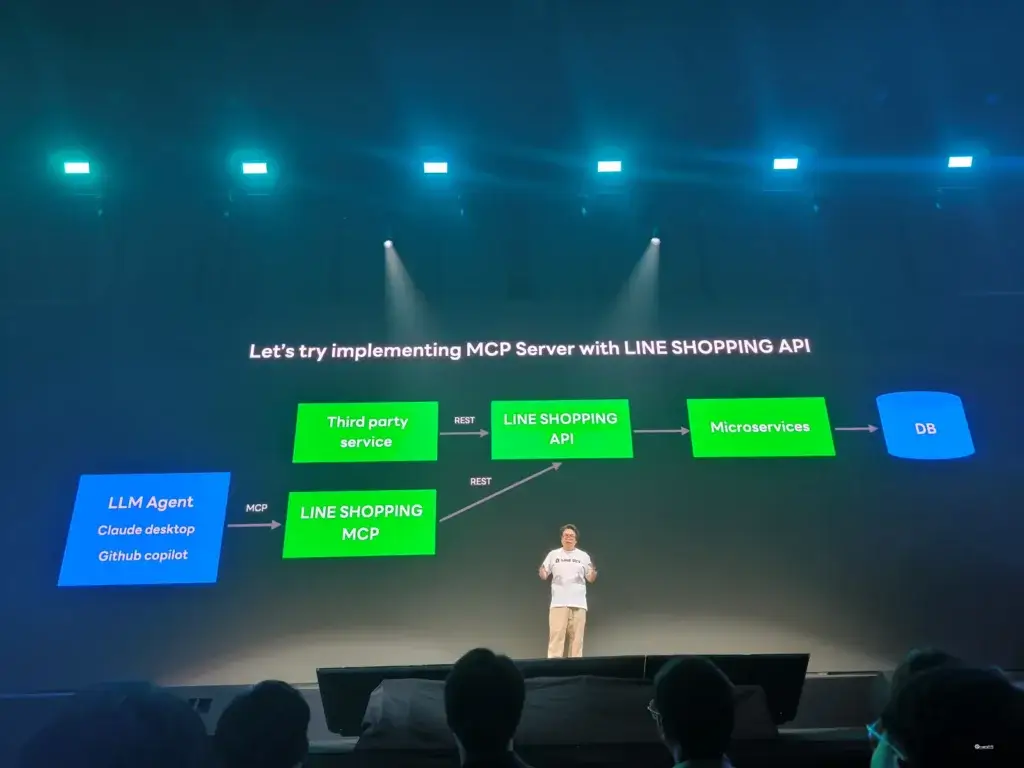

กลับมาที่ Line ตัว MCP เอามาใช้งานได้เหมือนกันนะ ตัวอย่างที่ Speaker ยกมาจะเป็นตัวของ line shopping api ที่ใช้ตัว python lib FastMCP มาอ่าน Spec OpenAPI แปลงเป็น MCP Server พร้อมใช้งาน

สำหรับ Code GitHub -LINE SHOPPING MCP API

Use Case การใช้ MCP Server อาทิ เช่น การ Migrate ข้อมูล Inventory ที่เก็บใน CSV (Filesystem MCP Server) เข้า Line Shopping ผ่านตัว MCP

นอกจากนี้ยังมีอีกหลาย Use Case ที่เราเอา MCP Server มาใช้ประโยชน์ได้ อาทิ เช่น

- Promote สินค้า ใช้

- Line Shopping MCP (get_all_products , get_all_order)

- Line Bot MCP Server (Broadcase_flex_message) - ทำรายงานของยอดขาย

- Line Shopping MCP (get_all_products , settlement_detail)

- Power Point MCP Server (create_presentation, add_slide .... ) - Update Stock จาก Invoice

- PDF MCP Server (read_file)

- Line Shopping MCP (adjust_inventory)

สุดท้ายตัว MCP ช่วยให้เราสามารถปรับให้ API เล็กใช้งานกับ AI ได้ และลด Cost ด้วย ไม่ต้องเอา AI มาจิ้มตรงทุก API

Resource: https://speakerdeck.com/linedevth/no-rest-no-stress-connect-line-shopping-with-mcp (Slide)

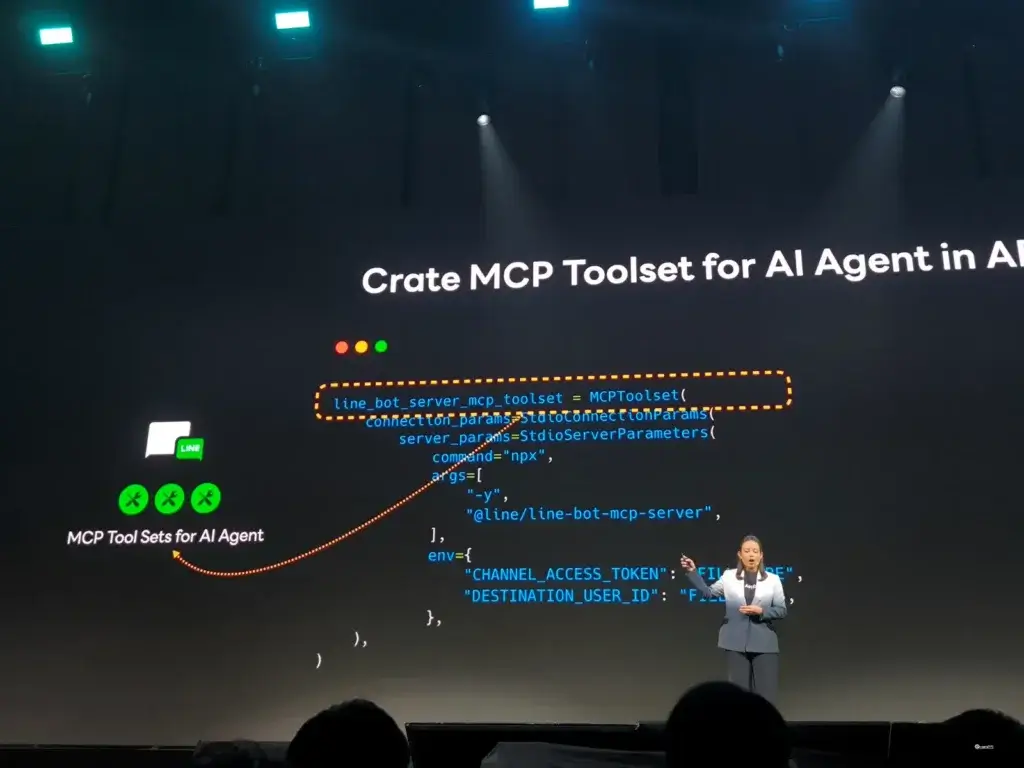

Unlocking the Power of AI Agents with LINE Bot MCP Server

Speaker Punsiri Boonyakiat

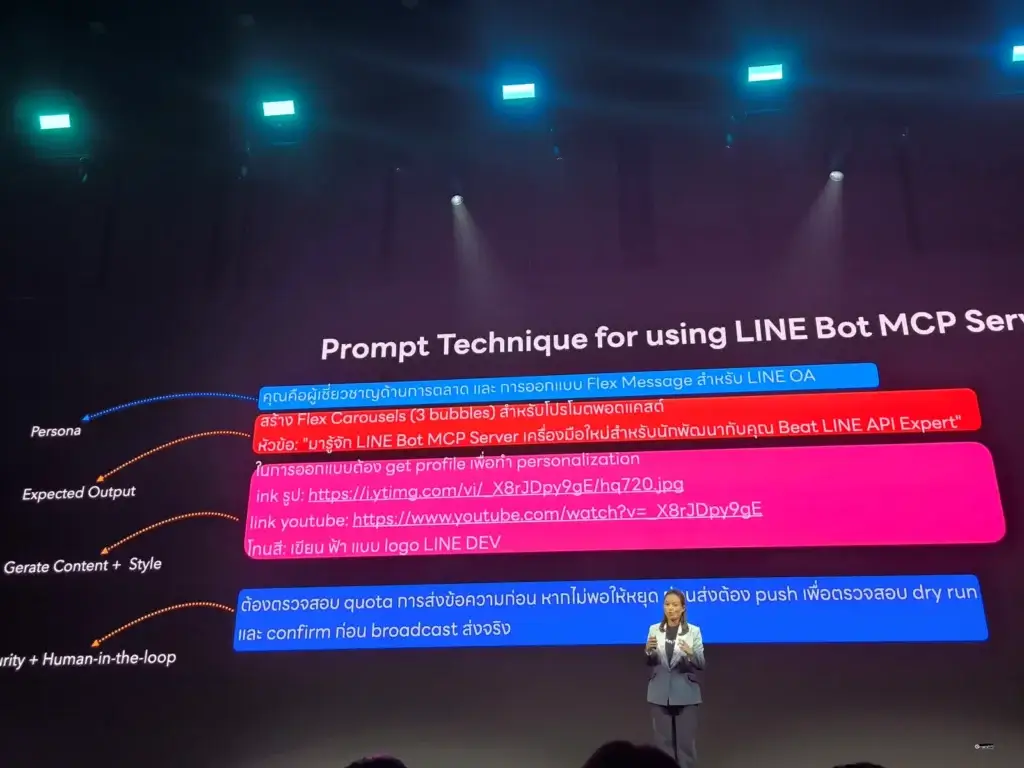

สำหรับ Session นี้จะเล่าปัญหาก่อนเลยว่า ถ้าเราต้องจัดการ Line OA ขึ้นมา เราต้องมาคิดหลายเรื่อง ได้แก่ Check Message Quota / Design คิดออกแบบ Flex Message / Rich Menu Operation และ Broadcast Message เป็นต้น

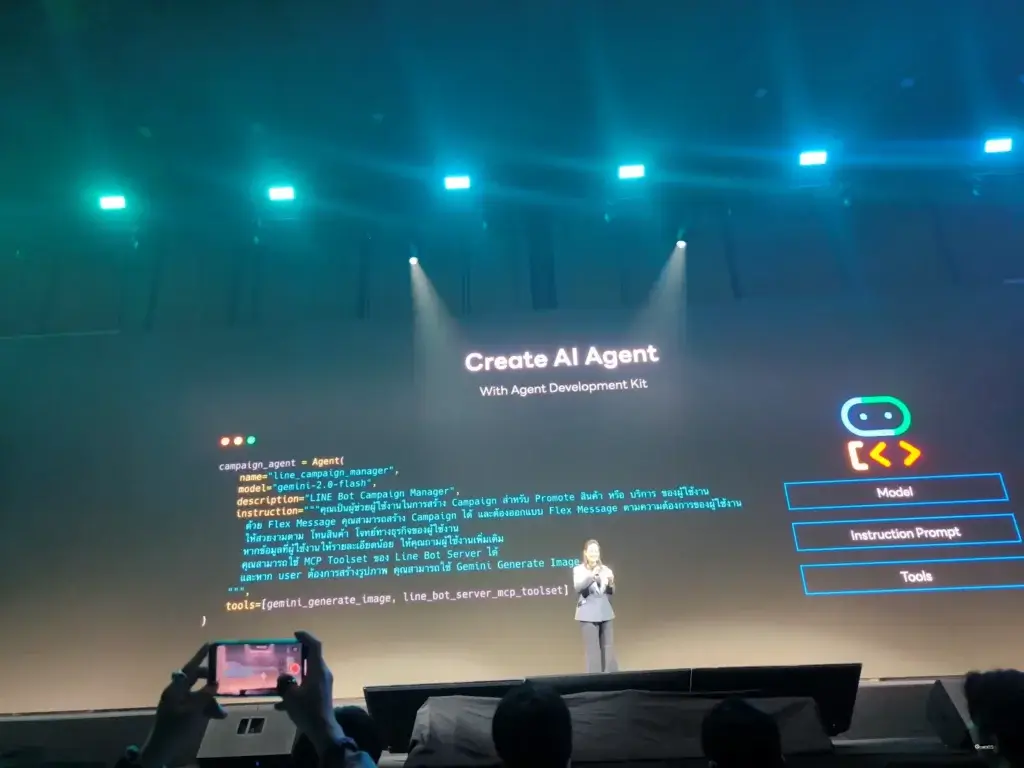

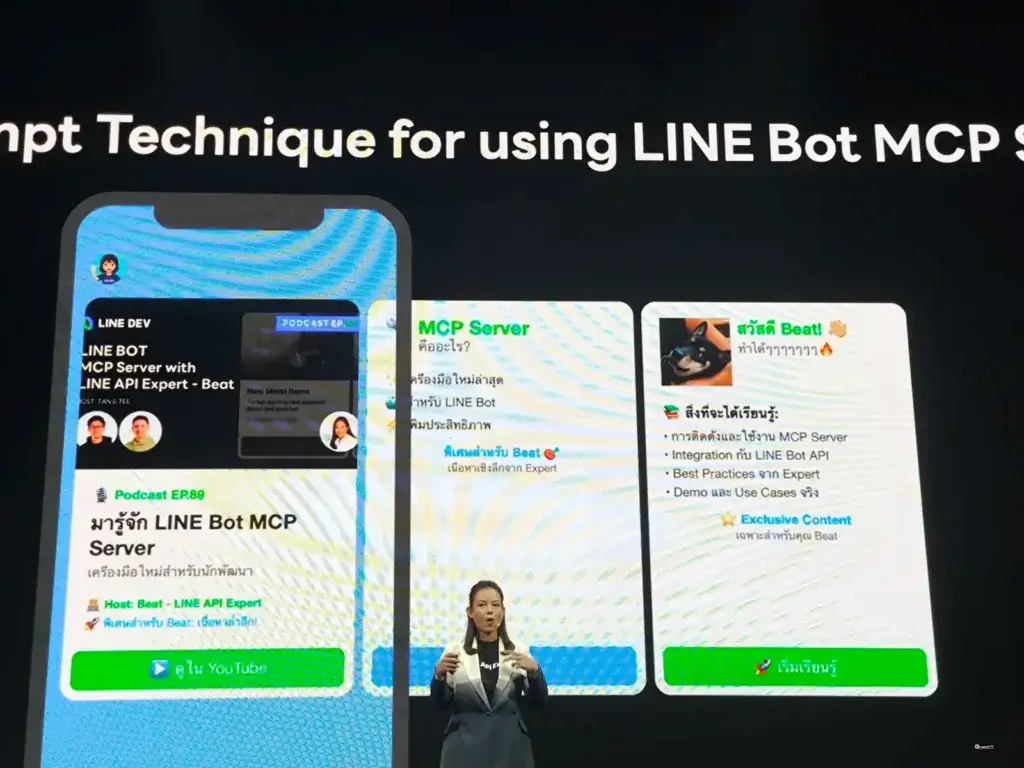

ซึ่งงานทั้งหมด เราต้องเข้าไปไล่กดเมนูจัดการ + คิด หรือไปจ้างคนมาดูเพิ่ม แต่งานพวกนี้จะง่ายขึ้น เพราะเราสามารถสั่งได้โดยการ Prompt ผ่านตัว MCP client หลายตัว อบ่าง Gemini cli / Claude desktop / vs code เป็นต้น และให้ตัว Line Bot MCP Server ช่วยเอามาเชื่อม API Line ได้ โดยตอนนี้ 10 API ที่ทำได้แล้ว

- Get message quaota

- Get user profile

- Push / broadcast message

- Push broadcast flex message หนือ flex casual (ตารางสรุปกิจกรรม)

- อีก 5 อัน Get / Set / list / Create / Delete Rich menu

ขั้นตอนการใช้งาน

- Create Line OA

- Enable msg api

- Config AI Agent เอา Channel Access token กับ Destination user id ไปเชื่อม agent อย่าง Claude desktop

- ลองใช้งานได้เลย

นอกจากนี้อีกเทคนิคที่ช่วยให้ LLM + MCP ทำงานได้เต็มที่ การเขียน Prompt นั้นเอง โดยมี 4 ส่วน Content Generation (LLM) / Tools (Line Bot MCP) / Style / Security จากตัวอย่างมีครบเลย

ส่วน Style + Security บอกว่า Role อะไร เราต้องการอะไร เรียกใช้ API ไหน Get User Profile + Push Message ผลลัพธ์อย่างไร รวมถึงการตรวจสอบ API Check Message Token + สุดท้าย มี Human In Loop Confirm ก่อนส่ง

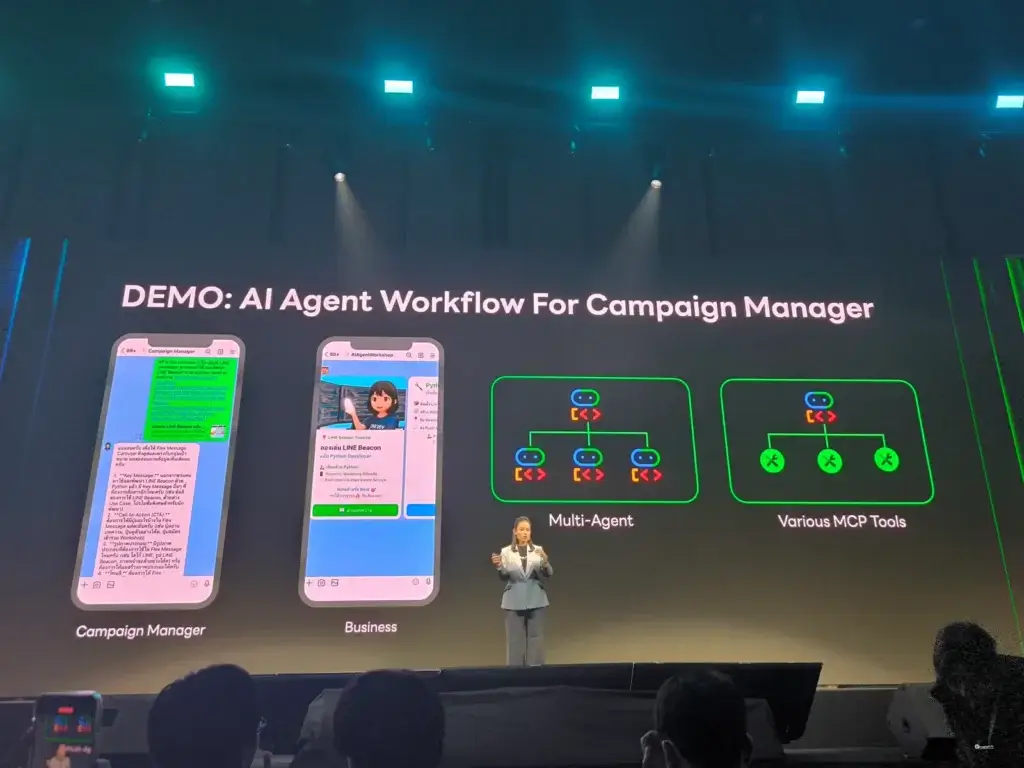

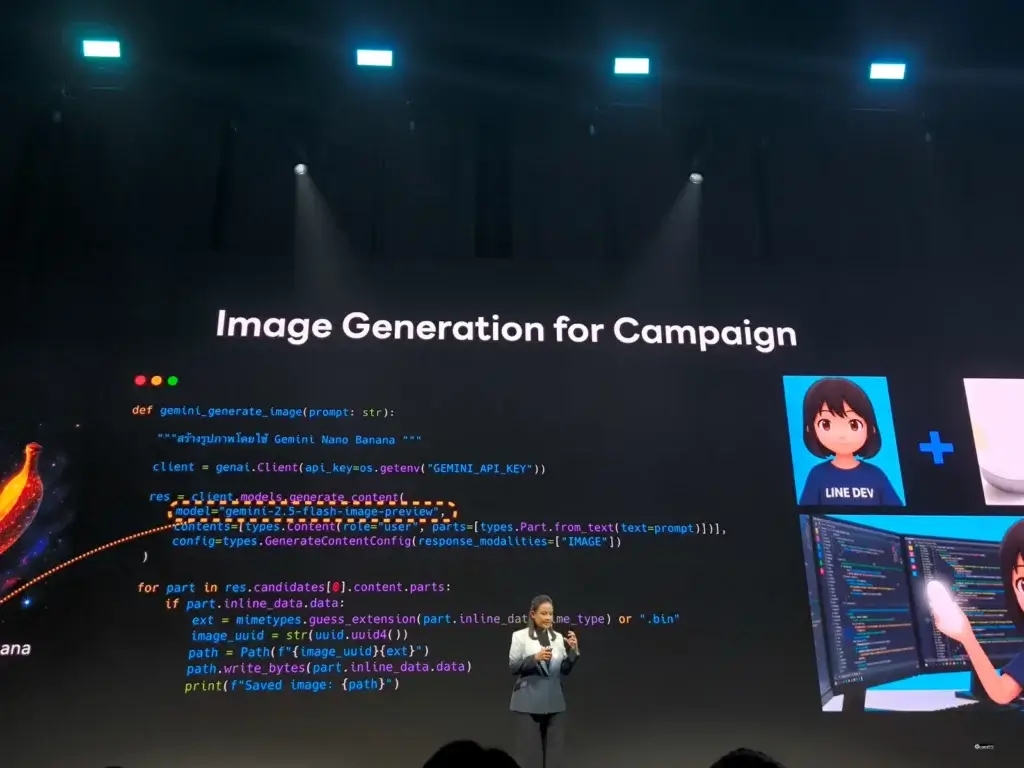

จากนั้นเป็นการ Share Use Case Marketing Campain Concept A2A ของทาง Google มาใช้ (ผมมีจด Blogนะ) โดยเริ่มจาก user prompt ไป จากนั้นเป็นหน้าทีของ 2 Agent ทำงานร่วมกัน

- Agent Generate Image ใช้ Gemini

- Agent Line Bot MCP ที่หน้าที่ Get User Profile + Generate Flex Message

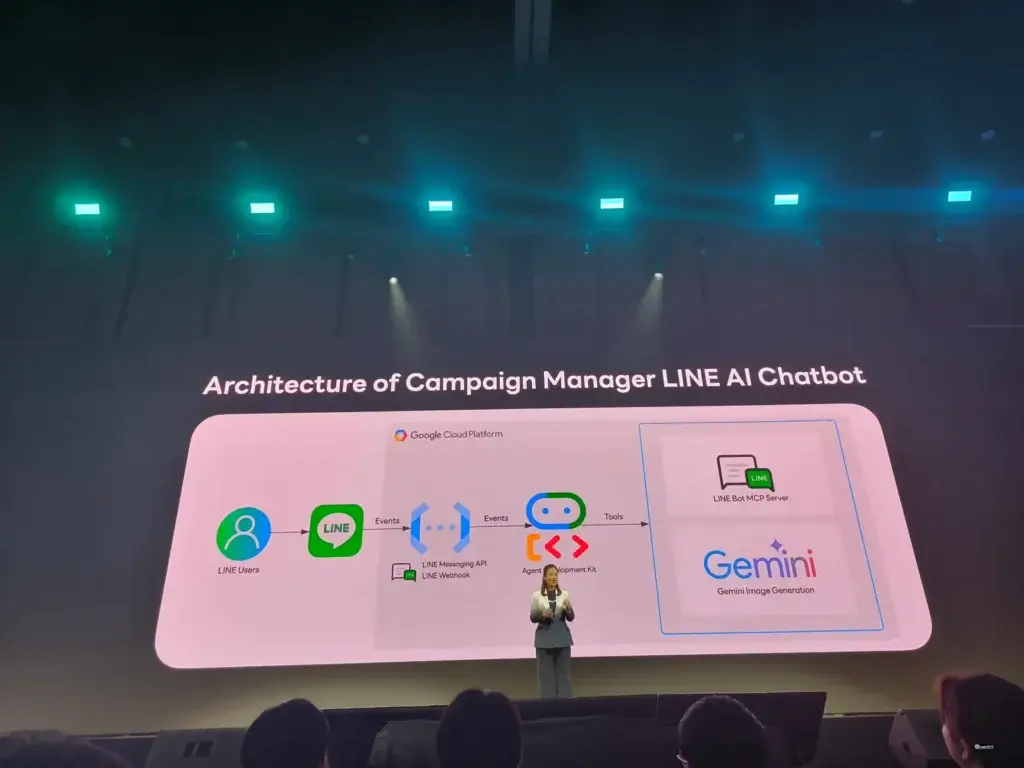

ทั้งหมดมี Architecture + Demo ตามนี้ครับ

ลองหาดูมี medium สอนด้วย เชื่อมต่อ AI ของคุณกับ LINE ด้วย Official MCP Server — ก้าวแรกสู่ AI Agent Interaction ด้วย Claude Desktop และ Gemini | by Punsiri Boonyakiat | LINE Developers Thailand | Medium

Resource: https://speakerdeck.com/linedevth/unlocking-the-power-of-ai-agents-with-line-bot-mcp-server (Slide)

Hackathon Final 3 Team: Cast Your Vote

สำหรับ Session ให้ทีมผ่าน Final สุดท้าย 3 ทีมมานำเสนอ App ที่สร้างบน Platform Line Mini App ครับ โจทย์เป็นตัว App สร้าง Card อวยพรในงานต่างๆ โดยทั้ง 3 ทีมใช้ AI หมดเลย โดย แต่ใช้ในมุมไหนนี่แหละครับลองมาฟังกันครับได้ Idea ดีครับ อาทิ เช่น

- อวยพรแบบ Random เราไม่รู้ว่าจะส่งอะไรไปให้ แต่เป็นคำที่ดีแน่นอน และผมชอบ Idea ข้างหลังดีนะ มีฟรี 3 ครั้ง/วัน ถ้าอยากได้ Card สวยๆ หรือ ส่งได้มากขึ้น เข้า Model ซื้อ Package และเห็น Line Mini App + Supabase (Backend as A Service) + Open AI

- อีกอันเป็น app ที่ low code จาก mini ai studio (ของ session ก่อนหน้า) สร้าง app จาก prompt เป็นอีก Use Case นึง

- ส่ง emoji ให้ AI มัน gen card + คำอวยพร อันนี้เลือกใน AI ผ่านตัว OpenRouter

จบงานรอแลกเสื้อครับ สำหรับผมมันเป็นงานแรกที่คนอยู่จนท้ายงานกันเยอะมาก และข้าวอร่อยด้วย ที่สำคัญได้ Idea อะไรหลายอย่างเลย เสียดายกดบัตร workshop ไม่ทัน และสรุปมีใน Page LINE Developers Thailand เผื่อผมจดผิดไม่เหมือน Official 555

จากคนที่ไม่ได้ได้ใช้ Service สาย Dev ของ Line สักเท่าไหร่ แต่อยากให้มี Package แบบ Line Notify กลับมานะ จ่ายเพื่อรับอย่างเดียว ^__^

Blog ท่านอื่น

Reference

Discover more from naiwaen@DebuggingSoft

Subscribe to get the latest posts sent to your email.